Mit der Image Analyst-Lizenz verfügbar.

Das Werkzeug Genauigkeit für Objekterkennung berechnen berechnet die Genauigkeit eines Deep-Learning-Modells, indem die mit dem Werkzeug Objekte mit Deep Learning erkennen erkannten Objekte mit Referenzdaten verglichen werden. Die Genauigkeit eines Modells wird anhand von vier Genauigkeitskennwerten bewertet: Die durchschnittliche Genauigkeit (Average Precision, AP), die F1-Punktzahl, der COCO-Durchschnitt des Average-Precision-Werts (mAP) und die Genauigkeit x Recall-Kurve.

Interpretieren von Modellergebnissen

Wenn Sie die Ausgaben aus dem Werkzeug Genauigkeit für Objekterkennung berechnen verstehen möchten, müssen Sie zunächst die Ergebnisse des Erkennungsmodells verstehen.

Ein Modell kann im Zuge der Objekterkennung und -klassifizierung eine positive oder negative Klasse vorhersagen. Diese Vorhersagen können wahr oder falsch sein. Wenn zum Beispiel Bäume in einem Bild erkannt werden, kann die positive Klasse "Baum" sein. Die entsprechende negative Klasse wäre "Kein Baum". Eine Vorhersage ist wahr, wenn sie richtig ist. Eine Vorhersage ist falsch, wenn sie nicht zutrifft.

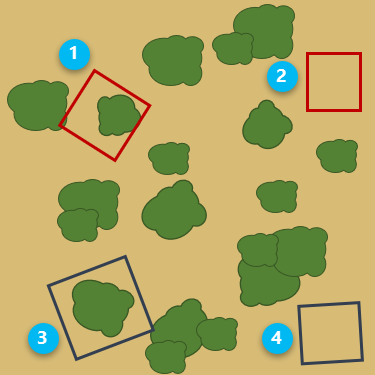

In der Abbildung unten zeigen die roten umgebenden Rechtecke eine positive Vorhersage an. Hier hat das Modell vorhergesagt, dass ein Baum vorhanden ist. Die dunkelblauen umgebenden Rechtecke weisen auf eine negative Vorhersage hin, bei der das Modell vorhergesagt hat, dass kein Baum vorhanden ist.

Die einzelnen umgebenden Rechtecke werden in der folgenden Tabelle erläutert.

| Nummer | Beschreibung |

|---|---|

| True positive: Das Modell sagt voraus, dass ein Baum vorhanden ist und das ist richtig. |

| False positive: Das Modell sagt voraus, dass ein Baum vorhanden ist und das ist falsch. |

| False negative: Das Modell sagt voraus, dass kein Baum vorhanden ist und das ist falsch. |

| True negative: Das Modell sagt voraus, dass kein Baum vorhanden ist und das ist richtig. |

Genauigkeits-Ausgaben

Die Genauigkeit eines Objekterkennungsmodells hängt von der Qualität und der Anzahl der Trainingsgebiete, den Eingabe-Bilddaten, den Modellparametern und dem Anforderungsschwellenwert für die Genauigkeit ab.

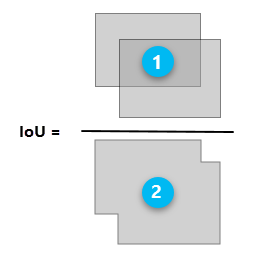

Das IoU-Verhältnis wird als Schwellenwert verwendet, um zu ermitteln, ob ein vorhergesagtes Ergebnis ein True Positive oder ein False Positive ist. Das IoU-Verhältnis ist die Überlappung zwischen dem umgebenden Rechteck um ein vorhergesagtes Objekt und dem umgebenden Rechteck um die Referenzdaten.

| Nummer | Beschreibung |

|---|---|

| Die Überschneidungsfläche des vorhergesagten umgebenden Rechtecks und des umgebenden Rechtecks der Referenzdaten |

| Die Gesamtfläche des vorhergesagten umgebenden Rechtecks und des umgebenden Rechtecks der Referenzdaten in Kombination |

Das Werkzeug Genauigkeit für Objekterkennung berechnen generiert eine Ausgabe-Genauigkeitstabelle und einen Bericht zur Ausgabe-Genauigkeit. Diese enthalten jeweils eine Reihe von Genauigkeitskennwerten, die vom IoU-Schwellenwert und der Leistung des Modells abhängen. Die Genauigkeitskennwerte werden nachfolgend beschrieben:

- Precision: Precision ist das Verhältnis der Anzahl von True Positives zur Gesamtzahl der Vorhersagen. Wenn das Modell z. B. 100 Bäume erkannt hat und 90 korrekt gewesen wären, beträgt die Genauigkeit 90 Prozent.

Precision = (True Positive)/(True Positive + False Positive) - Recall: Recall ist das Verhältnis der Anzahl von True Positives zur Gesamtzahl der realen (relevanten) Objekte. Wenn das Modell z. B. 75 Bäume auf einem Bild korrekt erkennt und es tatsächlich 100 Bäume auf dem Bild gibt, beträgt der Recall 75 Prozent.

Recall = (True Positive)/(True Positive + False Negative) - F-Maß: Das F-Maß (auch "F1-Score") ist ein gewichteter Durchschnitt von Genauigkeit und Recall. Die Werte liegen zwischen 0 und 1, wobei 1 für die höchste Genauigkeit steht.

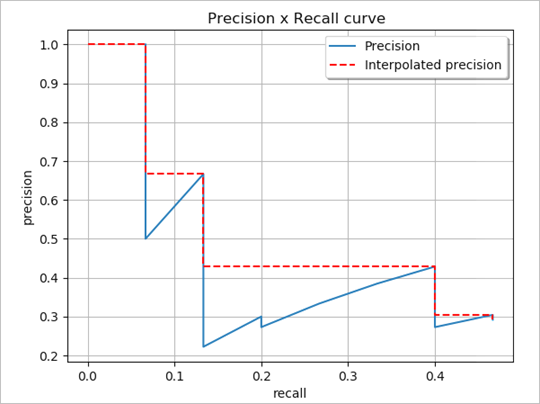

F-Maß = (Precision × Recall)/[(Precision + Recall)/2] - Precision-Recall-Kurve: Darstellung von Precision (y-Achse) und Recall (x-Achse); dient zur Bewertung der Leistung eines Objekterkennungsmodells. Ein Modell gilt dann als ein gutes Vorhersagemodell, wenn die Precision bei zunehmendem Recall hoch bleibt.

Darstellung der Precision-Recall-Kurve (Padilla et al, 2020) - Average Precision: Die durchschnittliche Precision (Average Precision, AP) entspricht der durchschnittlichen Genauigkeit über alle Recall-Werte zwischen 0 und 1. Die AP kann als Fläche unter der Precision-Recall-Kurve interpretiert werden. Durch Interpolation über alle Punkte kann die AP als die Fläche unter der Kurve der Precision-Recall-Kurve interpretiert werden.

- Mean Average Precision: Die Mean Average Precision (mAP) entspricht der durchschnittlichen AP über mehrere IoU-Schwellenwerte hinweg. So entspricht z. B. mAP@[0.5:0.05:0.95] dem AP-Wert für IoU-Verhältnisse zwischen 0,5 und 0,95 in Schritten von 0,05, gemittelt über alle Klassen.

Referenzen

Hui, Jonathan. "mAP (mean Average Precision) for Object Detection." Post vom 6. März 2018 bei Medium. https://medium.com/@jonathan_hui/map-mean-average-precision-for-object-detection-45c121a31173.

Padilla, Rafael, Sergio L. Netto, und Eduardo A. B. da Silva. "A Survey on Performance Metrics for Object-Detection Algorithms." 2020 International Conference on Systems, Signals and Image Processing (IWSSIP), 237-242 (2000).

"Detection Evaluation." COCO Common Objects in Context, abgerufen am 15. Oktober 2020, https://cocodataset.org/#detection-eval.