| Beschriftung | Erläuterung | Datentyp |

Vorhersagetyp | Gibt den zu verwendenden Operationsmodus an. Das Werkzeug kann ausgeführt werden, um ein Modell ausschließlich für die Bewertung der Performance zu trainieren, Features vorherzusagen oder eine vorhergesagte Oberfläche zu erstellen.

| String |

Eingabe-Trainings-Features | Die Feature-Class mit dem Parameterwert für Vorherzusagende Variable und optional den erklärenden Trainings-Variablen aus Feldern. | Feature Layer |

Vorherzusagende Variable (optional) | Die Variable aus dem Parameterwert Eingabe-Trainings-Features, die die Werte zum Trainieren des Modells enthält. Dieses Feld enthält bekannte (Trainings-)Werte der Variablen, mit denen eine Vorhersage an unbekannten Positionen getroffen wird. | Field |

Variable als kategorial behandeln (optional) | Gibt an, ob es sich bei dem Wert für Vorherzusagende Variable um eine Kategorievariable handelt.

| Boolean |

Erklärende Trainingsvariablen (optional) | Eine Liste der Felder, die erklärende Variablen darstellen und die Vorhersage des Wertes oder der Kategorie des Wertes für Vorherzusagende Variable unterstützen. Aktivieren Sie das Kontrollkästchen Kategorial für alle Variablen, die Klassen oder Kategorien darstellen (z. B. Landbedeckung oder Anwesenheit oder Abwesenheit). | Value Table |

Erklärende Trainings-Entfernungs-Features (optional) | Der Feature-Layer, der die erklärenden Trainings-Entfernungs-Features enthält. Erklärende Variablen werden automatisch durch Berechnung einer Entfernung zwischen den bereitgestellten Features und Werten von Eingabe-Trainings-Features erstellt. Entfernungen werden von den einzelnen Features des Wertes für Eingabe-Trainings-Features zu den nächsten Werten für Erklärende Trainings-Entfernungs-Features berechnet. Wenn es sich bei den Eingabewerten für Erklärende Trainings-Entfernungs-Features um Polygone oder Linien handelt, werden die Entfernungsattribute als Entfernung zwischen den nächstgelegenen Segmenten des Feature-Paares berechnet. | Feature Layer |

Erklärende Trainings-Raster (optional) | Die aus Rastern extrahierten erklärenden Trainingsvariablen. Erklärende Trainingsvariablen werden automatisch durch Extrahieren von Raster-Zellenwerten erstellt. Der Wert der Raster-Zelle wird für jedes Feature in dem Parameter Eingabe-Trainings-Features an der genauen Position extrahiert. Beim Extrahieren des Raster-Werts für kontinuierliche Raster wird bilineares Resampling verwendet. Beim Extrahieren eines Raster-Werts aus Kategorie-Rastern wird ein Nächster-Nachbar-Resampling durchgeführt. Aktivieren Sie das Kontrollkästchen Kategorie für alle Raster, die Klassen oder Kategorien darstellen, z. B. Landbedeckung oder Anwesenheit oder Abwesenheit. | Value Table |

Eingabe-Vorhersage-Features (optional) | Eine Feature-Class, die die Positionen darstellt, an denen Vorhersagen getroffen werden. Diese Feature-Class muss auch erklärende Variablen enthalten, die als Felder bereitgestellt wurden und den von den Trainingsdaten verwendeten Feldern entsprechen. | Feature Layer |

Vorhergesagte Ausgabe-Features (optional) | Die Ausgabe-Feature-Class mit den Vorhersageergebnissen. | Feature Class |

Vorhergesagte Ausgabe-Oberfläche (optional) | Das Ausgabe-Raster mit den Vorhersageergebnissen. Die Standard-Zellengröße entspricht der maximalen Zellengröße der Raster-Eingaben. Um eine andere Zellengröße festzulegen, verwenden Sie die Umgebungseinstellung Zellengröße. | Raster Dataset |

Erklärende Variablen abgleichen (optional) | Eine Liste der angegebenen Werte für Erklärende Variablen aus den Eingabe-Trainings-Features rechts und den ihnen entsprechenden Feldern aus den Eingabe-Vorhersage-Features links. | Value Table |

Entfernungs-Features abgleichen (optional) | Eine Liste der angegebenen Werte für Erklärende Entfernungs-Features für den Parameter Eingabe-Trainings-Features rechts und den entsprechenden Feature-Sets aus dem Parameter Eingabe-Vorhersage-Features links. Für Erklärende Entfernungs-Features können Werte angegeben werden, die eher für den Parameter Eingabe-Vorhersage-Features geeignet sind, wenn sich die für das Training verwendeten Features auf ein anderes Untersuchungsgebiet oder einen anderen Zeitraum beziehen. | Value Table |

Erklärende Raster abgleichen (optional) | Eine Liste der angegebenen Werte für Erklärende Raster für den Parameter Eingabe-Trainings-Features rechts und den entsprechenden Rastern aus dem Parameter Eingabe-Vorhersage-Features oder dem Parameter Vorhersageoberfläche, der erstellt werden soll, links. Werte für Erklärende Raster, die angemessener für den Parameter Eingabe-Vorhersage-Features sind, können angegeben werden, wenn sich die für das Training verwendeten Features auf ein anderes Untersuchungsgebiet oder einen anderen Zeitraum beziehen. | Value Table |

Trainierte Ausgabe-Features (optional) | Die für das Training verwendeten erklärenden Variablen (einschließlich Stichproben-Raster-Werte und Entfernungsberechnungen) sowie das beobachtete Feld Vorherzusagende Variable und die zugehörigen Vorhersagen, mit denen die Performance des trainierten Modells weiter geprüft werden kann. | Feature Class |

Ausgabetabelle zur Variablenbedeutung (optional) | Die Tabelle, die Informationen zur Bedeutung aller im Modell verwendeten erklärenden Variablen enthält. Zu den erklärenden Variablen zählen Felder, Entfernungs-Feature und Raster, die für die Erstellung des Modells verwendet werden. Wenn für den Parameter Modelltyp der Wert Gradient Boosting festgelegt wurde, wird die Bedeutung durch Gain, Gewichtung und Abdeckung gemessen, und die Tabelle enthält die entsprechenden Felder. Die Ausgabe enthält ein Balkendiagramm, wenn der Parameter Anzahl der ausgeführten Validierungen 1 entspricht, bzw. ein Box-Plot, wenn der Wert größer als 1 ist. Dieses stellt die Bedeutung der erklärenden Variablen dar. | Table |

Polygone für Training in Raster-Auflösung konvertieren (optional) | Gibt an, wie Polygone beim Trainieren des Modells behandelt werden, wenn es sich bei den Werten für Eingabe-Trainings-Features um Polygone mit einem kategorialen Wert für Vorherzusagende Variable handelt und nur Werte für Erklärende Trainings-Raster angegeben wurden.

| Boolean |

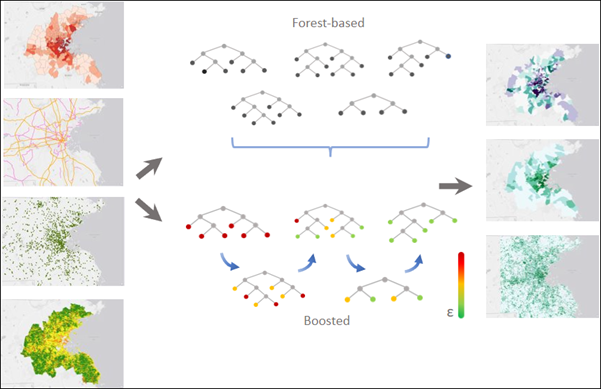

Anzahl der Baumstrukturen (optional) | Die Anzahl der Bäume, die in Forest-basierten und Gradient-Boosting-Modellen erstellt werden. Die Standardeinstellung ist 100. Wenn für den Parameter Modelltyp der Wert Forest-basiert angegeben wurde, führt eine größere Anzahl von Bäumen i. A. zu einer genaueren Modellvorhersage; für die Berechnung des Modells wird jedoch mehr Zeit benötigt. Wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde, führt eine größere Anzahl von Bäumen u. U. zu einer genaueren Modellvorhersage; es besteht jedoch das Risiko einer Überanpassung der Trainingsdaten. Um eine Überanpassung der Daten zu vermeiden, geben Sie Werte für die Parameter Maximale Baumstrukturtiefe, L2-Normalisierung (Lambda), Minimale Verlustreduzierung für Verzweigungen (Gamma) und Lernrate (Eta) an. | Long |

Minimale Blattgröße (optional) | Die minimale Anzahl der Beobachtungen, die mindestens erforderlich sind, um ein Blatt (also den Endpunkt einer Baumstruktur, der keine weiteren Verzweigungen hat) beizubehalten. Das Standardminimum ist 5 für die Regression und 1 für die Klassifizierung. Bei sehr großen Daten führt eine Erhöhung dieser Zahlen zu einer Erhöhung der Laufzeit des Werkzeugs. | Long |

Maximale Baumstrukturtiefe (optional) | Die maximale Anzahl von Verzweigungen entlang einer Baumstruktur. Je größer die maximale Tiefe, desto mehr Verzweigungen werden erstellt. Dadurch steigt das Risiko einer Überanpassung des Modells. Wenn für den Parameter Modelltyp der Wert Forest-basiert angegeben wurde, ist die Standardeinstellung datengesteuert und abhängig von der Anzahl der erstellten Bäume und berücksichtigten Variablen. Wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde, lautet der Standardwert 6. | Long |

Pro Baumstruktur verfügbare Daten (%) (optional) | Der Prozentsatz der Werte von Eingabe-Trainings-Features, die für jeden Entscheidungsbaum verwendet werden sollen. Die Standardeinstellung liegt bei 100 Prozent der Daten. Stichproben für jede Baumstruktur werden nach dem Zufallsprinzip aus zwei Dritteln der angegebenen Daten entnommen. Alle Entscheidungsbäume im Wald werden mithilfe einer zufälligen Stichprobe oder einer zufälligen Teilmenge (etwa zwei Drittel) der verfügbaren Trainingsdaten erstellt. Durch die Verwendung eines niedrigeren Prozentsatzes der Eingabedaten für die einzelnen Entscheidungsbäume wird die Laufzeit des Werkzeugs bei sehr großen Datasets reduziert. | Long |

Anzahl der nach dem Zufallsprinzip erfassten Variablen (optional) | Die Anzahl der erklärenden Variablen, die zum Erstellen der einzelnen Entscheidungsbäume verwendet werden sollen. Alle Entscheidungsbäume in den Forest-basierten und Gradient-Boosting-Modellen werden mithilfe einer zufälligen Teilmenge der angegebenen erklärenden Variablen erstellt. Durch eine Erhöhung der Anzahl der in den einzelnen Entscheidungsbäumen verwendeten Variablen steigt die Wahrscheinlichkeit einer Überanpassung des Modells, vor allem dann, wenn dominante Variablen vorhanden sind. Standardmäßig wird die Quadratwurzel aus der Gesamtzahl der erklärenden Variablen (Felder, Entfernungen und Raster) gezogen, wenn der Wert für Vorherzusagende Variable kategorial ist. Ist der Wert für Vorherzusagende Variable numerisch, wird die Gesamtzahl der erklärenden Variablen (Felder, Entfernungen und Raster zusammengenommen) durch 3 geteilt. | Long |

% der Trainingsdaten für die Validierung ausgeschlossen (optional) | Der Prozentsatz (zwischen 10 und 50 Prozent) der Werte von Eingabe-Trainings-Features, die als Test-Dataset für die Validierung reserviert werden sollen. Das Modell wird ohne diese zufällige Teilmenge der Daten trainiert, und die vom Modell vorhergesagten Werte für diese Features werden mit den beobachteten Werten verglichen. Der Standardwert ist 10 Prozent. | Double |

Ausgabetabelle für Klassifizierungs-Performance (Konfusionsmatrix) (optional) | Eine Konfusionsmatrix, in der die Performance des für die Validierungsdaten erstellten Modells zusammengefasst wird. Die Matrix vergleicht die vom Modell vorhergesagten Kategorien für die Validierungsdaten mit den tatsächlichen Kategorien. Diese Tabelle kann verwendet werden, um zusätzliche Diagnosen zu berechnen, die nicht in den Ausgabemeldungen enthalten sind. Dieser Parameter ist verfügbar, wenn der Wert für Vorherzusagende Variable kategorial ist und der Parameter Als kategorial behandeln aktiviert wurde. | Table |

Ausgabetabelle der Validierung (optional) | Eine Tabelle, die den R2-Wert für jedes Modell enthält, wenn der Wert für Vorherzusagende Variable nicht kategorial ist. Ist der Wert kategorial, wird die Accuracy für jedes Modell angezeigt. Diese Tabelle enthält ein Balkendiagramm mit der Verteilung der Accuracy- bzw. der R2-Werte. Mit dieser Verteilung können Sie die Stabilität des Modells bewerten. Dieser Parameter ist verfügbar, wenn der Wert für Anzahl der ausgeführten Validierungen größer als 2 ist. | Table |

Spärliche Kategorien ausgleichen (optional) | Gibt an, ob jede Kategorie im Trainings-Dataset ungeachtet ihrer Häufigkeit in jeder Baumstruktur dargestellt werden soll. Dieser Parameter ist verfügbar, wenn für den Parameter Modelltyp der Wert Forest-basiert eingegeben wurde.

| Boolean |

Anzahl der ausgeführten Validierungen (optional) | Die Anzahl der Iterationen des Werkzeugs. Die Verteilung der R-Squared-Werte (kontinuierlich) oder Accuracy-Werte (kategorial) für alle Modelle kann mithilfe des Parameters Ausgabetabelle der Validierung angezeigt werden. Wenn für den Parameter Vorhersagetyp der Wert Raster vorhersagen oder Features vorhersagen festgelegt wurde, wird das Modell mit dem R-Squared-Medianwert bzw. Accuracy-Medianwert für die Vorhersage verwendet. Die Verwendung des Medianwerts trägt dazu bei, die Stabilität der Vorhersagen sicherzustellen. | Long |

Unsicherheit berechnen (optional) | Gibt an, ob beim Trainieren oder beim Vorhersagen von Features oder Rastern die Vorhersageunsicherheit berechnet wird. Dieser Parameter ist verfügbar, wenn für den Parameter Modelltyp der Wert Forest-basiert angegeben wurde.

| Boolean |

Trainierte Ausgabe-Modelldatei (optional) | Eine Ausgabe-Modelldatei, in der das trainierte Modell, das später für Vorhersagen wiederverwendet werden kann, gespeichert werden soll. | File |

Modelltyp (optional) | Gibt die Methode für die Erstellung des Modells an.

| String |

L2-Normalisierung (Lambda) (optional) | Ein Normalisierungsausdruck, der die Sensitivität des Modells gegenüber einzelnen Features reduziert. Eine Erhöhung dieses Wertes bewirkt, dass das Modell konservativer wird, und verhindert eine Überanpassung der Trainingsdaten. Wenn der Wert 0 ist, entspricht das Modell dem traditionellen Gradient-Boosting-Modell. Die Standardeinstellung ist 1. Dieser Parameter ist verfügbar, wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde. | Double |

Minimale Verlustreduzierung für Verzweigungen (Gamma) (optional) | Ein Schwellenwert für die minimale Verlustreduzierung, die erforderlich ist, um Bäume zu teilen. Potenzielle Verzweigungen werden im Hinblick auf ihre Verlustreduzierung evaluiert. Übersteigt die Verlustreduzierung einer potenziellen Verzweigungen diesen Schwellenwert, wird die Verzweigung durchgeführt. Durch höhere Schwellenwerte kann eine Überanpassung vermieden werden. Das Ergebnis sind konservativere Modelle mit weniger Partitionen. Die Standardeinstellung ist 0. Dieser Parameter ist verfügbar, wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde. | Double |

Lernrate (Eta) (optional) | Ein Wert, der den Beitrag der einzelnen Bäume zur endgültigen Vorhersage reduziert. Der Wert sollte größer als 0 und kleiner als oder gleich 1 sein. Eine niedrigere Lernrate verhindert eine Überanpassung des Modells, verlängert jedoch möglicherweise die Berechnungszeit. Der Standardwert ist 0,3. Dieser Parameter ist verfügbar, wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde. | Double |

Maximale Anzahl von Abschnitten zum Suchen von Verzweigungen (optional) | Die Anzahl der Abschnitte, in die die Trainingsdaten geteilt werden, um den besten Verzweigungspunkt zu finden. Der Wert darf nicht 1 sein. Der Standardwert ist 0, was der Verwendung eines Greedy-Algorithmus entspricht. Ein Greedy-Algorithmus erstellt bei jedem Datenpunkt eine potenzielle Verzweigung. Es ist nicht empfehlenswert, zu wenige Abschnitte für die Suche bereitzustellen, da sich dies negativ auf die Vorhersage-Performance des Modells auswirkt. Dieser Parameter ist verfügbar, wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde. | Long |

Parameter optimieren (optional) | Gibt an, ob eine Optimierungsmethode verwendet wird, um den Hyperparametersatz zu ermitteln, der eine optimale Modell-Performance erzielt.

| Boolean |

Optimierungsmethode (optional) | Gibt die Optimierungsmethode an, mit der Suchpunkte ausgewählt und getestet werden, um den optimalen Hyperparametersatz zu ermitteln. Suchpunkte sind Kombinationen von Hyperparametern innerhalb des Suchraums, der mittels des Parameters Modellparametereinstellung angegeben wurde. Diese Option ist verfügbar, wenn der Parameter Optimierungsparameter aktiviert ist.

| String |

Ziel optimieren (Objective) (optional) | Gibt die Objective-Funktion oder den Wert an, der minimiert oder maximiert werden soll, um den optimalen Hyperparametersatz zu ermitteln.

| String |

Anzahl der Ausführungen für Parametersets (optional) | Die Anzahl der Suchpunkte innerhalb des durch den Parameter Modellparametereinstellung angegebenen Suchraums, die getestet werden sollen. Dieser Parameter ist verfügbar, wenn für den Parameter Optimierungsmethode der Wert Zufällige Suche (Schnell) oder Zufällige Suche (Zuverlässig) festgelegt wurde. | Long |

Modellparametereinstellung (optional) | Eine Liste der Hyperparameter und deren Suchräumen. Passen Sie den Suchraum für jeden Hyperparameter an, indem Sie eine untere Grenze, eine obere Grenze und ein Intervall festlegen. Die untere Grenze und die obere Grenze geben den Bereich der zulässigen Werte für den Hyperparameter an. Im Folgenden wird der Bereich der gültigen Werte für jeden Hyperparameter aufgeführt:

| Value Table |

Ausgabetabelle zur Parameteroptimierung (optional) | Eine Tabelle, in der die Parametereinstellungen und objektiven Werte für jeden Optimierungstestlauf enthalten sind. Die Ausgabe enthält ein Diagramm mit allen Testläufen und ihren objektiven Werten. Diese Option ist verfügbar, wenn Parameter optimieren aktiviert ist. | Table |

Alle Vorhersagewahrscheinlichkeiten einbeziehen (optional) | Gibt für vorherzusagende kategoriale Variablen an, ob die Wahrscheinlichkeit jeder Kategorie der kategorialen Variablen oder nur die Wahrscheinlichkeit der Kategorie des Datensatzes vorhergesagt wird. Wenn z. B. eine kategoriale Variable die Kategorien A, B und C aufweist und der erste Datensatz von Kategorie B ist, geben Sie mit diesem Parameter an, ob die Wahrscheinlichkeit für die Kategorien A, B und C oder nur die Wahrscheinlichkeit der Kategorie B für den Datensatz vorhergesagt wird.

| Boolean |

Abgeleitete Ausgabe

| Beschriftung | Erläuterung | Datentyp |

| Ausgabe-Unsicherheits-Raster-Layer | Wenn Sie den Parameter Unsicherheit berechnen aktivieren, berechnet das Werkzeug für jeden vorhergesagten Wert des Parameters Vorherzusagende Variable ein Vorhersageintervall von 90 Prozent. | Raster Layer |