Mit der Geostatistical Analyst-Lizenz verfügbar.

Bevor Sie sich für ein Interpolationsmodell für die Entscheidungsfindung entscheiden, sollten Sie untersuchen, wie gut das Modell Werte an neuen Positionen vorhersagen kann. Wie können Sie jedoch wissen, ob Ihr Modell die Werte genau und zuverlässig vorhersagt, wenn Sie die echten Werte an den Positionen zwischen den gemessenen Punkten nicht kennen? Die Antwort auf die Frage erfordert scheinbar, die Werte der Positionen zu kennen, die sie nicht abgefragt haben. Es gibt jedoch eine häufig genutzte und weit verbreitete Methode für die Bewertung der Genauigkeit und Zuverlässigkeit einer Interpolation: die Kreuzvalidierung.

Kreuzvalidierung

Die Kreuzvalidierung ist eine Leave-one-out-Resampling-Methode, die zunächst alle Eingabepunkte verwendet, um die Parameter eines Interpolationsmodells zu schätzen (wie z. B. das Semivariogramm für das Kriging oder den Potenzwert des Inverse Distance Weighting). Dann entfernt es einen einzelnen Eingabepunkt und verwendet die verbleibenden Punkte zum Vorhersagen des Wertes an der Position des ausgeblendeten Punktes, und der vorhergesagte Wert wird mit dem gemessenen Wert verglichen. Der ausgeblendete Punkt wird dann dem Dataset wieder hinzugefügt und ein anderer Punkt wird ausgeblendet und vorhergesagt. Dieser Prozess wird für alle Eingabepunkte wiederholt.

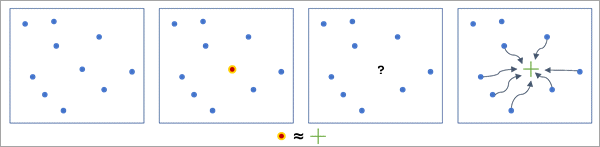

Das folgende Diagramm zeigt den Prozess der Kreuzvalidierung für einen Einzelpunkt. Nach der Schätzung des Interpolationsmodells durch alle blauen Punkte, wird der Wert des roten Punkts ausgeblendet, und die verbleibenden Punkte werden zum Vorhersagen des Wertes des ausgeblendeten Punktes verwendet. Die Vorhersage wird dann mit dem gemessenen Wert verglichen. Dieser Prozess wird für alle 10 Punkte wiederholt.

Die Kreuzvalidierung ist effektiv für die Bewertung von Interpolationsmodellen, da es die Vorhersage von Werten an neuen, nicht gemessenen Positionen simuliert. Die Werte an den Positionen sind jedoch gemessen, nur ausgeblendet, damit die vorhergesagten Werte anhand ihrer bekannten Werte validiert werden können. Wenn das Modell die Werte der ausgeblendeten Punkte genau vorhersagen kann, sollte es auch die Werte an neuen, nicht gemessenen Positionen genau vorhersagen können. Wenn jedoch die Fehler der Kreuzvalidierung sehr groß sind, dann sollten Sie auch große Fehler beim Vorhersagen für neue Positionen erwarten.

Die Kreuzvalidierung wird beim Erstellen eines Interpolationsmodells automatisch durchgeführt, und die Ergebnisse werden auf der letzten Seite des Geostatistical Wizard angezeigt. Die Kreuzvalidierung kann auch mit dem Werkzeug Kreuzvalidierung für einen bestehenden geostatistischen Layer berechnet werden. Wenn sich ein geostatistischer Layer in einer Karte befindet, dann können Sie die Statistiken der Kreuzvalidierung anzeigen, indem Sie entweder mit der rechten Maustaste auf den Layer klicken und Kreuzvalidierung auswählen oder auf die Schaltfläche Kreuzvalidierung auf dem Menüband Daten für den geostatistischen Layer klicken.

Die Kreuzvalidierung hat jedoch den Nachteil, dass sie zunächst alle Eingabepunkte verwendet, um die Parameter des Interpolationsmodells zu schätzen, bevor nacheinander jeder Punkt ausgeblendet wird. Da alle Punkte zur Schätzung der Interpolationsparameter beigetragen haben, waren sie in dem Verfahren nicht vollständig ausgeblendet. Einzelne Punkte haben im Allgemeinen keinen großen Einfluss auf die geschätzten Werte der Interpolationsparameter. Bei kleinen Datasets und Datasets, die Ausreißer enthalten, kann jedoch sogar ein einziger Punkt die Schätzung der Interpolationsparameter signifikant verändern. Um die Werte der Punkte vollständig auszublenden und die doppelte Verwendung der Daten zu vermeiden, können Sie die Validierung verwenden.

Validierung

Die Validierung ähnelt der Kreuzvalidierung, mit der Ausnahme, dass sie zuerst eine vollständige Teilmenge der Eingabepunkte entfernt, die Test-Dataset genannt wird. Dann werden die verbleibenden Punkte verwendet, die als Trainings-Dataset bezeichnet werden, um die Parameter des Interpolationsmodells zu schätzen. Das Interpolationsmodell trifft dann Vorhersagen für alle Positionen des Test-Datasets, und die Validierungsfehler werden für jeden Testpunkt berechnet. Da das Test-Dataset auf keine Weise zur Schätzung der Interpolationsparameter oder zum Treffen von Vorhersagen verwendet wurde, ist die Validierung am präzisesten in der Bewertung, wie genau und zuverlässig das Interpolationsmodell Vorhersagen für neue Positionen mit unbekannten Werten treffen wird. Die Validierung hat jedoch den großen Nachteil, dass Sie nicht all ihre Daten zum Erstellen des Interpolationsmodells verwenden können, daher sind die Parameterschätzungen möglicherweise nicht so genau und präzise, wie sie es bei der Verwendung aller Daten gewesen wären. Wegen der Anforderung der Reduzierung der Größe des Datasets wird die Kreuzvalidierung der Validierung gewöhnlich vorgezogen, es sei denn die Daten enthalten zu viele Details.

Sie können Test- und Trainings-Datasets mit dem Werkzeug Teilmengen aus Features erstellen generieren. Nach dem Erstellen eines Interpolationsmodells (geostatistischer Layer) für das Trainings-Dataset, können Sie die Validierung mit dem Werkzeug GA-Layer in Punkte durchführen. Stellen Sie den aus dem Trainings-Dataset erstellten geostatistischen Layer bereit, treffen Sie Vorhersagen für das Test-Dataset und validieren Sie das Feld, das zum Interpolieren verwendet wurde. Die Validierungsfehler und andere Validierungsstatistiken werden in der Ausgabe-Feature-Class gespeichert.

Im Rest dieses Themas wird nur die Kreuzvalidierung besprochen, aber alle Konzepte gelten analog für die Validierung.

Kreuzvalidierungsstatistiken

Bei der Durchführung der Kreuzvalidierung werden verschiedene Statistiken für jeden Punkt berechnet. Diese Statistiken können auf der Registerkarte Tabelle des Dialogfelds "Kreuzvalidierung" angezeigt werden oder mit dem Werkzeug Kreuzvalidierung in einer Feature-Class gespeichert werden. Die folgenden Felder werden für jeden Punkt erstellt:

- Gemessen: Der gemessene Wert des ausgeblendeten Punktes

- Vorhergesagt: Der vorhergesagte Wert der Kreuzvalidierung an der Position des ausgeblendeten Punktes.

- Fehler: Die Differenz zwischen dem vorhergesagten und dem gemessenen Wert (vorhergesagt minus gemessen). Ein positiver Fehler bedeutet, dass die Vorhersage größer war als der gemessene Wert, und ein negativer Fehler bedeutet, dass die Vorhersage kleiner war als der gemessene Wert.

- Standardfehler: Der Standardfehler des vorhergesagten Wertes. Wenn die Fehler normalverteilt sind, werden ungefähr zwei Drittel der gemessenen Werte innerhalb eines Standardfehlers des vorhergesagten Wertes liegen, und ungefähr 95 Prozent liegen innerhalb von zwei Standardfehlern.

- Standardisierter Fehler: Der Fehler geteilt durch den Standardfehler. Zur Verwendung der Ausgabetypen "Quantil" oder "Wahrscheinlichkeit" sollten die Werte des standardisierten Fehlers einer Standardnormalverteilung folgen (Mittelwert gleich Null und Standardabweichung gleich Eins).

Darüber hinaus sind die folgenden Kreuzvalidierungsstatistiken für Modelle der Empirical-Bayesian-Kriging-Familie verfügbar:

- Continuous Ranked Probability Score: Eine positive Zahl, die die Genauigkeit und Präzision des vorhergesagten Wertes misst, wobei ein kleinerer Wert besser ist. Der Wert ist für sich allein schwer zu interpretieren, aber je näher der Fehler an Null liegt und je kleiner der Standardfehler ist, desto kleiner ist der Continuous Ranked Probability Score. Im Kern misst die Statistik eine Entfernung (keine typische geographische Entfernung) zwischen den Messwerten und der Verteilung der Vorhersagen, was die Genauigkeit der Vorhersage und des Standardfehlers ergibt. Eine geringe Verteilung der Vorhersagen um den Messwert herum (Fehler nahe Null und kleiner Standardfehler) führt zu einem Continuous Ranked Probability Score nahe Null. Der Wert wird in quadratischen Dateneinheiten gemessen, daher sollte er nicht über Datasets hinweg mit verschiedenen Einheiten oder Wertebereichen verglichen werden.

- Validierungsquantil: Das Quantil des gemessenen Wertes in Bezug auf die Vorhersageverteilung. Wenn das Modell korrekt konfiguriert wurde, werden die Quantile der Validierung gleichmäßig zwischen 0 und 1 verteilt und zeigen keine Muster. Die Validierungsquantile von fehlerhaft konfigurierten Modellen enthalten oft Cluster in der Mitte (mit den meisten Werten bei 0,5) oder an den Extremwerten (die meisten Werte bei 0 oder 1).

- Innerhalb des 90-Prozent-Intervalls: Ein Indikator (1 oder 0) dafür, ob der Messwert innerhalb eines 90 %-Intervalls der Vorhersage liegt (analog zu einem Konfidenzintervall). Wenn das Modell richtig konfiguriert wurde, liegen ungefähr 90 Prozent der Punkte innerhalb des Intervalls und haben den Wert 1.

- Innerhalb des 95-Prozent-Intervalls: Ein Indikator (1 oder 0) dafür, ob der Messwert innerhalb eines 95 %-Intervalls der Vorhersage liegt. Wenn das Modell richtig konfiguriert wurde, liegen ungefähr 95 Prozent der Punkte innerhalb des Intervalls und haben den Wert 1.

Hinweis:

Interpolationsmethoden, die den Ausgabetyp "Standardfehler der Vorhersage" nicht unterstützen, können die gemessenen und vorhergesagten Werte und die Fehlerwerte nur berechnen.

Summenstatistiken der Kreuzvalidierung

Die einzelnen Kreuzvalidierungsstatistiken für jeden ausgeblendeten Punkt stellen detaillierte Informationen über die Performance des Modells bereit, aber für eine große Anzahl an Eingabepunkten müssen die Informationen zusammengefasst werden, um zügig zu interpretieren, was dies für Ihr Interpolationsergebnis bedeutet. Summenstatistiken der Kreuzvalidierung können auf der Registerkarte Zusammenfassung des Dialogfelds "Kreuzvalidierung" angezeigt werden, und sie werden vom Werkzeug Kreuzvalidierung als Nachrichten ausgegeben. Die folgenden Summenstatistiken sind verfügbar:

Hinweis:

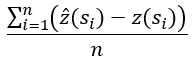

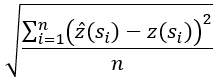

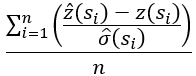

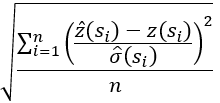

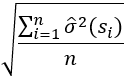

In allen Formeln ist n die Anzahl der Punkte. si ist die Position des ausgeblendeten Punktes. z(si) ist der gemessene Wert an der Position. z-hat(si) ist der vorhergesagte Wert. σ-hat ist der Standardfehler des vorhergesagten Wertes.

- Mean Error: Der Mittelwert der Kreuzvalidierungsfehler. Dieser Wert sollte so nah an Null sein wie möglich. Der Mean Error misst die Modellverzerrung, wobei ein positiver Mean Error auf eine Tendenz hinweist, Werte vorherzusagen, die zu groß sind, und ein negativer Mean Error weist auf die Tendenz hin, kleinere Wert als die gemessenen Werte vorherzusagen. Die Statistik wird in denselben Einheiten angegeben wie die Datenwerte.

- RMS-Fehler: Die Quadratwurzel der durchschnittlichen quadrierten Vorhersagefehler. Dieser Wert sollte so klein wie möglich sein. Die Statistik misst die Genauigkeit der Vorhersage, und der Wert schätzt die durchschnittliche Abweichung der vorhergesagten Werte von den gemessenen Werten. Der Wert wird in denselben Einheiten angegeben wie die Datenwerte. Für die Interpolation der Temperatur in Grad Celsius bedeutet ein RMS-Fehler von 1,5 zum Beispiel, dass die Vorhersagen von den gemessenen Werten um durchschnittlich ungefähr 1,5 Grad abweichen.

- Mean-Standardized-Fehler: Der Durchschnitt der standardisierten Fehler (Fehler geteilt durch Standardfehler). Dieser Wert sollte so nah an Null sein wie möglich. Die Statistik misst die Modellverzerrung auf einer standardisierten Skala, damit sie über Datasets mit verschiedenen Werten und Einheiten hinweg vergleichbar ist.

- Durchschnittlicher Standardfehler: Der quadratische Durchschnitt (Root Mean Square) des Standardfehlers. Diese Statistik misst die Genauigkeit des Modells, eine Tendenz, Verteilungen der Vorhersagen, die eng um den vorhergesagten Wert zentriert sind, zu erstellen. Der Wert sollte so klein wie möglich sein, aber auch ungefähr dem RMS-Fehler entsprechen.

- Der Durchschnitt wird über die Varianz der Kreuzvalidierung (quadrierte Standardfehler) erstellt, weil Varianzen additiv sind, aber Standardfehler nicht.

- Root-Mean-Square-Standardized-Fehler: Der Root Mean Square des standardisierten Fehlers. Diese Statistik misst die Genauigkeit der Standardfehler durch den Vergleich der Variabilität der Fehler der Kreuzvalidierung mit den geschätzten Standardfehlern. Dieser Wert sollte so nah wie möglich an Eins liegen. Werte kleiner als Eins geben an, dass die geschätzten Standardfehler zu groß sind, und Werte größer als Eins geben an, dass sie zu klein sind. Der Wert kann als umgekehrtes Verhältnis interpretiert werden. Ein Wert von Drei bedeutet zum Beispiel, dass die Standardfehler durchschnittlich ein Drittel der Werte betragen, die sie betragen sollten. Ebenso bedeutet ein Wert von 0,5, dass die Standardfehler doppelt so groß sind wie die Werte, die sie sein sollten.

Darüber hinaus sind auch die folgenden Kreuzvalidierungs-Summenstatistiken für Modelle der Empirical-Bayesian-Kriging-Familie verfügbar:

- Durchschnittlicher CRPS: Der Durchschnitt der Werte des Continuous Ranked Probability Scores (CRPS). Der Wert sollte so klein wie möglich sein. Damit ein Modell einen niedrigen Durchschnitts-CRPS hat, müssen die Vorhersagen und die Standardfehler beide genau und präzise geschätzt sein.

- Innerhalb des 90-Prozent-Intervalls: Der Prozentsatz der Messwerte, die in einem Vorhersageintervall von 90 Prozent liegen. Der Wert sollte ungefähr 90 betragen. Diese Statistik misst, ob die Standardfehler mit den vorhergesagten Werten übereinstimmen. Werte über 90 zeigen an, dass die Standardfehler im Verhältnis zu den vorhergesagten Werten zu groß sind. Werte unter 90 zeigen an, dass die Standardfehler zu klein sind.

- Innerhalb des 95-Prozent-Intervalls: Der Prozentsatz der Messwerte, die in einem Vorhersageintervall von 95 Prozent liegen. Der Wert sollte ungefähr 95 betragen. Diese Statistik misst, ob die Standardfehler mit den vorhergesagten Werten übereinstimmen.

Hinweis:

Interpolationsmethoden, die den Ausgabetyp "Standardfehler der Vorhersage" nicht unterstützen, können nur die Statistiken des Mean Errors und des RMS-Fehlers berechnen.

Vergleich der Interpolationsmodelle

Die Kreuzvalidierung kann zur Bewertung der Qualität eines einzelnen geostatistischen Modells verwendet werden, aber eine andere gebräuchliche Anwendung ist der Vergleich zweier oder mehrerer Kandidatenmodelle, um zu bestimmen, welches Sie in Ihrer Analyse verwenden werden. Wenn die Anzahl der Kandidatenmodelle gering ist, können Sie sie mit Hilfe mehrerer Dialogfelder "Kreuzvalidierung" erkunden. Wenn Sie die Dialogfelder nebeneinander platzieren, können Sie alle Ergebnisse zur selben Zeit anzeigen und sich intensiv mit den Details jedes Modells beschäftigen.

Für eine große Anzahl von Kandidatenmodellen oder wenn die Modellerstellung automatisiert ist, kann das Werkzeug Geostatistische Layer vergleichen verwendet werden, um die Modelle unter Verwendung von anpassbaren Kriterien automatisch zu vergleichen und zu bewerten. Sie können Modelle basierend auf einem einzelnen Kriterium (z. B. dem niedrigsten RMS-Fehler oder dem Mean Error, der am nächsten bei Null liegt), dem gewichteten Durchschnitt mehrerer Kriterien oder der hierarchischen Sortierung mehrerer Kriterien (hier werden gleiche Werte zwischen den Kriterien durch das nachfolgende Kriterium in der Hierarchie aufgehoben) anordnen. Zudem können mithilfe von Ausschlusskriterien Interpolationsergebnisse, die nicht die minimalen Qualitätsstandards erfüllen, aus dem Vergleich ausgeschlossen werden. Das Werkzeug Explorative Interpolation führt ebenfalls dieselben Kreuzvalidierungs-Vergleiche durch, aber es erstellt die geostatistischen Layer automatisch aus einem Dataset und einem Feld. Dieses Werkzeug kann verwendet werden, um schnell zu bestimmen, welche Interpolationsmethoden für Ihre Daten die beste Leistung erzielen, ohne jede von ihnen einzeln durchführen zu müssen.

Kreuzvalidierungsdiagramme

In dem Pop-up-Dialogfeld "Kreuzvalidierung" befinden sich verschiedene Diagramme zum Visualisieren und interaktiven Erkunden der Kreuzvalidierungsstatistiken. Der Diagrammbereich des Dialogfelds enthält fünf Hauptregisterkarten, die jede ein anderes Diagramm anzeigen.

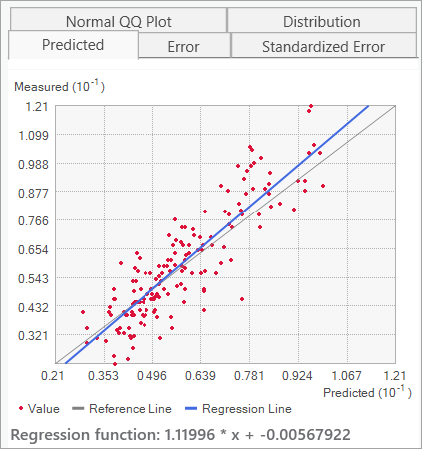

Auf der Registerkarte Vorhergesagt werden die vorhergesagten Werte gegenüber den gemessenen Werten in einem Scatterplot mit einer blauen Regressionslinie angezeigt, die an die Daten angepasst ist. Da die vorhergesagten Werte den gemessenen Werten entsprechen sollten, wird eine Referenzlinie bereitgestellt, um anzuzeigen, wie nah die Regressionslinie an diesem Ideal liegt. In der Praxis hat die Regressionslinie jedoch meistens eine steilere Neigung als die Referenzlinie, da Interpolationsmodelle (vor allem Kriging) dazu tendieren, die Datenwerte zu glätten, wodurch große Werte zu klein und kleine Werte zu groß vorhergesagt werden.

Hinweis:

Der Wert Regressionsfunktion unter dem Plot wird mithilfe eines zuverlässigen Regressionsverfahrens berechnet. In diesem Verfahren wird zuerst eine standardmäßige lineare Regressionslinie an den Scatterplot angepasst. Dann werden alle Punkte entfernt, die mehr als zwei Standardabweichungen über oder unter der Regressionslinie liegen, und eine neue Regressionsgleichung wird berechnet. Durch dieses Verfahren wird sichergestellt, dass eine kleine Anzahl von Ausreißern die Schätzungen der Neigung und des Schnittpunkts nicht verzerrt. Im Scatterplot werden alle Punkte angezeigt, auch wenn sie nicht für die Schätzung der Regressionsfunktion verwendet werden.

Die Registerkarten Fehler und Standardisierter Fehler ähneln der Registerkarte "Vorhergesagt", aber es werden die Kreuzvalidierungsfehler und die standardisierten Fehler gegenüber den Messwerten angezeigt. In diesen Plots sollte die Regressionslinie flach sein, und die Punkte sollten keine Muster erkennen lassen. In der Praxis sind die Neigungen aufgrund des Glättens jedoch meistens negativ.

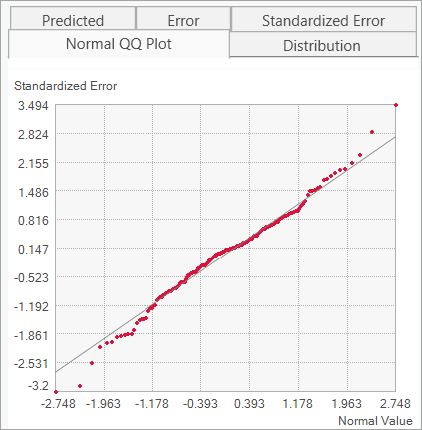

Auf der Registerkarte Normal QQ Plot wird ein Scatterplot der standardisierten Fehler im Vergleich mit den entsprechenden Quantilen der Standardnormalverteilung angezeigt. Wenn die Fehler der Kreuzvalidierung normalverteilt sind und die Standardfehler genau geschätzt wurden, dann sollten die Punkte im Plot alle in der Nähe der Referenzlinie liegen. Die Bewertung dieses Plots ist am wichtigsten bei der Verwendung der Ausgabetypen "Quantil" oder "Wahrscheinlichkeit", da sie normalverteilte Fehler erfordern.

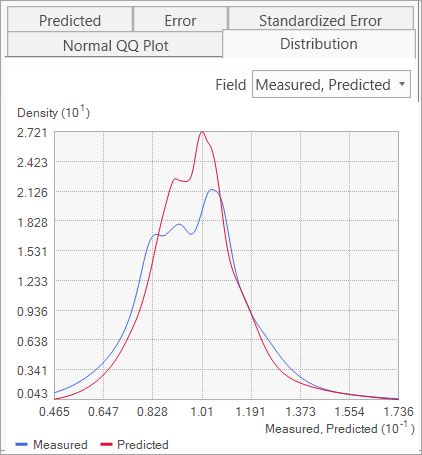

Die Registerkarte Verteilung zeigt die Verteilungen der Kreuzvalidierungsstatistiken an (mit Kerndichte geschätzt). Verwenden Sie das Dropdown-Menü Feld, um die angezeigte Statistik zu ändern. Eine besonders nützliche Option (im folgenden Bild angezeigt) ist das Überlagern der Verteilungen gemessener und vorhergesagter Werte auf demselben Diagramm, um zu sehen, wie eng sie aneinander angeglichen sind. Diese zwei Verteilungen sollten so ähnlich wie möglich aussehen, wobei die vorhergesagte Verteilung jedoch aufgrund des Glättens meistens größer und enger als die gemessene Verteilung ausfällt.

Interpretation von Kreuzvalidierungsstatistiken im Kontext

Eine weit verbreitete falsche Auffassung über die Kreuzvalidierung und andere Verfahren zum Überprüfen von Modellen ist, dass sie dazu gedacht sind, zu bestimmen, ob das Modell für die Daten richtig ist. In Wahrheit sind Modelle nie richtig für Daten, die von der realen Welt erfasst werden, aber sie müssen auch nicht richtig sein, um verwertbare Informationen für die Entscheidungsfindung bieten zu können. Dieses Konzept wird durch das bekannte Zitat von George Box (1978) zusammengefasst: "Alle Modelle sind falsch, aber manche sind nützlich." Betrachten Sie Kreuzvalidierungsstatistiken als Mittel zur Quantifizierung der Nützlichkeit eines Modells, nicht als Checkliste zur Bestimmung, ob ein Modell korrekt ist. Bei den vielen verfügbaren Statistiken (Einzelwerte, Summenstatistiken und Diagramme) ist es möglich, zu genau hinzuschauen, um Probleme und Abweichungen von idealen Werten und Mustern zu finden. Modelle sind nie perfekt, da sie die Daten nie perfekt abbilden.

Beim Bewerten der Ergebnisse der Kreuzvalidierung ist es wichtig, sich an die Ziele und Erwartungen Ihrer Analyse zu erinnern. Gehen wir zum Beispiel davon aus, dass Sie die Temperatur in Grad Celsius interpolieren, um Empfehlungen für die öffentliche Gesundheit während einer Hitzewelle abzugeben. Wie sollten Sie in diesem Szenario einen Mean Error von 0,1 interpretieren? Buchstäblich bedeutet es, dass das Modell eine positive Verzerrung hat und dazu tendiert, Temperaturwerte zu hoch vorherzusehen. Die durchschnittliche Verzerrung liegt jedoch nur bei einem zehntel Grad und ist damit kaum groß genug, um für die Gesundheitspolitik von Bedeutung zu sein. Auf der anderen Seite bedeutet ein RMS-Fehler mit einem Wert von 10 Grad, dass die vorhergesagten Werte durchschnittlich um 10 Grad von den echten Temperaturen abweichen. Dieses Modell wäre vermutlich zu ungenau, um nützlich zu sein, da Unterschiede von 10 Grad zu sehr verschiedenen Empfehlungen im Gesundheitswesen führen würden.

Außerdem ist es wichtig zu bedenken, ob Sie für die vorhergesagten Werte Konfidenzintervalle oder Fehlerspannen erstellen möchten. Sagen Sie zum Beispiel einen Temperaturwert von 28 Grad plus/minus zwei Grad vorher. Wenn Sie keine Fehlerspannen erstellen möchten, dann sind die Statistiken im Zusammenhang mit dem Standardfehler weniger wichtig, da ihr primärer Zweck die Bestimmung der Genauigkeit von Fehlerspannen ist. Während Probleme mit der Genauigkeit des Standardfehlers in manchen Fällen Probleme für die vorhergesagten Werte verursachen können, ist es für Interpolationsmodelle üblich, genaue Vorhersagen zu treffen aber Fehlerspannen ungenau zu schätzen.

Bei Interpolationsmodellen treten die meisten Schwierigkeiten beim Modellieren von Extremwerten auf, den größten und kleinsten Werten eines Datasets. Interpolationsmodelle treffen Vorhersagen mit Hilfe der gewichteten Durchschnitte von Messwerten in der Nachbarschaft der vorhergesagten Position. Durch das Bilden des Durchschnittswertes der Datenwerte werden Vorhersagen in Richtung des Durchschnittswertes der benachbarten Punkte gezogen, ein Phänomen, das als Glätten bezeichnet wird. Die Glättung ist in unterschiedlichem Maße in beinahe allen Interpolationsmodellen vorhanden, und es kann in den Neigungen der verschiedenen Kreuzvalidierungsdiagramme gesehen werden. Sie sollten zwar versuchen, das Glätten zu minimieren, in der Praxis ist aber vor allem wichtig, bei den Vorhersagen in Bereichen nahe der größten und kleinsten Datenwerte besonders skeptisch zu sein.

Letztendlich sollten Ihre Erwartungen für die Ergebnisse der Kreuzvalidierung von der Qualität und der Menge der Daten abhängen. Wenn nur wenige Punkte vorhanden sind oder ein großer Abstand zwischen den Punkten besteht, sollten Sie erwarten, dass die Kreuzvalidierungsstatistiken die begrenzten Informationen, die von den Punkten verfügbar sind, widerspiegeln. Auch mit einem korrekt konfigurierten Modell werden die Fehler der Kreuzvalidierung groß sein, wenn nicht genügend Informationen aus dem Dataset verfügbar sind, um genaue Vorhersagen treffen zu können. Analog können selbst schlecht konfigurierte Modelle mit ungenauen Parametern mit großen Mengen informativer und repräsentativer Daten genaue und zuverlässige Vorhersagen treffen.