Mit der Geostatistical Analyst-Lizenz verfügbar.

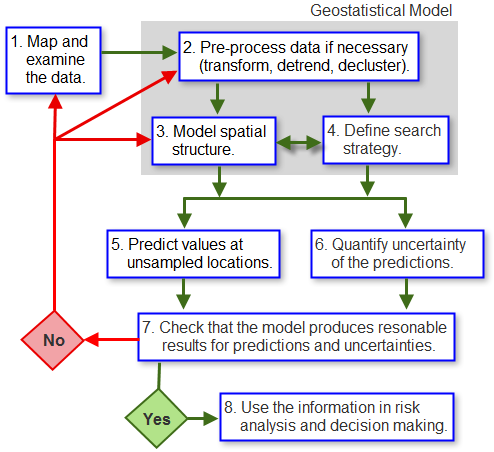

In diesem Thema wird ein allgemeiner Workflow für geostatistische Studien präsentiert, und die wesentlichen Schritte werden erläutert. Wie im Artikel Was ist die Geostatistik? beschrieben, ist eine Geostatistik eine Statistikklasse zur Analyse und Vorhersage der Werte, die zu einem räumlichen oder räumlich-zeitlichen Phänomen gehören. Geostatistical Analyst bietet eine Reihe von Werkzeugen, die die Erstellung von Modellen ermöglichen, die räumliche Koordinaten verwenden. Diese Modelle können auf ein breites Spektrum an Szenarien angewendet werden, und sie werden im Allgemeinen verwendet, um Vorhersagen für Positionen ohne Messwerte zu treffen und Messwerte für die Unsicherheit dieser Vorhersagen zu generieren.

Der erste Schritt ist, wie in beinah allen datenabhängigen Studien, die genaue Prüfung der Daten. Dies fängt im Allgemeinen mit der Zuordnung des Datasets an unter Verwendung einer Klassifizierung und eines Farbschemas, die die deutliche Visualisierung der wichtigen Eigenschaften, die das Dataset enthalten kann, ermöglichen, z. B. ein starker Anstieg der Werte von Norden nach Süden oder eine Mischung von hohen und niedrigen Werten in keiner besonderen Anordnung (möglicherweise ein Zeichen, dass die Daten in einem Maßstab entnommen wurden, in dem die räumliche Korrelation nicht angezeigt wird).

Die zweite Phase ist das Erstellen des geostatistischen Modells. Dieser Prozess kann je nach den Zielen der Studie (d. h. die Arten von Informationen, die das Modell bieten soll) und den Features des Datasets, die als wichtig genug erachtet werden, um sie einzubeziehen, mehrere Schritte beinhalten. In dieser Phase bestimmen die während einer gründlichen Erkundung des Datasets erfassten Informationen und die vorigen Kenntnisse des Phänomens wie komplex das Modell ist und wie gut die interpolierten Werte und die Messwerte der Unsicherheit sein werden. In der obigen Abbildung ist zu sehen, dass das Erstellen des Modells die Vorverarbeitung der Daten enthalten kann, um räumliche Trends zu entfernen, die separat modelliert und im letzten Schritt des Interpolationsvorgangs wieder eingefügt werden. Es kann möglicherweise auch das Transformieren der Daten einbeziehen, damit sie mehr einer Gauß'schen Verteilung entsprechen (bei manchen Methoden und Modellausgaben erforderlich). Während vieles an Informationen durch die Überprüfung des Datasets abgeleitet werden kann, ist es wichtig, jedes Wissen, dass Sie über das Phänomen haben, einzubinden. Der Ersteller eines Modells kann sich nicht nur auf das Dataset verlassen, alle wichtigen Features zu zeigen; solche, die nicht auftreten, können dennoch in das Modell eingebunden werden, indem Parameterwerte angepasst werden, um ein erwartetes Ergebnis widerzuspiegeln. Es ist wichtig, dass das Modell so realistisch wie möglich ist, damit die interpolierten Werte und die damit verbundenen Unsicherheiten genaue Repräsentationen des realen Phänomens sein können.

Zusätzlich zur Vorverarbeitung der Daten kann es notwendig sein, die räumliche Struktur (räumliche Korrelation) im Dataset zu modellieren. Für manche Methoden, wie das Kriging, ist es erforderlich, dies explizit mit einem Semivariogramm oder Kovarianzfunktionen zu modellieren (siehe das Thema Semivariogramme und Kovarianz-Funktionen), wogegen andere Methoden, wie die Inverse Distanzgewichtung, auf einem angenommenen Maß an räumlicher Struktur basieren, die der Modellierende auf der Grundlage vorheriger Kenntnisse über das Phänomen bereitstellen muss.

Eine letzte Komponente des Modells ist die Suchstrategie. Dadurch wird definiert, wie viele Datenpunkte verwendet werden, um einen Wert für eine Position ohne Messwerte zu generieren. Ihre räumliche Konfiguration (Position in Bezug zueinander und zur Position ohne Messwerte) kann ebenfalls definiert werden. Beide Faktoren haben Auswirkungen auf den interpolierten Wert und die damit verknüpfte Unsicherheit. Für viele Methoden wird eine Suchellipse definiert, neben der Anzahl von Sektoren, in die die Ellipse aufgeteilt wird, und wie viele Punkte von jedem Sektor zum Treffen einer Vorhersage genommen werden (siehe das Thema Search neighborhoods).

Wenn das Modell vollständig definiert wurde, kann es in Verbindung mit dem Dataset zum Generieren interpolierter Werte für alle Positionen ohne Messwerte innerhalb eines Interessenbereichs verwendet werden. Die Ausgabe ist meistens eine Karte, in der Werte der modellierten Variable angezeigt werden. Die Auswirkungen von Ausreißern kann in diesem Stadium untersucht werden, da sie vermutlich die Parameterwerte des Modells und damit die interpolierte Karte verändern. Je nach der Interpolationsmethode kann dasselbe Modell auch zum Generieren von Messwerten der Unsicherheit für die interpolierten Werte verwendet werden. Nicht alle Modelle haben diese Funktion, daher ist es wichtig, zu Beginn zu definieren, ob Messwerte der Unsicherheit erforderlich sind. Dadurch wird bestimmt, welches der Modelle geeignet ist (siehe das Thema Classification trees).

Wie bei allen Modellierungstätigkeiten sollte die Ausgabe des Modells überprüft werden, d. h. es sollte sichergestellt werden, dass die interpolierten Werte und die damit verknüpften Messwerte der Unsicherheit vernünftig sind und Ihren Erwartungen entsprechen.

Wenn das Modell zu Ihrer Zufriedenheit erstellt und angepasst ist und seine Ausgabe überprüft ist, dann können die Ergebnisse für Risikoanalysen und die Entscheidungsfindung verwendet werden.