Las herramientas de análisis de texto de la caja de herramientas GeoAI utilizan la arquitectura de transformador recientemente desarrollada para realizar tareas de procesamiento de lenguaje natural (NLP). Esta arquitectura permite que las herramientas sean más precisas y paralelas, y además se necesitan menos datos etiquetados para el entrenamiento.

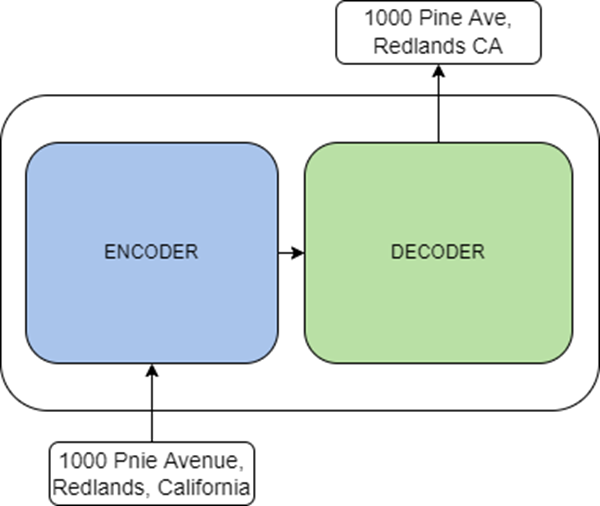

Los transformadores son modelos de lenguaje entrenados de manera autosupervisada en grandes cantidades de datos en forma de texto sin formato. Puede ajustar estos modelos previamente entrenados para sus datos mediante el aprendizaje de transferencia. Son arquitecturas novedosas propuestas en el artículo Attention Is All You Need, con el objetivo de resolver tareas como la clasificación de textos, la traducción de textos, la generación de textos y el reconocimiento de entidades. Un transformador consta de dos componentes principales: un componente de codificación y un componente de decodificación. El componente de codificación es una pila de codificadores que reciben una entrada y la codifican en una representación en forma de entidades. El componente de decodificación es una pila de decodificadores que utilizan la representación del componente de codificación junto con otras entradas para generar una salida en forma de secuencia objetivo.

Dependiendo de la tarea, los codificadores y decodificadores se pueden usar de las siguientes maneras:

- El componente de codificación se puede utilizar para tareas como la clasificación de textos y el reconocimiento de entidades nombradas. Algunos modelos de codificación conocidos son ALBERT, BERT y RoBERTa.

- El componente de decodificación se puede utilizar para tareas como la generación de textos. Algunos modelos de decodificación conocidos son CTRL y Transformer XL.

- Juntos, los componentes se pueden utilizar para tareas como la traducción y el resumen de textos. Algunos modelos de codificación y decodificación conocidos son BART y T5.

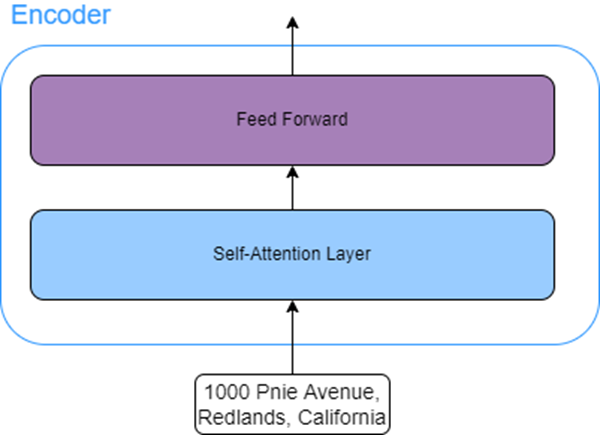

Todos los codificadores del componente de codificación tienen una estructura idéntica. Cada codificador tiene dos subcapas:

- Capa de autoatención: esta capa permite que los modelos encuentren otras palabras en la secuencia de entrada para mejorar la codificación de una palabra actual.

Como ejemplo, considere la siguiente secuencia de entrada: El hombre no pudo cruzar la calle porque él estaba herido. Aquí, la palabra él se refiere al hombre que no pudo cruzar la calle. En este caso, una capa de autoatención permitirá que el modelo asocie la palabra él con la palabra hombre.

- Capa de avance: esta capa acepta la salida de la capa de atención y la transforma en una forma que el siguiente codificador puede aceptar.

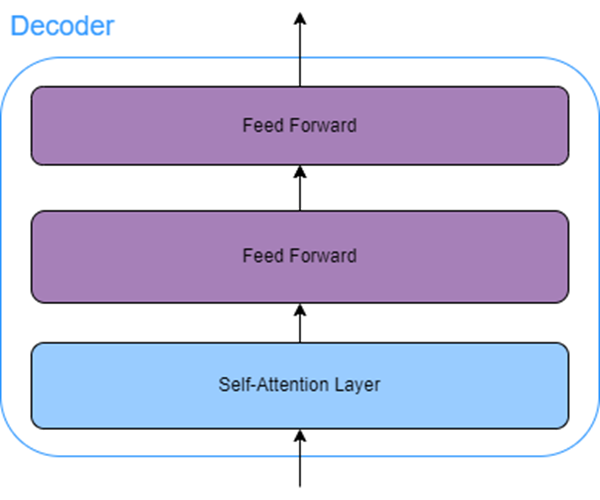

Todos los decodificadores del componente de decodificación tienen una capa de atención, también conocida como atención de codificador-decodificador, además de la capa de autoatención y de avance. Esta capa de atención de codificador-decodificador permite que el decodificador se centre en ciertas secciones de la secuencia de entrada.

Recursos

Consulte los siguientes recursos para obtener información adicional: