Al completar un proceso de entrenamiento con Entrenar modelo de clasificación de nube de puntos, querrá evaluar los resultados. El objetivo es haber creado un modelo que pueda realizar clasificaciones precisas sobre el tipo de datos para cuya clasificación se diseñó. No significa simplemente rendir bien con los datos utilizados para el entrenamiento, sino rendir bien con datos a los que no se ha expuesto el entrenamiento.

La herramienta Entrenar modelo de clasificación de nube de puntos genera varias cosas para ayudarle a realizar esta evaluación.

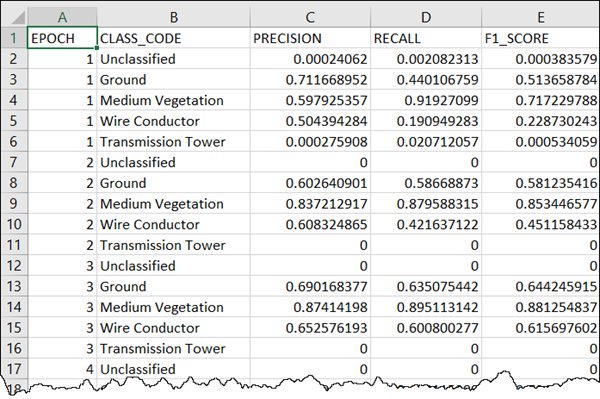

La herramienta también ofrece información de resumen por época mientras se ejecuta la herramienta. También se ofrece como salida el tiempo transcurrido por época, que le ayudará a determinar cuánto tiempo tomará el proceso si se ejecutan todas las épocas. Puede ver las métricas informadas en los mensajes de la herramienta. Se calcula el promedio de Precisión, Coincidencia y Puntuaciones F1 para todas las clases que utilizan una misma ponderación por clase, una media macro.

Para interpretar estas métricas, necesitará comprender un poco su significado. A continuación, se proporciona información introductoria, pero se recomienda que aprenda más por su cuenta sobre estas estadísticas y cómo utilizarlas e interpretarlas en los numerosos recursos disponibles sobre el tema.

Precisión: el porcentaje de puntos predichos correctamente en relación con el total. Tenga en cuenta que no es una métrica útil si existen puntos para clases importantes en cantidades pequeñas en comparación con otras clases. Esto se debe a que puede obtener un alto porcentaje de predicciones correctas en general y predecir incorrectamente pocos puntos, pero importantes.

Precisión: la fracción de predicciones correctas de una clase con respecto a todos los puntos predichos para estar en esa clase, tanto correctas como incorrectas.

Coincidencia: la fracción de predicciones correctas de una clase con respecto a todos los puntos que pertenecen realmente a la clase.

Puntuación F1: el valor medio armónico entre la precisión y la coincidencia.

La herramienta de entrenamiento genera también un gráfico de curvas de aprendizaje. Se puede ver en los mensajes de la herramienta y también se escribe en la carpeta del modelo de salida, en un archivo denominado model_metrics.html. El gráfico incluye curvas de pérdidas para el entrenamiento y la validación. Es mejor que haya menos pérdida, por lo que le conviene ver curvas que disminuyen con el tiempo y se nivelan. La pérdida de entrenamiento muestra lo bien entrenado que está el modelo y la pérdida de validación muestra el grado de generalización del aprendizaje.

Puede comprobar si el modelo está ajustado en exceso o en defecto consultando las curvas de pérdidas. Un modelo ajustado en defecto es incapaz de aprender el dataset de entrenamiento o necesita más entrenamiento. Los modelos ajustados en defecto se pueden identificar por una pérdida de entrenamiento plana o con ruido de principio a fin o que va disminuyendo hasta el final sin nivelarse. Los modelos ajustados en exceso han aprendido los datos de entrenamiento demasiado bien, pero no generalizarán para hacer un buen trabajo con otros datos. Puede identificar los modelos ajustados en exceso por una pérdida de validación que decrece hasta un punto, pero luego empieza a aumentar, o nivelarse, en relación con la pérdida de entrenamiento. Un buen ajuste se identifica generalmente por unas pérdidas de entrenamiento y validación que decrecen hasta un punto de estabilidad con un mínimo espacio entre los dos valores finales de pérdida.

Una de ellas es un archivo de texto *.csv llamado model_name_Statistics.csv que se coloca en la carpeta del modelo de salida. Contiene Precisión, Coincidencia y Puntuaciones F1 para cada clase por época.

Además de revisar métricas y curvas de aprendizaje, puede intentar utilizar el modelo resultante en datos distintos de los datos de entrenamiento y validación. Revise los resultados examinando la nube de puntos en una escena 3D con puntos simbolizados por código de clase.