Un flujo de trabajo típico de aprendizaje automático (ML) empieza por identificar el problema empresarial y formular la declaración o la pregunta del problema. A ello le siguen una serie de pasos, incluidos: preparación de datos (o preprocesamiento), ingeniería de entidades, selección de un algoritmo adecuado y entrenamiento de un modelo, ajuste de hiperparámetros y evaluación del modelo. Es un proceso iterativo y el modelo óptimo se alcanza a menudo solo después de varias iteraciones y experimentos.

Identificar el modelo que mejor se ajuste a los datos lleva tiempo, esfuerzo y experiencia en el proceso ML. La herramienta Entrenar con AutoML automatiza todo este flujo de trabajo e identifica el mejor algoritmo con el mejor conjunto de hiperparámetros que se ajustan a los datos. Esta implementación se basa en una implementación de código abierto denominada mljar-supervised. En los siguientes párrafos se describe cada uno de los pasos del proceso de AA.

Flujo de trabajo de la herramienta Entrenar con AutoML

La herramienta Entrenar con AutoML automatiza lo siguiente:

- Preprocesamiento de datos: los proyectos de AA exitosos requieren la recopilación de datos de entrada de alta calidad que abordan un problema específico. Estos datos pueden proceder de fuentes de datos dispares y tal vez sea necesario combinarlos. Una vez que se hayan recopilado y sintetizado los datos, es necesario limpiarlos y eliminar el ruido para garantizar que los algoritmos de AA puedan entrenarse eficazmente con ellos y aprender de estos. Este paso suele requerir tiempo y ser tedioso y puede requerir conocimientos y experiencia detallados y específicos de un dominio. La limpieza de datos puede implicar identificar y manejar los valores que faltan, detectar valores atípicos, corregir datos mal etiquetados, etc., y todo pueden requerir una gran cantidad de tiempo y esfuerzo del profesional de AA. Estos son los pasos de preprocesamiento:

- Eliminar valores atípicos: los valores atípicos son puntos de datos que no son similares al resto de puntos de datos. Entre los motivos de estos valores atípicos se encuentran errores en la introducción de datos, errores de medición de datos o una disimilitud legítima. Independientemente de la causa, es importante eliminar los valores atípicos de los datos, ya que tienden a confundir al modelo durante la fase de entrenamiento. Los métodos comunes de direccionamiento de valores atípicos son corregir manualmente las entradas o eliminar las entradas del dataset.

- Reducir los valores que faltan: es posible que falten entradas en algunas columnas del dataset. Los modelos de aprendizaje automático no se pueden entrenar si faltan entradas en los datos de entrenamiento. Para asegurarse de que no falten entradas en el dataset, rellene las entradas que faltan con datos válidos mediante el uso de las entradas de datos. Las estrategias para rellenar estas entradas que faltan incluyen agregar la ocurrencia más común del valor o agregar un nuevo valor para resaltar que faltan datos. Para los datos numéricos, una estrategia consiste en utilizar la media o la mediana de todas las entradas de la columna de datos que faltan. Actualmente, se puede determinar ejecutando la herramienta Rellenar valores que faltan. La herramienta Rellenar valores que faltan le permite imponer no solo con una estadística global de la columna, sino también utilizando estrategias espaciales como vecinos locales y vecinos espacio-tiempo, o estrategias temporales como, por ejemplo, valores de serie temporal.

- Escalar y normalizar los datos: una de las suposiciones básicas cuando se entrena un modelo de aprendizaje automático de un modelo lineal como OLS (los residuales), es que los datos que se están entrenando se distribuyen de la forma habitual; es decir, siguen una curva de campana.

Antes de utilizar un modelo lineal, asegúrese de que cada una de las columnas del dataset esté distribuida de forma normal. Si alguna de las columnas no está distribuida de forma normal, las transformaciones se aplican normalmente a los datos para convertirlos a una distribución normal.

Asegúrese de que todas las columnas del dataset estén en la misma escala para que el modelo no otorgue importancia a las columnas cuyos valores caen en la escala más grande. Se realiza aplicando técnicas de escalado en el dataset.

Si bien lo anterior podría ser cierto para los modelos lineales, otros algoritmos, por ejemplo, la regresión logística y los modelos basados en árboles, como árbol de decisión, árbol extra, bosque aleatorio, XGBoost y LightGBM, no asumen ninguna normalidad y son más sólidos ante las diferencias de escala, las distribuciones sesgadas, etc.

- Convertir datos de categorías a numéricos: la mayoría de modelos de aprendizaje automático requiere que los datos que se utilicen para el entrenamiento se presenten en forma de números. No pueden trabajar con otros tipos de datos. Convierta columnas no numéricas tales como State, Country, City o Land cover category, Construction type, Dominant political party, etc., en números. Las técnicas que se utilizan para convertir datos de categorías en números incluyen la codificación de etiquetas y la codificación one-hot.

- AutoML también ofrece la posibilidad de utilizar datos multimodales para modelado, integración de imágenes y texto con datos tabulares. El modelado de datos multimodales puede ayudar a extraer información de varias fuentes de datos. Los modelos tradicionales a menudo dependen de un solo tipo de datos, lo que limita su capacidad para entender por completo la complejidad de los fenómenos del mundo real. El recién implementado modelado multimodal, o datos mixtos, combina los puntos fuertes de las imágenes, el texto y los datos tabulares para proporcionar información más detallada y mejorar el rendimiento predictivo. En primer lugar, se extraen y procesan entidades de cada modalidad mediante la incorporación de texto e imágenes. Luego se concatenan con las entidades tabulares para formar un vector de entidades unificado para cada muestra. El vector de entidades concatenado suele normalizarse para garantizar que las entidades de diferentes modalidades tengan una escala similar. Este vector de entidades combinado que contiene incorporaciones de texto e imágenes, además de entidades tabulares, sirve como entrada en el modelo multimodal. Las imágenes pueden utilizarse mediante el empleo del parámetro Agregar adjuntos de imagen de la herramienta Entrenar con AutoML.

- Ingeniería de entidades y selección de entidades: las columnas que se utilizan durante el proceso de entrenamiento del modelo se denominan entidades. La funcionalidad de estas entidades varía mientras el modelo aprende. Puede que algunas de las entidades no sean útiles y, en tales casos, el modelo mejora cuando las entidades se eliminan del dataset.

Los enfoques como la eliminación recursiva de entidades y las técnicas de entidades aleatorias ayudan a determinar la funcionalidad de las entidades en el dataset y las entidades que no son funcionales en dichos enfoques por lo general se eliminan.

En algunos casos, combinar varias entidades en una sola entidad mejora el modelo. Este proceso se denomina ingeniería de entidades.

Aparte de las nuevas entidades obtenidas al combinar varias entidades de la entrada, la herramienta también crea entidades espaciales con nombres de zone3_id a zone7_id cuando se utiliza la opción Avanzado. Estas nuevas entidades se generan asignando la ubicación de las entidades de entrenamiento de entrada a varias cuadrículas espaciales (hasta cinco) de tamaños diferentes y utilizando los Id. de cuadrícula como variables independientes de categorías con nombres de zone3_id a zone7_id. Proporciona información espacial relevante para los modelos y les ayuda a obtener más información de los datos disponibles.

- Entrenamiento de modelos y selección de modelos: en el paso de entrenamiento del modelo, el profesional de AA elige el algoritmo de AA adecuado en función del problema y las características de los datos. Después, comienza el proceso iterativo de entrenamiento del modelo para que se ajuste a los datos, lo que a menudo incluye experimentar con varios algoritmos de AA diferentes. Cada uno de estos algoritmos puede tener muchos hiperparámetros diferentes, que son valores especificados manualmente por el profesional de AA, los cuales controlan cómo aprende el modelo. A continuación, estos hiperparámetros se adaptan (ajustados) con el objetivo de mejorar el rendimiento del algoritmo y conseguir mejores resultados. Se trata de un proceso iterativo que requiere el tiempo y la experiencia de un profesional de AA. Entre los distintos algoritmos o los modelos estadísticos se encuentran la regresión lineal, la regresión logística y otros modelos de aprendizaje automático incluyen árboles de decisión, bosques aleatorios y modelos de incrementación más recientes como LightGBM y XGBoost. Aunque LightGBM y XGBoost superan a la mayoría de los otros modelos en casi todos los datasets, resulta difícil predecir qué modelos funcionarán bien en un dataset determinado, por lo que debe probar todos los modelos para comparar su rendimiento antes de decidir el modelo que mejor se ajusta a los datos. El mejor modelo de ajuste se puede identificar desde su métrica de modelo. Se devuelven diferentes métricas de modelo tras entrenar la regresión y los modelos de clasificación que ejecutan la herramienta Entrenar con AutoML. Para algunas de estas métricas, un valor más alto indica un modelo mejor y para otros, un valor más bajo indica un modelo mejor. Esto se resume en la siguiente tabla:

Modelo Valor bajo (mejor modelo) Valor alto (mejor modelo) Regresión

MSE, RMSE, MAE, MAPA

R2, Spearman, puntuaciones de Pearson

Clasificación

Logloss

AUC, F1

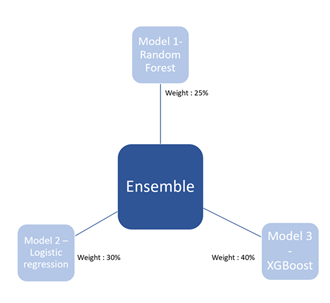

En la mayoría de los casos, combinar varios modelos en uno y tomar la salida de este modelo combinado supera el resultado de un único modelo. Este paso se denomina ensamblaje de modelos.

- Ajuste de hiperparámetros: aunque la mayoría de los pasos anteriores eran iterativos, el paso que suele resultar más difícil al entrenar modelos de aprendizaje automático es el ajuste de hiperparámetros.

Los hiperparámetros se pueden considerar como indicadores que vienen con cada modelo. Los hiperparámetros que se utilizan para entrenar un modelo de Bosque aleatorio difieren de los utilizados para entrenar un modelo LightGBM. Conocer estos hiperparámetros le ayudará a comprender el modelo.

- Selección de modelos: el paso final del flujo de trabajo de AA es la evaluación del modelo, donde se valida que el algoritmo de AA entrenado y ajustado se generalizará bien para los datos en los que no se ajustó. A menudo, estos datos sin utilizar se denominan conjunto de pruebas o validación y se mantienen separados del resto de datos que se utilizan para entrenar el modelo. El objetivo de este paso final es garantizar que el algoritmo de AA produce una precisión predictiva aceptable en datos nuevos.

En el flujo de trabajo de AA existen distintos grados de aportación, toma de decisiones y elección humanas en cada paso.

- ¿Se han recopilado los datos adecuados para abordar el problema y había suficientes datos?

- ¿Qué implica un valor atípico en el contexto de los datos?

- Si se encuentran valores que faltan, ¿qué debería reemplazarlos?

- ¿Qué entidades se deben incluir en el modelo de AA?

- ¿Qué algoritmo de AA se debe utilizar?

- ¿Cuál es un nivel aceptable de rendimiento para el modelo?

- ¿Cuál es la mejor combinación de hiperparámetros para un modelo?

Esta última opción puede conllevar potencialmente cientos o incluso miles de combinaciones de hiperparámetros que se pueden iterar. Agregue varios escenarios de ingeniería de entidades diferentes y el entrenamiento y ajuste de varios algoritmos de AA diferentes; y el proceso empezará a ser inmanejable e improductivo. Además, varios de los pasos del flujo de trabajo de AA requieren conocimientos técnicos expertos de técnicas de ciencia de datos, estadísticas y algoritmos de aprendizaje automático. Por ello, diseñar y ejecutar proyectos de AA puede llevar mucho tiempo, ser laborioso y costoso y, a menudo, depender de profesionales de AA formados y científicos de datos.

En la última década, el aprendizaje automático ha experimentado un crecimiento considerable tanto en el rango de aplicaciones en las que se aplica como en la cantidad de nuevas investigaciones producidas sobre el mismo. Algunas de las fuerzas que más impulsan este crecimiento son la maduración de los propios métodos y algoritmos de AA, la generación y proliferación de volúmenes de datos de los que aprenden los algoritmos, la computación barata para ejecutar los algoritmos y el creciente conocimiento entre las empresas de que los algoritmos de AA pueden abordar complejos problemas y estructuras de datos.

Muchas organizaciones desean usar AA para aprovechar sus datos y derivar nuevas perspectivas ejecutables a partir de este, pero existe un desequilibrio entre el número de posibles aplicaciones de AA y la cantidad de profesionales expertos de AA formados para utilizarlas. Como resultado, existe una creciente demanda de estandarizar el AA en todas las organizaciones creando herramientas que hagan que el AA sea comúnmente accesible en toda la organización y que puedan utilizarlo expertos de dominio y personas no expertas en AA.

Recientemente, el Aprendizaje automático automatizado (AutoML) se ha convertido en una forma de abordar la enorme demanda de AA dentro de las organizaciones en todos los niveles de experiencia/conocimientos. AutoML tiene por objetivo crear un único sistema para automatizar (es decir, eliminar las aportaciones humanas) en la mayor medida de lo posible del flujo de trabajo de AA, incluida la preparación de datos, la ingeniería de entidades, la selección de modelos, el ajuste de hiperparámetros y la evaluación del modelo. Al hacerlo, puede ser beneficioso para los usuarios que no sean expertos gracias a reducir su barrera de aportación al AA, pero también para los profesionales de AA formados eliminando algunos de los pasos más tediosos y lentos del flujo de trabajo de AA.

AutoML para usuarios no expertos en AA (analista SIG/analista de negocio/analista de datos que son expertos de dominio): la ventaja clave de usar AutoML es que elimina algunos de los pasos del flujo de trabajo de AA que requieren la comprensión y los conocimientos expertos más técnicos. Los analistas que son expertos de dominio pueden definir su problema empresarial y recopilar los datos adecuados, y dejar que el equipo aprenda a hacer el resto. No necesitan comprender en profundidad las técnicas de ciencia de datos para la limpieza de datos y la ingeniería de entidades, no conocen la función de los diferentes algoritmos de AA y no necesitan dedicar tiempo a explorar los diferentes algoritmos y configuraciones de hiperparámetros. En su lugar, estos analistas pueden centrarse en la aplicación de su experiencia de dominio a una aplicación de dominio o problema empresarial específico. Además, pueden ser menos dependientes de científicos de datos formados y de ingenieros de AA de su organización, ya que pueden crear y utilizar modelos avanzados por su cuenta, a menudo sin necesidad de experiencia de codificación.

AutoML para los expertos en ML (geólogos de datos o ingenieros ML): AutoML también puede ser beneficioso para expertos ML. Con AutoML, los expertos en AA no tienen que dedicar mucho tiempo a ayudar a los expertos de dominio de su organización y, por tanto, pueden centrarse en su propio trabajo con AA más avanzado. AutoML también puede ahorrar tiempo y aumentar la productividad. Muchos de los pasos tediosos y lentos del flujo de trabajo de AA como la limpieza de datos, la ingeniería de entidades, la selección de modelos y el ajuste de hiperparámetros, se pueden automatizar. El tiempo que se ahorra al automatizar estos pasos exploratorios y repetitivos se puede utilizar en tareas técnicas más avanzadas o tareas que requieren más aportación humana (p. ej., la colaboración con expertos de dominio, la comprensión del problema empresarial o la interpretación de los resultados de AA).

AutoML también puede ayudar a potenciar la productividad de los profesionales de AA, ya que elimina algunas de las opciones subjetivas y la experimentación implicadas en el flujo de trabajo de AA. Por ejemplo, un profesional de AA que aborde un nuevo proyecto puede tener la formación y los conocimientos expertos necesarios para guiarlo a la hora de crear nuevas entidades y decidir qué algoritmo de AA podría ser el mejor para un problema concreto y qué hiperparámetros serían los más óptimos. Sin embargo, pueden pasar por alto la construcción de determinadas entidades nuevas o no probar todas las combinaciones diferentes de hiperparámetros posibles al llevar a cabo el flujo de trabajo de AA. Además, el profesional de AA puede sesgar el proceso de selección de entidades o la elección de un algoritmo porque prefiera un algoritmo de AA concreto en función de su trabajo anterior o su éxito en otras aplicaciones de AA. En realidad, ningún algoritmo de AA funciona mejor en todos los datasets, algunos algoritmos de AA son más sensibles que otros a la selección de hiperparámetros y muchos problemas empresariales tienen distintos grados de complejidad y requisitos para la interpretación de los algoritmos de AA utilizados para resolverlos. AutoML puede ayudar a reducir parte de esta influencia humana aplicando muchos algoritmos de AA diferentes al mismo dataset y determinando después cuál de ellos funciona mejor.

Para el profesional de AA, AutoML también puede servir como punto de partida inicial o punto de referencia en un proyecto de AA. Pueden utilizarlo para desarrollar automáticamente un modelo base para un dataset, lo que les puede proporcionar un conjunto de percepciones preliminares sobre un problema concreto. Pueden decidir agregar o eliminar determinadas entidades del dataset de entrada o centrarse en un algoritmo de AA específico y ajustar sus hiperparámetros. En este sentido, AutoML puede ser visto como una forma de limitar el conjunto de opciones iniciales para un profesional de AA formado, de forma que puedan centrarse en mejorar el rendimiento del sistema de AA en general. Este es un flujo de trabajo muy común, donde los expertos en AA desarrollarán un punto de referencia basado en datos mediante AutoML y lo aprovecharán incorporando sus conocimientos para perfeccionar los resultados.

Estandarizar el AA con AutoML dentro de una organización permite a los expertos de dominio centrar su atención en el problema empresarial y obtener resultados ejecutables, permite a más analistas crear mejores modelos y puede reducir el número de expertos en AA que la organización necesita contratar. También puede ayudar a potenciar la productividad de los expertos en AA y científicos de datos formados, lo que les permite concentrarse en el resto de diversas tareas en las que más se les necesita.

Identificar el mejor modelo

Para identificar el mejor modelo usando la herramienta Entrenar con AutoML, siga estos pasos:

- Ejecute algoritmos simples, como un árbol de decisión (un árbol simple con una profundidad máxima de 4) y modelos lineales.

Esto permite un examen rápido de los datos y de los resultados esperados.

- Entrene los modelos seleccionados desde el paso anterior con parámetros predeterminados. Ejecute los datos mediante un conjunto de algoritmos más complejos utilizando solo los hiperparámetros predeterminados.

Se prueba un ajuste de modelo para cada algoritmo y para todos los algoritmos disponibles. Los algoritmos disponibles son Lineal, Bosque aleatorio, XGBoost, LightGBM, Árbol de decisión y Árbol extra.

- Realice una búsqueda aleatoria sobre el espacio de hiperparámetros de cada algoritmo individual para encontrar el conjunto óptimo de hiperparámetros.

- Construya entidades nuevas utilizando las llamadas "entidades de oro" (golden features). Determine cuáles de las nuevas entidades tienen capacidades predictivas y agréguelas al dataset original.

En este paso, se utiliza el mejor conjunto de hiperparámetros identificados en el paso anterior.

- Utilice el conjunto óptimo de hiperparámetros determinado en el paso 4 para entrenar un modelo de mejor rendimiento para cada algoritmo y determine las entidades menos importantes y elimínelas.

Se ensamblan los resultados de los mejores modelos entrenados hasta el momento. Los modelos se apilan y se combinan los resultados de los mejores modelos (incluidos los apilados).

Crear un conjunto

Un ensamblaje es un conjunto de modelos cuyas predicciones se combinan por promedios o votos ponderados.

Las estrategias más comunes que se utilizan para ensamblar son bagging (Bosques aleatorios es un ejemplo clásico de bagging) y refuerzo (XGBoost es un ejemplo de refuerzo), los cuales combinan las salidas de los modelos que pertenecen a los mismos algoritmos. Las técnicas recientes, como las mencionadas en Ensemble Selection from Libraries of Models (Caruana et. al 2004), combinan diversos modelos.

Para crear un conjunto, siga estos pasos:

Comience con el ensamblaje vacío.

- Agregue el modelo a la biblioteca que maximiza el rendimiento del ensamblaje a la métrica del error en un conjunto de validación.

- Repita el paso anterior para un número fijo de iteraciones o hasta que se hayan utilizado todos los modelos.

- Devuelva el ensamblaje del conjunto anidado de ensamblajes que tiene un rendimiento máximo en el conjunto de validación.

El apilado de modelos también implica combinar los resultados de varios modelos y obtener el resultado de esta combinación.

Aunque los planteamientos de ensamblaje combinan los resultados de varios modelos aplicando ponderaciones diferentes a las salidas, el apilado utiliza los resultados de cada uno de los modelos base como entidades y los agrega a un modelo de mayor nivel, un metamodelo. La salida del metamodelo de mayor nivel se utiliza como la salida final.

Para mejorar el rendimiento, puede crear pilas de modelo y combinar sus salidas para formar una pila de ensemble.

Interpretar los informes de salida

La herramienta Entrenar con AutoML puede generar un informe HTML como salida.

La página principal del informe muestra la tabla de clasificación. La misma información también está disponible en la ventana de salida de la herramienta.

La tabla de clasificación muestra los modelos evaluados y su valor métrico. Para el problema de regresión, el modelo con el menos RMSE se considera el mejor modelo (en este caso, el modelo de conjunto). Será diferente (por ejemplo, logloss) para problemas de clasificación.

El diagrama de caja de rendimiento AutoML siguiente compara la métrica de evaluación de distintos modelos con una métrica de evaluación (RMSE) en el eje y y los modelos del eje x, como se muestra a continuación. El diagrama de caja muestra que el mejor modelo es el modelo de conjunto que tiene el RMSE más bajo.

El gráfico de rendimiento de AutoML que aparece a continuación muestra cómo la métrica de evaluación para el modelo de mejor rendimiento, que en este caso es el modelo de conjunto, varía entre las diferentes iteraciones. El gráfico de iteración puede ayudarle a entender la coherencia del modelo en diferentes ejecuciones del modelo.

La correlación de Spearman mostrada a continuación se genera para todos los modelos que se evaluaron, y los modelos que están más estrechamente relacionados se muestran en tonos azules más oscuros. Por ejemplo, las salidas de LightGBM y XGBoost son las más relacionadas (según lo esperado, ya que ambas son algoritmos de refuerzo). La salida de LightGBM se parece a la salida de Bosque aleatorio en comparación con la salida de Árboles extra.

Desde la tabla de clasificación puede hacer clic en el vínculo de cualquiera de los modelos de la columna Name para ir a una página que muestra los hiperparámetros que se finalizaron para el entrenamiento del modelo después de completar el ajuste de hiperparámetros. En este ejemplo, el árbol de decisión se entrenó con un valor max_depth de 3.

La misma página también muestra otras métricas aparte de la que se utilizó para la evaluación. En el siguiente ejemplo, que era una tarea de regresión, se utilizaron las métricas MAE, MSE, RMSE, R2 y MAPE para la evaluación del modelo.

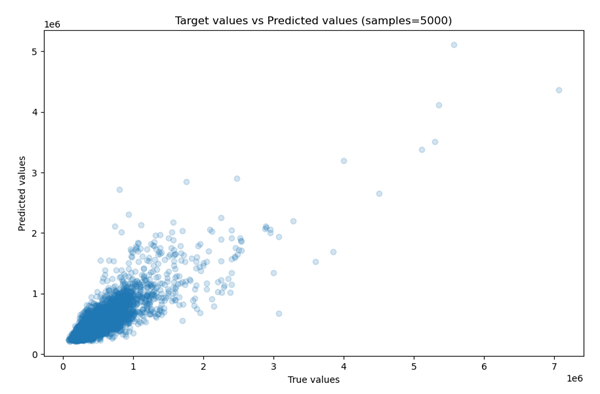

También se muestra el gráfico de dispersión de las salidas reales y previstas (para una muestra de 5000 puntos de datos).

Puede utilizar este gráfico para determinar el rendimiento del modelo. Las cifras anteriores muestran la comparación de los gráficos de dispersión de dos modelos obtenidos a partir del informe. El segundo modelo tiene un mejor rendimiento que el primero, donde los valores predichos y observados divergen más.

Para que los modelos sean más explicables, la importancia de cada variable en el modelo final también se incluye en el informe (similar a la importancia de las entidades en sklearn). A diferencia de sklearn, este gráfico también se puede generar para modelos de sklearn que no sean de árbol. Esta capacidad de explicación de modelo para modelos que no están basados en árboles la ofrece SHapley Additive exPlanations (SHAP).

SHAP es un enfoque de teoría de juegos para explicar el resultado de cualquier modelo de aprendizaje automático. Conecta la asignación óptima de créditos con explicaciones locales utilizando los valores clásicos de Shapley de la teoría de juegos y sus extensiones relacionadas. Encontrará detalles sobre SHAP y su implementación en la carpeta GitHub de SHAP. La salida SHAP solo está disponible con la opción Básica.

En el gráfico siguiente, puede visualizar el impacto global de cada variable del dataset de viviendas en el modelo entrenado. Ello demuestra que la entidad sqft_living es la que más influye en el modelo y la más importante, seguida del número de cuartos de baño y habitaciones al predecir los precios de las viviendas.

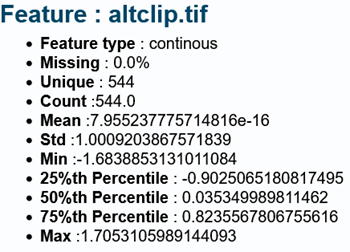

Con la opción Básico, también cuenta con la opción de ver el informe de análisis de datos exploratorios automático (informe EDA), que imprime estadísticas de resumen para la variable objetivo y los indicadores utilizados en el entrenamiento de modelos. El siguiente es un informe EDA de muestra para una variable denominada altclip.tif:

Predecir con la herramienta AutoML

La herramienta Predecir con AutoML predice variables continuas (regresión) o variables de categorías (clasificación) en datasets compatibles sin tener en cuenta un modelo DLPK entrenado producido por la herramienta Entrenar con AutoML.

La entrada es un archivo de definición de modelo de Esri (.emd) o un archivo de paquete de aprendizaje profundo (.dlpk), que se puede crear con la herramienta Entrenar con AutoML.

Algunas de las salidas opcionales que genera la herramienta Predecir con AutoML, además de la predicción, se definen mediante los siguientes parámetros y campo:

Obtener explicación para cada predicción: este parámetro se usa para estimar la importancia variable local y resulta útil para comprender un modelo a escala local. Si el parámetro está activado, se genera importancia variable local para todas las variables explicativas, incluidas las entidades explicativas, los rásteres explicativos y las entidades de distancia explicativas. Se agrega una puntuación de porcentaje para las variables explicativas que representan la importancia de la variable local para los valores predichos en la ubicación correspondiente al valor del parámetro Entidades de predicción de salida. Por ejemplo, si se utilizan indicadores denominados var1, var2 y var3 para entrenar el modelo, que puede ser una variable de entidad, un ráster o campos de variable de distancia denominados var1_imp, var2_imp y var3_imp para cada muestra en el valor de Entidades de predicción de salida:

La importancia variable mostrará la importancia variable de cada indicador por ubicación, lo cual también revelará la intensidad y la debilidad de cada indicador que contribuye a las predicciones locales. Este parámetro está activo cuando el parámetro Tipo de predicción se especifica como Predecir entidad.var1_imp var2_imp var3_imp 0,26

0,34

0,40

0,75

0,15

0,10

- Puntuación de confianza: esta puntuación muestra el nivel de confianza del modelo para la clase predicha devuelta por el modelo. Solo está disponible para un problema de clasificación y se agregará un campo prediction_confidence a la tabla de atributos de salida que muestra los valores de puntuación que varían de 0 a 1, lo que representa una probabilidad baja a alta de la clase correcta. Este campo puede ayudar a identificar predicciones con mayor confianza y predicciones menos seguras.

Referencias

Caruana, Rich, Alexandru Niculescu-Mizil, Geoff Crew y Alex Ksikes. 2004 "Conjunto de selección de bibliotecas de modelos". Proceedings of the 21st International Conference on Machine Learning. Banff, Canadá. Conjunto de selección de bibliotecas de modelos.