L’analyse de régression permet de comprendre, de modéliser, de prédire et d’expliquer des phénomènes complexes. Elle vous aide à répondre à des questions telles que « Pourquoi existe-t-il des endroits aux États-Unis dont les résultats d’examens sont constamment supérieurs à la moyenne nationale ? » ou « Pourquoi certaines zones de la ville présentent-elles des taux aussi élevés de cambriolage de maisons d’habitation ? ». Vous pouvez utiliser l'analyse de régression pour expliquer l'obésité infantile, par exemple, à l'aide d'un ensemble de variables tels que les revenus, l'éducation et l'accès à une alimentation saine.

L’analyse de régression vous aide à répondre à ces questions pour vous permettre de remédier à ces problèmes. Si, par exemple, vous découvrez que l’obésité infantile est plus faible dans les écoles qui servent des fruits et des légumes frais au déjeuner, vous pouvez utiliser ces informations pour mettre au point une stratégie et prendre des décisions concernant les programmes de repas scolaires. De même, en connaissant les variables qui aident à expliquer des taux de criminalité élevés, vous pouvez faire des prévisions concernant la criminalité future afin que des ressources de prévention soient allouées plus efficacement.

Voici ce que l'on vous dit sur l'analyse de régression.

Ce que l’on ne vous dit pas est qu’il n’est pas toujours facile de trouver un ensemble de variables explicatives permettant de répondre à des questions ou d’expliquer le phénomène complexe que l’on tente de modéliser. L’obésité infantile, la criminalité, les résultats d’examens et presque tout ce que vous voulez modéliser à l’aide de l’analyse de régression sont des problèmes compliqués qui ont rarement des réponses simples. Mais si vous avez déjà essayé de créer votre propre modèle de régression, vous savez déjà tout cela.

Heureusement, lorsque vous exécutez l’outil Régression linéaire généralisée, un jeu de diagnostics vous permet de déterminer si vous disposez d’un modèle correctement spécifié, et donc fiable. Le présent document examine et explique plusieurs de ces vérifications auxquelles soumettre votre modèle pour vous assurer qu’il est fiable. Ces diagnostics, ainsi que les techniques disponibles pour résoudre certains des problèmes les plus courants en matière d’analyse de régression, sont des ressources qui peuvent faciliter votre travail.

Astuce :

Une fois que vous avez assimilé les informations présentées ci-après, libre à vous d’utiliser l’outil Régression exploratoire pour rechercher un modèle remplissant tous les critères de la méthode de régression linéaire généralisée (GLR).

Prise en main

Commencez par choisir la variable que vous voulez comprendre, prévoir ou modéliser. Cette variable est appelée « variable dépendante ». L'obésité infantile, la criminalité et les résultats d'examens sont les variables dépendantes modélisées dans les exemples ci-dessus.

Vous devez ensuite déterminer quels facteurs peuvent expliquer votre variable dépendante. Ces variables sont appelées « variables explicatives ». Dans l’exemple concernant l’obésité infantile, les variables explicatives sont des facteurs tels que les revenus, l’éducation et l’accès à une alimentation saine. Vous devrez effectuer des recherches pour identifier toutes les variables explicatives pouvant être importantes. Étudiez les théories et consultez la documentation existante, parlez aux experts, et fiez-vous toujours à votre bon sens. Les recherches préliminaires que vous effectuez augmentent vos chances de trouver un modèle approprié.

Une fois la variable dépendante et les variables explicatives candidates sélectionnées, vous êtes prêt à effectuer votre analyse. Il est préconisé de commencer l’analyse de régression à l’aide de l’outil Régression linéaire généralisée ou de l’outil Régression exploratoire, car ils permettent d’effectuer des tests de diagnostic importants pour déterminer si vous avez trouvé un modèle utile ou si vous devez poursuivre votre travail.

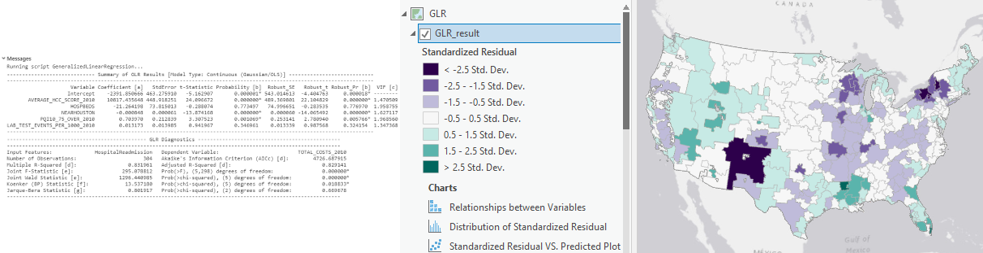

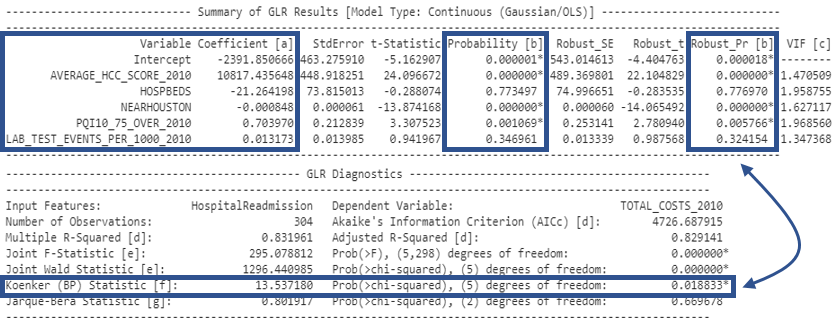

L’outil Régression linéaire généralisée produit plusieurs sorties, dont une carte des valeurs résiduelles de régression, des graphiques et un rapport récapitulatif. La carte des valeurs résiduelles de régression indique les sous-estimations et surestimations de votre modèle. L’analyse de cette carte est donc une étape importante dans la recherche d’un bon modèle. Le rapport récapitulatif est principalement numérique et inclut tous les diagnostics que vous utiliserez dans les six vérifications décrites ci-dessous.

Six tests de diagnostic

Vérification 1 : ces variables explicatives améliorent-elles mon modèle ?

Après avoir consulté les théories et la recherche existantes, vous avez identifié un ensemble de variables explicatives candidates. Vous avez de bonnes raisons de les inclure dans votre modèle. Cependant, après avoir exécuté votre modèle, vous constatez que certaines de vos variables explicatives sont statistiquement significatives et que d'autres ne le sont pas.

Comment savoir quelles variables explicatives sont significatives ? L’outil Régression linéaire généralisée calcule un coefficient pour chaque variable explicative du modèle et effectue un test statistique pour déterminer si une variable améliore ou non votre modèle. Le test statistique calcule la probabilité que le coefficient soit réellement égal à zéro. Si le coefficient est zéro (ou très proche de zéro), la variable explicative associée n’est pas utile pour votre modèle. Toutefois, si le test statistique renvoie une probabilité faible (valeur p) pour une variable explicative spécifique, cela indique qu’il est peu probable (il existe une faible probabilité) que le coefficient soit égal à zéro. Lorsque la probabilité est inférieure à 0,05, la présence d’un astérisque en regard de la probabilité, sur le rapport récapitulatif de l’outil Régression linéaire généralisée, indique que la variable explicative associée est importante pour votre modèle (en d’autres termes, le coefficient est statistiquement significatif avec un niveau de confiance de 95 pour cent). Vous recherchez donc des variables explicatives associées à des probabilités statistiquement significatives (recherchez celles qui sont signalées par des astérisques).

L’outil Régression linéaire généralisée calcule la probabilité et la probabilité robuste pour chaque variable explicative. Avec les données spatiales, il n’est pas rare que les relations que vous modélisez varient dans la zone d’étude. De telles relations sont appelées « non stationnaires ». Si les relations sont non stationnaires, vous ne pouvez vous fier qu'aux probabilités robustes pour déterminer si une variable explicative est statistiquement significative.

Comment savoir si les relations de votre modèle sont non stationnaires ? Un autre test statistique inclus dans le rapport récapitulatif de l’outil Régression linéaire généralisée est la statistique de Koenker (Statistique Breusch-Pagan avec transformation de Student de Koenker) relative à la non-stationnarité. Un astérisque en regard de la valeur p de Koenker indique que les relations que vous modélisez présentent une non stationnarité statistiquement significative. Prenez donc soin de consulter les probabilités robustes.

En général, vous supprimez de votre modèle les variables explicatives qui ne sont pas statistiquement significatives. Cependant, si la théorie indique qu'une variable est très importante, ou si une variable donnée est le point central de votre analyse, vous pourrez la conserver même si elle n'est pas statistiquement significative.

Remarque :

Au cours de la recherche d’un modèle de régression linéaire généralisée correctement spécifié, vous aller probablement essayer diverses variables explicatives. Notez que les coefficients de variables explicatives (et leur signification statistique) peuvent changer radicalement selon la combinaison de variables que vous incluez dans votre modèle.

Vérification 2 : les relations sont-elles celles que j'attendais ?

Il est important de déterminer si une valeur explicative aide votre modèle, mais il faut également vérifier le signe (+/-) associé à chaque coefficient pour vous assurer que la relation est ce que vous attendiez. Le signe du coefficient d’une variable explicative indique si la relation est positive ou négative. Supposons que vous modélisiez la criminalité, par exemple, et qu’une de vos variables explicatives soit les revenus moyens des habitants d’un quartier. Si le coefficient de la variable des revenus est un nombre négatif, cela signifie que la criminalité diminue à mesure que les revenus des habitants du quartier augmentent (relation négative). Supposons maintenant que vous modélisiez l'obésité infantile et que la variable représentant l'accessibilité au fast-food ait un coefficient positif. Cela indiquerait que l'obésité infantile tend à augmenter à mesure que l'accès au fast-food augmente (relation positive).

Lorsque vous créez votre liste de variables explicatives candidates, vous devez inclure, pour chaque variable, la relation (positive ou négative) que vous attendez. Il semble difficile de se fier à un modèle indiquant des relations non conformes à la théorie ou au bon sens. Supposons que vous créiez un modèle afin de prévoir la fréquence des feux de forêts et que votre modèle renvoie un coefficient positif pour la variable des précipitations. Vous ne vous attendez probablement pas à ce que les feux de forêts augmentent dans les endroits à fortes précipitations.

Les signes de coefficients inattendus sont souvent révélateurs d’autres problèmes avec votre modèle que les tests de diagnostic suivants font faire apparaître. Vous pouvez vous fier au signe et à la force des coefficients de vos variables explicatives seulement si votre modèle répond à tous les critères vérifiés. Si vous trouvez un modèle satisfaisant à toutes les vérifications malgré le signe de coefficient inattendu, vous avez sans doute eu l’occasion d’apprendre quelque chose. Il existe peut-être une relation positive entre la fréquence des feux de forêts et les précipitations car la source principale des feux de forêts dans votre zone d’étude est la foudre. Il peut être utile de rechercher des données concernant la foudre dans votre zone d'étude pour vérifier si cela améliore les performances du modèle.

Vérification 3 : certaines des variables explicatives sont-elles redondantes ?

Lors de la sélection des variables explicatives à inclure dans votre analyse, recherchez des variables qui permettent d’examiner différents aspects de ce que vous essayez de modéliser. Évitez les variables redondantes. Par exemple, si vous essayez de modéliser les valeurs d’habitat, vous n’inclurez probablement pas à la fois les variables explicatives relatives à la surface de la maison et au nombre de chambres qu’elle comporte. Ces deux variables concernant la taille de la maison, vous risquez de déstabiliser votre modèle en les incluant ensemble. En fin de compte, un modèle comportant des variables redondantes n'est pas fiable.

Comment savoir si des variables sont redondantes ? Heureusement, s’il existe plus de deux variables explicatives, l’outil Régression linéaire généralisée calcule un facteur d’inflation de la variance (VIF) pour chaque variable. Ce facteur est une mesure de la redondance des variables et vous permet de décider quelles variables peuvent être supprimées de votre modèle sans compromettre le pouvoir explicatif. En règle générale, une valeur VIF supérieure à 7,5 est problématique. Si deux de vos variables (ou plus) on des valeurs VIF supérieures à 7,5, supprimez-les une par une et exécutez l’outil Moindres carrés ordinaires jusqu’à ce que la redondance ait disparu. Notez qu’il ne faut pas supprimer toutes les variables dont la valeur VIF est élevée. Dans notre exemple de modélisation de la valeur d’habitat, les variables correspondant à la surface de la maison et à son nombre de chambres ont probablement toute les deux une valeur VIF élevée. Dès que vous supprimez une de ces deux variables, la redondance disparaît. L'inclusion d'une variable reflétant la taille de la maison est importante, mais vous ne voulez pas modéliser cet aspect de la valeur des maisons de façon redondante.

Vérification 4 : mon modèle est-il biaisé ?

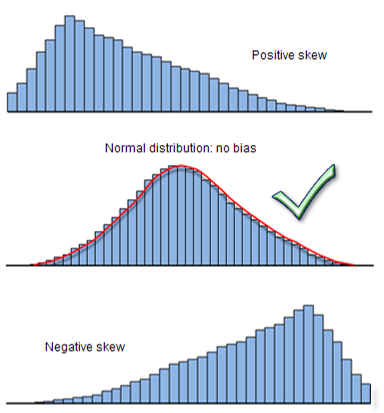

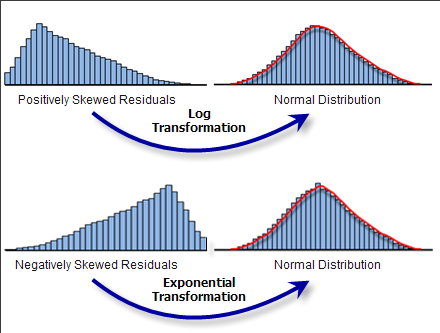

Au premier abord, cela semble être une question difficile. La réponse est en fait très simple. Si votre modèle de régression linéaire généralisée est correctement spécifié, ses valeurs résiduelles (les sous-estimations et surestimations) sont normalement distribuées avec une moyenne de zéro (comme avec une courbe en cloche). Toutefois, si votre modèle est biaisé, la distribution des valeurs résiduelles est déséquilibrée, comme indiqué ci-dessous. Si le modèle est biaisé, les résultats prévus ne sont pas fiables. Il existe plusieurs stratégies pour corriger ce problème.

Un résultat de diagnostic Jarque-Bera statistiquement significatif (signalé par un astérisque) indique que votre modèle est biaisé. Il peut arriver que votre modèle fonctionne pour les valeurs faibles mais ne prévoie pas bien les valeurs élevées (ou inversement). Dans le cas de notre exemple de l’obésité infantile, cela signifie que là où le taux d’obésité infantile est faible, le modèle fonctionne bien, mais que là où il est élevé, les prévisions sont fausses. Le biais d'un modèle peut résulter de points aberrants qui influencent l'estimation du modèle.

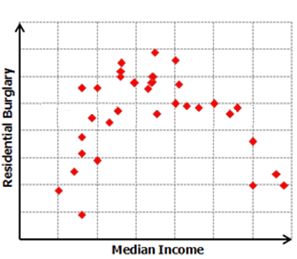

Pour corriger le biais du modèle, créez une matrice de nuages de points pour toutes les variables du modèle. Une relation non linéaire entre une variable dépendante et une des variables explicatives est souvent la cause du biais d’un modèle. De telles relations ressemblent à une ligne courbe dans la matrice de nuages de points. Les relations linéaires ressemblent à des diagonales.

Si vous constatez que votre variable dépendante a une relation non linéaire avec une de vos variables explicatives, vous devez rectifier cette situation. La régression linéaire généralisée est une méthode de régression linéaire qui part du principe que les relations que vous modélisez sont linéaires. Si elles ne le sont pas, vous pouvez essayer de transformer vos variables pour voir si cela crée des relations qui sont plus linéaires. Les transformations logarithmiques et exponentielles sont des transformations courantes. Si certaines de vos variables explicatives sont fortement biaisées, vous pourrez supprimer le biais du modèle en les transformant également.

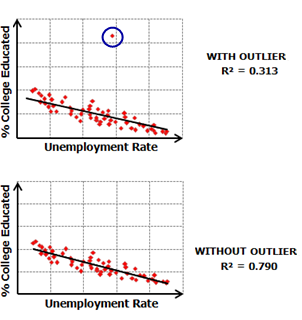

Une matrice de nuages de points révèle également les points aberrants des données. Pour savoir si un point aberrant a une incidence sur votre modèle, exécutez l’outil Régression linéaire généralisée avec et sans point aberrant, puis vérifiez dans quelle mesure cela change les performances du modèle et si sa suppression en corrige le biais. Dans certains cas (surtout si vous pensez que les points aberrants représentent des données incorrectes), vous pourrez éliminer les points aberrants de votre analyse.

Vérification 5 : ai-je trouvé toutes les variables explicatives clés ?

Vous commencez souvent une analyse avec des hypothèses sur les variables qui vont être des prédicteurs importants. Vous pensez peut-être que 5 variables particulières produiront un bon modèle, ou disposez d’une liste clairement définie de 10 variables qui, à votre avis, sont associées. S’il est important d’effectuer une analyse de régression avec une hypothèse, il l’est tout autant de laisser libre cours à votre créativité et à votre perspicacité. Résistez à l’envie de vous limiter à votre liste initiale de variables. Essayez d’envisager toutes les variables possibles pouvant affecter ce que vous modélisez. Créez des cartes thématiques pour chacune de vos variables explicatives candidates et comparez-les à une carte de votre variable dépendante. Consultez les publications sur le sujet. Utilisez votre intuition pour rechercher des relations dans vos données cartographiées. Essayez de trouver autant de variables spatiales candidates que possible, telles que la distance séparant un point d’un centre urbain, la proximité d’axes routiers majeurs ou l’accès à de vastes étendues d’eau. Ces types de variables seront très importants pour les analyses lorsque vous pensez que les processus géographiques influencent les relations entre vos données. En fait, tant que vous n'aurez pas trouvé de variables explicatives capturant efficacement la structure spatiale de votre variable dépendante, il manquera dans votre modèle des variables explicatives essentielles et les tests de diagnostic décrits dans ce document échoueront.

L’autocorrélation spatiale statistiquement significative des valeurs résiduelles de votre modèle prouve qu’il manque des variables explicatives clé. Dans l’analyse de régression, les problèmes de valeurs résiduelles spatialement autocorrélées se traduisent généralement par une agrégation des valeurs : les surestimations s’agrègent, et les sous-estimations également. Comment savoir s’il existe des autocorrélations spatiales statistiquement significatives dans les valeurs résiduelles de votre modèle ? Exécutez l’outil Autocorrélation spatiale sur vos valeurs résiduelles de régression pour vérifier s’il existe un problème d’autocorrélation spatiale. Un score z statistiquement significatif indique qu'il manque des variables explicatives clé à votre modèle.

La détection de ces variables explicatives manquantes est souvent autant un art qu’une science. Essayez les stratégies suivantes pour juger de leur utilité :

Examinez la carte des valeurs résiduelles de la régression linéaire généralisée.

La sortie standard de l’outil de Régression linéaire généralisée est une carte des valeurs résiduelles du modèle. Les zones de couleur violet foncé indiquent que les valeurs réelles (votre variable dépendante) sont supérieures aux prévisions de votre modèle. Les zones de couleur turquoise plus foncée montrent les emplacements où les valeurs réelles sont inférieures aux prévisions. Il suffit parfois de voir la carte des valeurs résiduelles pour avoir une idée de ce qui peut manquer. Si vous remarquez des surestimations constantes dans les zones urbanisées, par exemple, vous pouvez envisager d’ajouter une variable reflétant la distance à destination des centres urbains. S’il semble que des surestimations sont associées à des sommets de montagnes ou des fonds de vallées, vous pouvez envisager l’utilisation d’une variable d’altitude. Voyez-vous des agrégats régionaux, pouvez-vous identifier des tendances dans vos données ? Si oui, il peut être utile de créer une variable fictive pour capturer ces différences régionales. L’exemple classique de variable fictive est une variable qui distingue les entités urbaines des entités rurales. En attribuant la valeur 1 à toutes les entités rurales et la valeur 0 à toutes les autres, vous parviendrez peut-être à capturer les relations spatiales dans le paysage qui peuvent importer pour votre modèle. La création d'une carte en semis de points des valeurs résiduelles du modèle vous permettra de mieux visualiser les configurations régionales dans leurs grandes lignes.

En identifiant les variables spatiales manquantes, vous pouvez améliorer votre modèle, mais également mieux comprendre, et ce, sous un angle différent, le phénomène que vous modélisez.

Remarque :

S’il est utile d’inclure des variables fictives de régime spatial à votre modèle de régression linéaire généralisée, il est préférable de les supprimer avant d’exécuter l’outil Régression pondérée géographiquement pour éviter les problèmes de multicolinéarité locale.

Etudiez la non stationnarité.

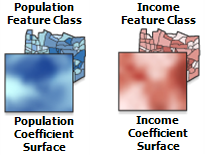

Vous pouvez également essayer d’exécuter l’outil Régression pondérée géographiquement et de créer des surfaces de coefficients pour chacune de vos variables explicatives ou cartes des valeurs R2 locales. Sélectionnez le modèle de régression linéaire généralisée qui fonctionne bien (un modèle avec une valeur R2 élevée et ayant réussi tous les autres tests de diagnostic ou la plupart d’entre eux). La régression pondérée géographiquement créant une équation de régression pour chaque entité de votre zone d’étude, les surfaces de coefficients illustrent les fluctuations géographiques des relations entre la variable dépendante et chaque variable explicative ; la carte des valeurs R2 locales indique des variations du pouvoir explicatif du modèle. Parfois, le fait de voir ces variations géographiques peut donner des indications sur les variables qui peuvent manquer : une baisse du pouvoir explicatif près des principales autoroutes, un déclin selon la distance de la côte, un changement de signe des coefficients près d’une région industrielle ou une tendance ou une limite est-ouest forte. Tous ces éléments sont autant d’informations sur les variables spatiales qui peuvent améliorer votre modèle.

Lorsque vous étudiez les surfaces de coefficients, recherchez les variables explicatives avec des coefficients dont le signe change du positif au négatif. Cela est important dans la mesure où la régression linéaire généralisée ne tient probablement pas compte du potentiel prédictif de ces variables extrêmement non stationnaires. Considérons, par exemple, la relation entre l’obésité infantile et l’accès à des choix d’alimentation saine. Il se peut que, dans des zones à faibles revenus où l’accès à une automobile est plus difficile, l’éloignement d’un supermarché soit un véritable obstacle à des choix alimentaires sains. Cependant, dans les zones à revenus élevés avec un accès plus large à un véhicule, il n’est pas forcément souhaitable d’avoir un supermarché auquel il est possible de se rendre à pied. L’éloignement du supermarché peut ne pas être un obstacle à l’achat d’aliments sains. Si la régression pondérée géographiquement permet la modélisation de ces types de relations complexes, ce n’est pas le cas de la régression linéaire généralisée. La régression linéaire généralisée est un modèle global qui attend des relations constantes entre variables (stationnaires) dans toute la zone d’étude. Lorsque des coefficients changent de signe, ils s’annulent mutuellement. Pensez à (+1) + (-1) = 0. Si vous trouvez des variables où les coefficients changent de façon spectaculaire, particulièrement s’ils changent de signe, conservez-les dans votre modèle même s’ils ne sont pas statistiquement significatifs. Ces types de variables seront efficaces lorsque vous passerez à la régression pondérée géographiquement.

Essayez d’adapter la régression linéaire généralisée à des zones d’études de sous-ensembles plus petites.

La régression pondérée géographiquement est extrêmement utile pour traiter la non-stationnarité, et il peut être tentant de l’effectuer directement, sans trouver d’abord un modèle de régression linéaire généralisée correctement spécifié. Malheureusement, la régression pondérée géographiquement ne dispose pas de tous les tests de diagnostic vous permettant de déterminer si vos variables explicatives sont statistiquement significatives, si vos valeurs résiduelles sont normalement distribuées ou si votre modèle est un bon modèle. La régression pondérée géographiquement ne corrige pas un modèle mal spécifié, à moins que vous soyez certain que la seule raison pour laquelle votre modèle de régression linéaire généralisée a échoué aux six vérifications est le résultat direct de la non-stationnarité. La non-stationnarité est prouvée par la présence de variable explicatives ayant une forte relation positive à certains endroits de la zone d’étude et une forte relation négative à d’autres. Le problème n’est parfois pas dû à des variables explicatives distinctes mais à l’ensemble de variables explicatives utilisées dans le modèle. Il se peut qu’un ensemble de variables fournisse un modèle adapté à une partie de la zone d’étude, mais qu’un ensemble de variables différent fonctionne mieux partout ailleurs. Pour vérifier si c’est le cas, vous pouvez sélectionner des zones d’études de sous-ensembles plus petites et essayer d’adapter les modèles de régression linéaire généralisée à chacune de ces zones. Sélectionnez vos zones de sous-ensembles en fonction des processus qui vous semblent être apparentés à votre modèle (zones de bas revenus par rapport à celles de revenus élevés, habitat ancien par rapport à habitat neuf). Vous pouvez également sélectionner des zones en fonction de la carte de la régression pondérée géographiquement des valeurs R2 locales. Les emplacements où les performances du modèle sont mauvaises peuvent être modélisés de façon plus satisfaisante à l’aide d’un ensemble de variables explicatives différent.

Astuce :

L’outil Agrégation multivariée spatialement contrainte peut se révéler très utile pour identifier des sous-régions de votre zone d’étude générale.

Si vous ne trouvez pas de modèles de régression linéaire correctement spécifiés dans plusieurs petites zones d’études, vous pouvez mettre en cause la non-stationnarité et procéder à la régression pondérée géographiquement avec l’ensemble complet de variables explicatives que vous avez trouvées dans tous les modèles des zones de sous-ensembles. Si vous ne trouvez pas de modèles correctement spécifiés dans les zones de sous-ensembles plus petites, il se peut que vous tentiez de modéliser un phénomène trop complexe pour être réduit simplement à des mesures numériques et des relations linéaires. Dans ce cas, vous devrez probablement envisager d'utiliser d'autres méthodes d'analyse.

Tout ceci représente beaucoup de travail, mais c’est également un bon exercice d’analyse exploratoire de données qui vous aidera à mieux comprendre vos données et à trouver de nouvelles variables à utiliser. Il pourrait même déboucher sur un modèle bien conçu.

Vérification 6 : est-ce que j'explique correctement ma variable dépendante ?

Il est temps maintenant d’évaluer les performances du modèle. La valeur R2 ajusté est importante pour évaluer la capacité de vos variables explicatives à modéliser votre variable dépendante. La valeur R2 est également une des premières choses que les utilisateurs, pour la plupart, apprennent au sujet de l’analyse de régression. Alors pourquoi effectuer cette importante vérification à la fin ? Ce que vous ignorez peut-être, c’est que vous ne pouvez pas vous fier à votre valeur R2 si vous n’avez pas réussi toutes les vérifications décrites ci-dessus. Si votre modèle est biaisé, il peut fonctionner correctement dans certaines zones ou avec une plage spécifique de valeurs de votre variable dépendante, et ne pas fonctionner du tout par ailleurs. La valeur R2 ne reflète pas cette situation. De même, si vos valeurs résiduelles sont spatialement autocorrélées, vous ne pouvez pas vous fier aux relations des coefficients provenant de votre modèle. Avec des variables explicatives redondantes, vous pouvez obtenir des valeurs R2 extrêmement élevées, mais votre modèle sera instable. Il ne reflétera pas les véritables relations que vous tentez de modéliser et peut produire des résultats complètement différents après l’ajout d’une seule observation.

Une fois que vous avez effectué les autres vérifications et que vous êtes sûr que tous les critères requis sont satisfaits, vous pouvez déterminer si votre modèle explique correctement les valeurs de votre variable dépendante en évaluant la valeur R2 ajusté. Les valeurs R2 doivent être comprises entre 0 et 1 et elles représentent un pourcentage. Supposons que vous modélisiez des taux de criminalité et que vous trouviez un modèle qui réussisse tous les tests ci-dessus avec une valeur R2 ajustée de 0,65. Cette valeur indique que les variables explicatives de votre modèle expliquent 65 % de la variation de la variable dépendante du taux de criminalité). Les valeurs R2 ajusté doivent être jugées plutôt subjectivement. Dans certains domaines scientifiques, les intervenants seraient très satisfaits de pouvoir expliquer 23 pour cent d’un phénomène complexe. Dans d’autres domaines, la valeur R2 doit être plus proche de 80 ou 90 pour cent avant de susciter le moindre intérêt. Quoiqu’il en soit, la valeur R2 ajusté vous aidera à évaluer les performances de votre modèle.

Un autre diagnostic important vous permet d’évaluer les performances d’un modèle : il s’agit du critère d’information d’Akaike corrigé (AICc). La valeur AICc permet de comparer plusieurs modèles. Supposons, par exemple, que vous vouliez modéliser les résultats d’examens scolaires à l’aide de différents ensembles de variables explicatives. Dans un modèle, vous utiliseriez seulement des variables démographiques, alors que dans un autre, vous sélectionneriez des variables relatives à l’école et à la classe, telles que les dépenses par élève et les ratios enseignants-élèves. Tant que la variable dépendante pour tous les modèles comparés est la même (dans ce cas, les résultats d’examens), vous pouvez utiliser les valeurs AICc de chaque modèle pour déterminer celui qui fonctionne le mieux. Le modèle ayant la valeur AICc la plus faible est le mieux adapté aux données étudiées.

Et n’oubliez pas...

Lorsque vous effectuez toutes les opérations nécessaires pour créer un modèle de régression correctement spécifié, n’oubliez pas que l’objectif de votre analyse est de comprendre vos données et, ainsi, de pouvoir résoudre des problèmes et trouver des réponses à des questions. Pourtant, vous pouvez essayer plusieurs modèles (avec et sans variables transformées), explorer plusieurs petites zones d’études et analyser vos surfaces de coefficients, sans pour autant trouver un modèle de régression linéaire généralisée correctement spécifié. Mais, et cela est important, vous contribuerez malgré tout à l’ensemble de connaissances relatives au phénomène que vous modélisez. Le fait de découvrir que le modèle que vous pensiez être un prédicteur exact se révèle ne pas être significatif du tout constitue une information très utile. Vous comprendrez mieux un problème en découvrant qu’une des variables qui vous semblait déterminante a une relation positive dans certaines zones et une relation négative dans d’autres. C’est un travail précieux que vous effectuez en tentant de trouver un modèle correct à l’aide de la régression linéaire généralisée, puis en appliquant la régression pondérée géographiquement afin d’explorer les variations régionales entre les variables de votre modèle.

Pour plus d’informations sur l’analyse de régression et les didacticiels pratiques, rendez-vous sur https://www.esriurl.com/spatialstats.

Vous avez un commentaire à formuler concernant cette rubrique ?