Lorsque vous exécutez l’outil Régression exploratoire, la sortie principale est un rapport. Le rapport est écrit sous forme de messages au cours de l’exécution de l’outil et est également accessible à partir de l’historique de géotraitement.Une table permettant d’étudier en profondeur les modèles testés peut également être créée si vous le souhaitez. Un des objectifs du rapport est de vous aider à comprendre si les variables explicatives candidates que vous envisagez d’utiliser produisent des modèles des moindres carrés ordinaires correctement spécifiés. S’il n’existe aucun modèle concluant (si aucun d’eux ne répond à tous les critères que vous avez spécifiés quand vous avez lancé l’outil Régression exploratoire), la sortie indique également quelles variables sont des prédicteurs constants et vous aide à déterminer les diagnostics qui posent problème. Les stratégies de résolution des problèmes associés à chacun des diagnostics sont indiquées dans le document intitulé Principes de base de l’analyse de régression (reportez-vous à Problèmes de régression courants, conséquences et solutions) et dans la rubrique intitulée Ce que l’on ne vous dit pas sur l’analyse de régression. Pour plus d’informations sur la façon de déterminer si votre modèle des moindres carrés ordinaires est correctement spécifié, consultez les rubriques Principes de base de l’analyse de régression et Interprétation des résultats des moindres carrés ordinaires.

Le rapport

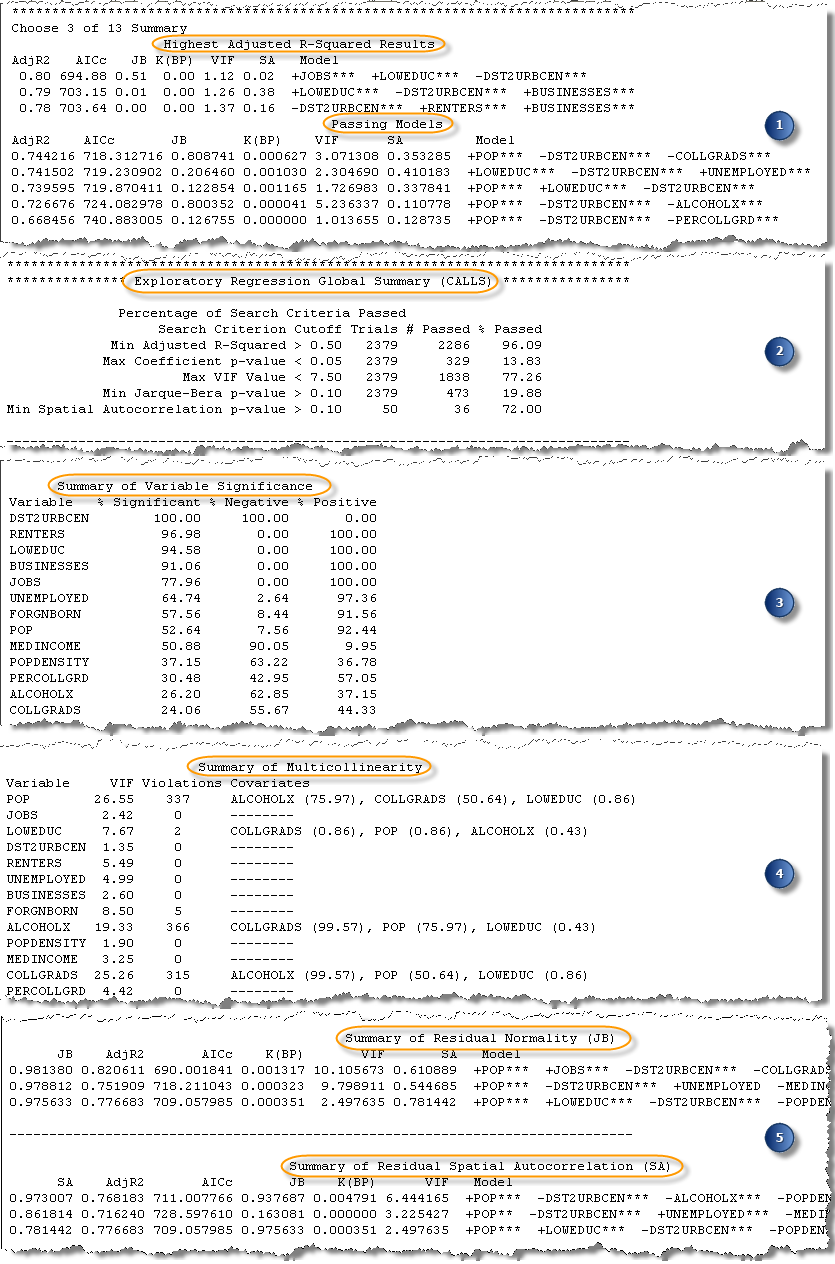

Le rapport produit par l’outil Régression exploratoire se divise en cinq sections. Chaque section est décrite ci-dessous.

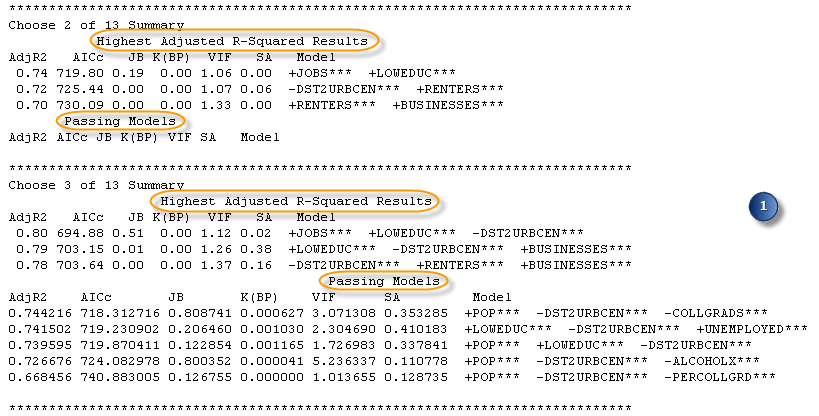

1. Meilleurs modèles classés par nombre de variables explicatives

Le premier ensemble de récapitulatifs dans le rapport en sortie est groupé en fonction du nombre de variables explicatives dans les modèles testés. Si vous spécifiez 1 comme valeur du paramètre Minimum Number of Explanatory Variables (Nombre minimal de variables explicatives) et 5 comme valeur du paramètre Maximum Number of Explanatory Variables (Nombre maximal de variables explicatives), le rapport comporte 5 sections récapitulatives. Chaque section répertorie les trois modèles avec les valeurs R2 ajusté les plus élevées, ainsi que tous les modèles concluants. Chaque section récapitulative inclut également les valeurs de diagnostic de chaque modèle répertorié : le critère d’information Akaike corrigé - AICc, la valeur p Jarque-Bera - JB, la valeur p Breusch-Pagan avec transformation de Student de Koenker - K(BP), le facteur d’inflation de la variance le plus élevé - VIF, et une mesure de l’autocorrélation spatiale des valeurs résiduelles (valeur p de l’indice de Moran global) - SA. Ces récapitulatifs indiquent la qualité des prévisions de vos modèles (R2 ajusté) et si des modèles satisfont à tous les critères de diagnostic que vous avez spécifiés. Si vous avez accepté tous les critères de recherche par défaut (les paramètres Minimum Acceptable Adj R Squared (Coefficient de détermination corrigé minimal acceptable), Maximum Coefficient p-value Cutoff (Limite des valeurs p des coefficients maximaux), Maximum VIF Value Cutoff (Limite des valeurs VIF maximales), Minimum Acceptable Jarque Bera p-value (Valeur p minimale acceptable du test Jarque Bera) et Minimum Acceptable Spatial Autocorrelation p-value (Valeur p minimale acceptable pour l’autocorrélation spatiale)), tous les modèles inclus dans la liste Passing Models (Modèles concluants) sont des modèles des moindres carrés ordinaires correctement spécifiés.

Même s'il n'existe pas de modèles concluants, le reste du rapport en sortie donne des informations importantes sur les relations entre les variables et peut vous aider à décider comment poursuivre votre travail.

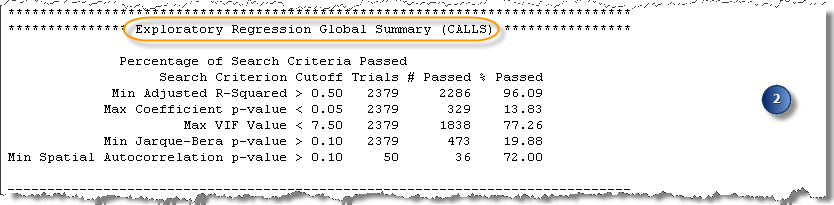

2. Récapitulatif global de la régression exploratoire

La section Exploratory Regression Global Summary (Récapitulatif global de la régression exploratoire) est importante, particulièrement si vous n’avez pas trouvé de modèles concluants, parce qu’elle indique pourquoi aucun des modèles n’est concluant. Cette section contient la liste des cinq tests de diagnostic et le pourcentage de modèles ayant réussi tous ces tests. Si aucun de vos modèles n'est concluant, ce récapitulatif vous permet de trouver le test de diagnostic qui pose problème.

Le diagnostic problématique est souvent le test d’indice de Moran global pour l’autocorrélation spatiale (SA). Si tous les modèles testés comportent des valeurs résiduelles de régression spatialement autocorrélées, il vous manque probablement des variables explicatives clés. Une des meilleures façons de rechercher des variables explicatives manquantes est d’examiner la carte des valeurs résiduelles résultant de l’exécution de l’outil de régression Moindres carrés ordinaires. Choisissez un des modèles de régression exploratoire qui fonctionnent bien pour tous les autres critères (utilisez les listes des valeurs R carré ajustées les plus élevées ou sélectionnez un modèle dans la table optionnelle en sortie) et exécutez l’outil Moindres carrés ordinaires en utilisant ce modèle. La sortie de l’outil de régression Moindres carrés ordinaires est une carte des valeurs résiduelles du modèle. Examinez les valeurs résiduelles pour trouver des indices sur ce qui pourrait manquer. Essayez de penser à autant de variables spatiales candidates que vous le pouvez (distance d’axes routiers majeurs, hôpitaux ou autres entités géographiques clés, par exemple). Envisagez d'essayer des variables de régime spatial : si toutes les sous-estimations se trouvent dans les zones rurales, par exemple, créez une variable fictive pour vérifier si elle améliore les résultats de la régression exploratoire.

L’autre diagnostic souvent problématique est le test de Jarque-Bera pour les valeurs résiduelles normalement distribuées. Si aucun de vos modèles ne réussit le test de Jarque-Bera (JB), votre modèle est biaisé. Les causes les plus courantes du biais d'un modèle incluent :

- Relations non linéaires

- Points aberrants de données

En visualisant une matrice de nuage de points des relations entre les variables explicatives candidates et votre variable dépendante, vous pourrez déterminer si vous avez un de ces problèmes. Des stratégies supplémentaires sont décrites dans la rubrique Principes de base de l’analyse de régression. Si vos modèles échouent aux tests d’autocorrélation spatiale (SA), résolvez ces problèmes d’abord. Il se peut que des variables explicatives clé manquantes soient à l'origine du biais du modèle.

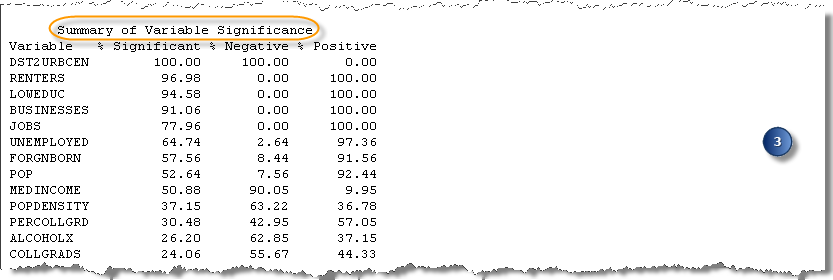

3. Récapitulatif de la signification des variables

La section Summary of Variable Significance (Récapitulatif de la signification des variables) fournit des informations sur les relations entre les variables et la cohérence de ces relations. Pour chaque variable explicative candidate apparaissant dans la liste, un pourcentage indique le niveau de significativité statistique de cette variable. Les premières variables de la liste ont les valeurs les plus élevées de la colonne % Significant (% d’importance). Vous pouvez également vérifier la stabilité des relations entre variables en étudiant les colonnes % Negative (% Négatif) et % Positive (% Positif). Les prédicteurs forts sont constamment significatifs (% Significant (% d’importance)) et la relation est stable (principalement négative ou principalement positive).

Cette partie du rapport vous permet aussi d’être plus efficace. Ceci est spécialement important si vous travaillez avec un grand nombre de variables explicatives candidates (plus de 50) et que vous voulez essayer des modèles avec au moins cinq prédicteurs. Si vous avez un grand nombre de variables explicatives et testez de nombreuses combinaisons, les calculs peuvent prendre beaucoup de temps. Dans certains cas, en fait, l’exécution de l’outil est interrompue par des erreurs de mémoire. Il est recommandé d’augmenter progressivement le nombre de modèles testés : commencez par définir une valeur de 2 puis de 3, de 4, etc. pour les paramètres Minimum Number of Explanatory Variables (Nombre minimal de variables explicatives) et Maximum Number of Explanatory Variables (Nombre maximal de variables explicatives). Après chaque exécution, supprimez les variables qui sont rarement statistiquement significatives dans les modèles testés. La section Summary of Variable Significance (Récapitulatif de la signification des variables) vous permet de trouver les variables qui sont constamment de forts prédicteurs. La suppression d’une variable explicative candidate de votre liste réduit considérablement la durée d’exécution de l’outil Régression exploratoire.

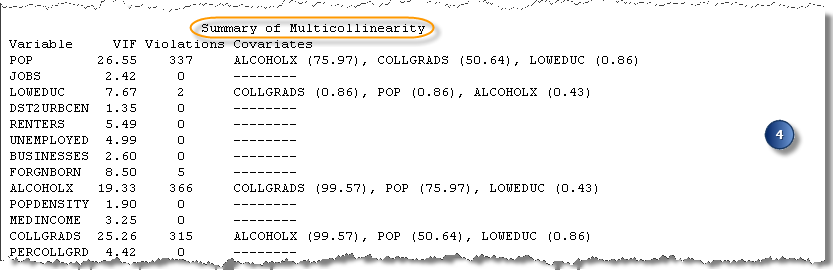

4. Récapitulatif de la colinéarité

La section Summary of Multicollinearity (Récapitulatif de la colinéarité) du rapport peut être utilisée conjointement avec la section Summary of Variable Significance (Récapitulatif de la signification des variables) pour comprendre quelles variables explicatives candidates peuvent être supprimées de votre analyse dans un souci d’amélioration des performances. La section Summary of Multicollinearity (Récapitulatif de la colinéarité) indique le nombre d’inclusions de chaque variable explicative à un modèle avec une multicolinéarité élevée, ainsi que les autres variables également incluses dans ces modèles. Si deux variables explicatives (ou plus) sont fréquemment trouvées ensemble dans des modèles avec une multicolinéarité élevée, il est probable que ces variables soient redondantes. Puisque vous voulez inclure seulement les variables qui expliquent un aspect unique de la variable dépendante, vous pouvez décider de n’inclure qu’une des variables redondantes dans la suite de l’analyse. Une approche possible consiste à utiliser la plus forte des variables redondantes en se basant sur la section Summary of Variable Significance (Récapitulatif de la signification des variables).

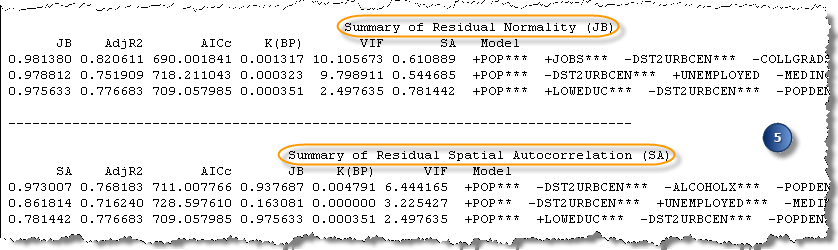

5. Récapitulatifs de diagnostic supplémentaires

Les derniers récapitulatifs de diagnostic indiquent les valeurs p Jarque-Bera les plus élevées (Summary of Residual Normality (Récapitulatif de la normalité des valeurs résiduelles)) et les valeurs p de l’indice de Moran global les plus élevées (Summary of Residual Autocorrelation (Récapitulatif de l’autocorrélation spatiale des valeurs résiduelles)). Pour réussir ces tests de diagnostic, vous devez obtenir des valeurs p élevées.

Ces récapitulatifs ne sont pas particulièrement utiles quand vos modèles réussissent les tests de Jarque-Bera et d’autocorrélation spatiale (indice de Moran global), car si votre critère de significativité statistique est 0,1, tous les modèles avec des valeurs supérieures à 0,1 sont également des modèles concluants. Ces récapitulatifs sont toutefois utiles lorsque vous n’avez pas de modèles concluants et que vous voulez connaître le pourcentage de valeur manquant pour obtenir des valeurs résiduelles normalement distribuées ou des valeurs résiduelles sans autocorrélation spatiale statistiquement significative. Par exemple, si toutes les valeurs p du récapitulatif Jarque-Bera sont égales à 0,000000, il est évident que vos variables résiduelles sont loin d’être normalement distribuées. Mais si les valeurs p sont égales à 0,092, les valeurs résiduelles sont presque normalement distribuées (en fait, selon le niveau de significativité choisi, une valeur p de 0,092 peut être concluante). Ces récapitulatifs démontrent à quel point un problème est grave et, si aucun modèle n'est concluant, ils permettent de déterminer quelles variables sont associées aux modèles qui sont presque concluants.

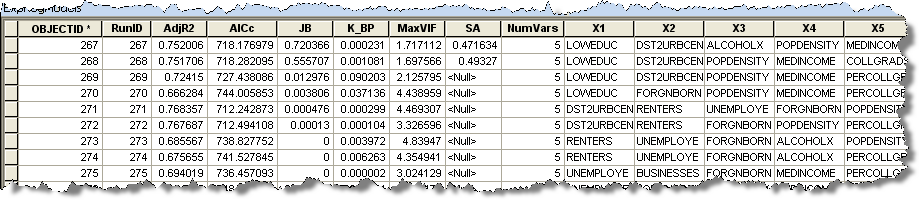

La table

Si vous avez spécifié une valeur pour Output Results Table (Table des résultats en sortie), une table contenant la liste de tous les modèles qui satisfont à vos critères Maximum Coefficient p-value Cutoff (Limite des valeurs p des coefficients maximaux) et Maximum VIF Value Cutoff (Limite des valeurs VIF maximales) est créée. Même si vous n’avez pas de modèles concluants, votre table en sortie contiendra probablement des modèles. Chaque ligne de la table représente un modèle correspondant à vos critères de valeurs de coefficients et de valeurs VIF. Les colonnes de la table répertorient les variables explicatives et les diagnostics du modèle. Les diagnostics répertoriés sont : R-carré ajusté (R2), les critères d’information Akaike corrigés (AICc), la valeur p Jarque-Bera (JB), la valeur p Breusch-Pagan avec transformation de Student de Koenker (BP), le facteur d’inflation de la variance (VIF) et la valeur p de l’indice de Moran global (SA). Il est possible de trier les modèles en fonction de leurs valeurs AICc. Plus la valeur AICc est faible, mieux le modèle a fonctionné. Vous pouvez trier les valeurs AICc dans ArcMap en cliquant deux fois dans la colonne AICc. Si vous sélectionnez un modèle pour effectuer l’analyse des moindres carrés ordinaires (afin d’examiner les valeurs résiduelles), n’oubliez pas de choisir un modèle avec une valeur AICc faible et des valeurs concluantes pour autant de diagnostics que possible. Par exemple, si vous avez consulté le rapport en sortie et savez que le diagnostic Jarque-Bera était problématique, recherchez le modèle avec la valeur AICc la plus faible ayant satisfait a tous les critères hormis Jarque-Bera.

Ressources supplémentaires

Si vous découvrez l’analyse de régression dans ArcGIS, nous vous recommandons de regarder la vidéo Free Esri Virtual Campus Training Seminar on Regression, puis d’exécuter le didacticiel Regression Analysis avant d’utiliser l’outil Régression exploratoire.

Vous pouvez également consulter :

- En savoir plus sur la régression exploratoire

- Ce que l’on ne vous dit pas sur l’analyse de régression

- Principes de base de l’analyse de régression

Burnham, K.P. et D.R. Anderson. 2002. Model Selection and Multimodel Inference: a practical information-theoretic approach, 2nd Edition. New York : Springer. Section 1.5

Vous avez un commentaire à formuler concernant cette rubrique ?