Un processus de Machine Learning standard commence par l’identification du problème métier et la formulation de la question ou de l’énoncé du problème. Vient ensuite une série d’étapes, dont les suivantes : préparation (ou prétraitement) des données, ingénierie des entités, sélection d’un algorithme et d’un entraînement de modèle appropriés, optimisation des hyperparamètres et évaluation du modèle. Il s’agit d’un processus itératif et le modèle optimal n’est souvent obtenu qu’après de multiples itérations et expérimentations.

Déterminer le modèle correspondant le mieux aux données nécessite du temps, des efforts et une expertise dans le processus de Machine Learning. L’outil Entraîner à l’aide d’AutoML automatise ce processus et identifie le meilleur algorithme avec le meilleur jeu d’hyperparamètres correspondant aux données. Cette mise en œuvre repose sur une mise en œuvre open source appelée mljar-supervised. Les sections ci-après décrivent chacune des étapes du processus de Machine Learning.

Processus de l’outil Entraîner à l’aide d’AutoML

L’outil Entraîner à l’aide du processus AutoML automatise les éléments suivants :

- Prétraitement des données - Les projets de Machine Learning réussis nécessitent de collecter des données en entrée de qualité permettant de résoudre un problème spécifique. Ces données peuvent provenir de sources de données distinctes, et il peut être nécessaire de les combiner. Une fois les données collectées et synthétisées, elles doivent être nettoyées et débarrassées du bruit afin de s’assurer que les algorithmes de Machine Learning puissent être efficacement entraînés sur ces données et apprendre. Cette étape est généralement longue et fastidieuse et peut nécessiter des connaissances et une expérience détaillées et spécialisées. Le nettoyage des données peut nécessiter d’identifier et de fournir les valeurs manquantes, de détecter les points aberrants, de corriger les données mal étiquetées, entre autres, toutes ces tâches pouvant demander un temps et des efforts considérables de la part du professionnel de Machine Learning. Les étapes de prétraitement sont les suivantes :

- Élimination des points aberrants : les points aberrants sont des points de données dissemblables par rapport au autres points de données. Ces points aberrants peuvent avoir pour cause des erreurs de saisie de données, des erreurs de mesure de données ou une dissemblance légitime, entre autres. Quelle qu’en soit la cause, il est important de supprimer les points aberrants des données, car ils ont tendance à perturber le modèle pendant la phase d’entraînement. Les méthodes courantes d’élimination des points aberrants corrigent les entrées ou les suppriment manuellement du jeu de données.

- Imputation des valeurs manquantes : des entrées peuvent être absentes de certaines colonnes du jeu de données. Les modèles d’entraînement machine ne peuvent pas être entraînés s’il manque des entrées dans les données d’entraînement. Pour être sûr qu’il ne manque aucune entrée dans le jeu de données, remplissez les entrées manquantes avec des données valides à l’aide de l’imputation de données. Les stratégies de remplissage de ces entrées manquantes comprennent l’ajout de l’occurrence la plus courante de la valeur ou l’ajout d’une nouvelle valeur pour mettre en évidence le fait que les données sont manquantes. Pour les données numériques, une stratégie consiste à utiliser la moyenne ou la médiane de toutes les entrées dans la colonne des données manquantes. Les stratégies peuvent actuellement être déterminées en exécutant l’outil Remplir les valeurs manquantes. L’outil Remplir les valeurs manquantes permet d’imputer des données non seulement à l’aide d’une statistique globale issue de la colonne, mais aussi en utilisant des stratégies spatiales telles que les voisins locaux et les voisins spatio-temporels ou des stratégies temporelles telles que des valeurs chronologiques.

- Mise à l’échelle et normalisation de données - L’une des hypothèses principales lors de l’entraînement d’un modèle de Machine Learning de modèle linéaire, tel que OLS (résidus), est que les données entraînées sont distribuées normalement, à savoir qu’elles suivent une courbe en forme de cloche.

Avant d’utiliser un modèle linéaire, assurez-vous que chaque colonne du jeu de données est distribuée normalement. Si des colonnes ne sont pas distribuées normalement, les transformations sont généralement appliquées aux données pour les convertir en une distribution normale.

Vérifiez que toutes les colonnes du jeu de données sont à la même échelle afin que le modèle n’accorde pas d’importance aux colonnes dont les valeurs se situent dans l’échelle plus grande. Cela s’effectue en appliquant des techniques de mise à l’échelle au jeu de données.

Bien que ce qui précède puisse se vérifier pour les modèles linéaires, les autres algorithmes tels que la régression logistique et les modèles basés sur un arbre (par exemple, DecisionTree, ExtraTree, RandomForest, XGBoost et LightGBM) ne supposent aucune normalité et sont plus résistants aux différences d’échelle, aux distributions corrigées, et ainsi de suite.

- Conversion de données catégoriques en données numériques : la plupart des modèles d’entraînement machine nécessitent que les données à utiliser pour l’entraînement soient sous la forme de nombres. Ils ne peuvent pas fonctionner avec d’autres types de données. Convertissez les colonnes non numériques (notamment State, Country, City ou Land cover category, Construction type, Dominant political party, etc.) en nombres. Les techniques utilisées pour convertir les données catégoriques en nombres comprennent le codage d’étiquette et le codage one-hot.

- AutoML permet également d’utiliser des données multimodales pour la modélisation et l’intégration d’images et de texte à des données tabulaires. La modélisation de données multimodales peut contribuer à l’extraction d’informations depuis diverses sources de données. Les modèles classiques reposent souvent sur un seul type de données, ce qui limite leur capacité à capturer toute la complexité des phénomènes réels. La nouvelle modélisation de données multimodales ou mixtes implémentée combine les forces des images, du texte et des données tabulaires afin de permettre une analyse approfondie et d’améliorer les performances de prévision. Tout d’abord, les entités sont extraites et traitées à partir de chaque modalité utilisant des intégrations de texte et d’image. Ensuite, elles sont concaténées avec les entités tabulaires pour former un vecteur d’entités unifiées pour chaque échantillon. En général, le vecteur d’entités concaténées est normalisé pour garantir que les entités provenant de différentes modalités présentent une échelle similaire. Le vecteur d’entités combinées contenant des intégrations de texte, des intégrations d’image et des entités tabulaires sert d’entrée dans le modèle multimodal. Des images peuvent être ajoutées à l’aide du paramètre Ajouter des images en pièces jointes dans l’outil Entraîner à l’aide d’AutoML.

- Ingénierie et sélection d’entités : on appelle entités les colonnes utilisées pendant le processus d’entraînement du modèle. L’utilité de ces entités pendant l’entraînement du modèle varie. Certaines d’entre elles ne sont pas nécessairement utiles, et dans ce cas, le modèle s’améliore lorsqu’elles sont supprimées du jeu de données.

Les approches telles que l’élimination d’entité récursive et les techniques d’entité aléatoire aident à déterminer l’utilité des entités d’un jeu de données, et les entités qui ne sont pas utiles sans ces approches sont généralement supprimées.

Dans certains cas, combiner plusieurs entités en une seule entité a pour effet d’améliorer le modèle. On appelle ce processus ingénierie d’entité.

À l’exception des nouvelles entités obtenues en combinant plusieurs entités à partir de l’entrée, l’outil crée également des entités spatiales portant des noms allant de zone3_id à zone7_id lorsque l’option Avancé est utilisée. Ces nouvelles entités sont générées en attribuant l’emplacement des entités d’entraînement en entrée à plusieurs (jusqu’à cinq) grilles spatiales de taille variable et en utilisant les ID de grille comme variables indépendantes nominales (catégorielles) dont les noms vont de zone3_id à zone7_id. Cela fournit des informations spatiales pertinentes aux modèles et leur permet d’apprendre davantage des données disponibles.

- Entraînement et sélection des modèles - À l’étape d’entraînement du modèle, le professionnel du Machine Learning choisit l’algorithme de Machine Learning approprié en fonction du problème et des caractéristiques des données. Il commence ensuite le processus itératif d’entraînement des modèles à adapter aux données, ce qui implique souvent de tester plusieurs algorithmes de Machine Learning. Chacun de ces algorithmes peut avoir différents hyperparamètres, qui sont des valeurs spécifiées manuellement par le professionnel du Machine Learning déterminant la manière dont le modèle apprend. Les hyperparamètres sont ensuite optimisés (ajustés) dans le but d’améliorer les performances de l’algorithme et d’obtenir de meilleurs résultats. Il s’agit d’un processus itératif nécessitant le temps et l’expertise d’un professionnel du Machine Learning. Les divers algorithmes ou les modèles statistiques incluent Régression linéaire et Régression logistique, d’autres modèles de Machine Learning tels que DecisionTree, RandomForest et les modèles d’optimisation plus récents tels que LightGBM et XGBoost. Bien que LightGBM et XGBoost soient plus performants que la plupart des autres modèles sur pratiquement tous les jeux de données, il est difficile de prévoir quels modèles seront efficaces avec un jeu de données spécifique. Vous devez donc essayer tous les modèles pour en comparer les performances avant de choisir le modèle qui convient le mieux aux données. Le modèle le plus adapté peut être identifié à partir de sa mesure. Différentes mesures sont renvoyées après l’entraînement des modèles de régression et de classification en exécutant l’outil Entraîner à l’aide d’AutoML. Pour certaines de ces mesures, une valeur élevée indique un modèle plus adapté tandis que pour d’autres, c’est une valeur faible qui désigne un modèle plus adapté. La table suivante récapitule ces comportements :

Modèle Valeur faible (modèle plus adapté) Valeur élevée (modèle plus adapté) Régression

MSE, EQM, MAE, MAPE

R2, Spearman, scores de Pearson

Classification

Logloss

AUC, F1

Dans la plupart des cas, le fait de combiner plusieurs modèles en un seul modèle et d’extraire la sortie de ce modèle combiné offre de meilleurs résultats qu’avec un seul modèle. On appelle ce processus assemblage de modèle.

- Optimisation des hyperparamètres : bien que la plupart des étapes précédentes soient des étapes itératives, l’étape qui est souvent la plus difficile dans l’entraînement de modèles de Machine Learning est celle de l’optimisation des hyperparamètres.

On peut considérer les hyperparamètres comme des leviers fournis avec chaque modèle. Les hyperparamètres utilisés pour entraîner un modèle RandomForest sont différents de ceux utilisés pour entraîner un modèle LightGBM. Découvrir ces hyperparamètres vous aidera à comprendre le modèle.

- Sélection du modèle : l’étape finale du processus d’entraînement machine réside dans l’évaluation du modèle, où vous vérifiez que l’algorithme d’entraînement machine entraîné et optimisé convient bien aux données en fonction desquelles il n’a pas été adapté. Ces données inédites sont souvent considérées comme un jeu de validation ou de test et sont conservées séparément du reste des données utilisées pour entraîner le modèle. L’objectif de cette étape finale est de s’assurer que l’algorithme d’entraînement machine apporte une exactitude prédictive acceptable au nouvelles données.

Dans le processus Machine Learning, il est clair qu’il existe à chaque étape des degrés variables de saisie humaine, de prise de décision et de choix.

- Les données appropriées ont-elles été collectées pour résoudre le problème, et en quantité suffisante ?

- Qu’est-ce qu’un point aberrant au regard de nos données ?

- Par quoi remplacer les éventuelles valeurs manquantes ?

- Quelles entités doivent être incluses dans le modèle de Machine Learning ?

- Quel algorithme de Machine Learning doit être utilisé ?

- Quel est le niveau de performance acceptable pour le modèle ?

- Quelle est la meilleure combinaison d’hyperparamètres pour un modèle ?

Cette dernière décision peut potentiellement impliquer des centaines, voire des milliers de combinaisons d'hyperparamètres pouvant être itérés. Il suffit d’ajouter quelques scénarios différents d’ingénierie d’entités, ainsi que l’entraînement et l’optimisation de plusieurs algorithmes de Machine Learning différents, pour que le processus devienne ingérable et improductif. En outre, plusieurs des étapes du processus d’entraînement machine nécessitent une compréhension technique experte des techniques de la science des données, des statistiques et des algorithmes d’entraînement machine. C’est pour cette raison que la conception et l’exécution des projets de Machine Learning peuvent se révéler longues, fastidieuses, coûteuses et souvent dépendantes de professionnels du Machine Learning et de scientifiques de données spécialisés.

La dernière décennie a vu l’essor rapide de la technologie de Machine Learning, qu’il s’agisse de ses applications diverses ou des nombreuses recherches qu’elle suscite. Certains des moteurs sous-jacents à cette croissance résident dans la maturité des algorithmes de Machine Learning et des méthodes, dans la génération et la prolifération de volumes de données à partir desquelles les algorithmes apprennent, dans les ressources informatiques abordables pour exécuter les algorithmes et dans la compréhension croissante des entreprises qui réalisent que les algorithmes de Machine Learning sont adaptés à des structures de données et problèmes complexes.

De nombreuses organisations souhaitent adopter la technologie de Machine Learning pour tirer parti de leurs données et en retirer des informations. Il existe pourtant un déséquilibre entre le nombre des applications potentielles de Machine Learning et le nombre des professionnels spécialisés et qualifiés dans ce domaine qui sont capables de les traiter. C’est pourquoi on assiste à une demande croissante de standardisation de la technologie de Machine Learning dans les organisations, en créant des outils qui la rendent largement accessible au sein d’une organisation et peuvent être utilisés clé en main par des non-experts et des spécialistes du domaine.

Récemment, le Machine Learning automatisé (AutoML) a émergé comme un moyen de satisfaire la demande de mise en place du Machine Learning à tous les niveaux d’expérience et de compétence des organisations. AutoML vise à créer un système unique pour automatiser (autrement dit, éliminer l’intervention humaine) au maximum le processus de Machine Learning, y compris la préparation des données, l’ingénierie des entités, la sélection des modèles, l’optimisation des hyperparamètres et l’évaluation des modèles. Cette approche peut bénéficier aux non-experts en abaissant le niveau d’accès au Machine Learning, mais aussi aux professionnels formés au Machine Learning en éliminant certaines des tâches les plus fastidieuses et longues du processus de Machine Learning.

AutoML pour les non-experts en Machine Learning (analystes du SIG/analystes en informatique de gestion ou analystes des données qui sont spécialisés dans un domaine). L’utilisation d’AutoML a pour principal avantage d’éliminer certaines des étapes du processus de Machine Learning qui demandent le plus d’expertise et de compréhension techniques. Les analystes spécialisés dans un domaine peuvent définir leur problème métier et collecter les données appropriées ; l’ordinateur se charge alors du reste. Ils n’ont pas besoin d’une compréhension détaillée des techniques de la science des données pour le nettoyage des données et l’ingénierie des entités, ni de savoir ce que font tous les algorithmes de Machine Learning, ni de consacrer du temps à explorer différents algorithmes et configurations d’hyperparamètres. Ces analystes peuvent en revanche exploiter leurs connaissances techniques dans le cadre d’un problème métier ou scénario précis. En outre, dans leur organisation, ils peuvent être moins dépendants des scientifiques des données et des ingénieurs en Machine Learning formés, car ils peuvent créer et utiliser des modèles avancés par eux-mêmes, souvent sans qu’aucune expérience dans le codage ne soit nécessaire.

AutoML pour les experts en Machine Learning (scientifiques des données ou ingénieurs en Machine Learning). AutoML peut également être utile aux experts en Machine Learning. Avec AutoML, les experts de Machine Learning n’ont pas besoin de consacrer autant de temps à assister les spécialistes dans leur organisation et peuvent se concentrer sur leur propre travail de Machine Learning avancé. AutoML peut également permettre d’économiser un temps considérable et de renforcer la productivité. Il est possible d’automatiser une grande partie des étapes chronophages du processus de Machine Learning (par exemple, le nettoyage des données, l’ingénierie des entités, la sélection des modèles et l’optimisation des hyperparamètres). Le temps gagné grâce à l’automatisation de ces étapes exploratrices répétitives peut être consacré à des tâches techniques plus avancées ou à des tâches nécessitant une plus grande implication de la part de l’être humain (par exemple, collaboration avec d’autres spécialistes, compréhension du problème métier ou interprétation des résultats du Machine Learning).

AutoML peut également renforcer la productivité des professionnels du Machine Learning, car il élimine certains des choix et des expériences subjectifs impliqués dans le processus de Machine Learning. Par exemple, un professionnel du Machine Learning approchant un nouveau projet peut disposer de la formation et de l’expertise qui l’aideront à choisir les nouvelles fonctionnalités à concevoir, et à déterminer le meilleur algorithme de Machine Learning pour un problème spécifique et les hyperparamètres les plus efficaces. Toutefois, il se peut qu’il néglige la conception de certaines nouvelles fonctionnalités ou qu’il ne teste pas toutes les combinaisons possibles d’hyperparamètres pendant qu’il exécute le processus de Machine Learning. De plus, le professionnel du Machine Learning peut influencer le processus de sélection d’entité ou le choix d’algorithme, car il préfèrera un algorithme de Machine Learning spécifique en fonction de son travail précédent ou de ses résultats dans d’autres scénarios de Machine Learning. En réalité, aucun algorithme de Machine Learning n’est optimal avec tous les jeux de données. Certains algorithmes de Machine Learning sont plus sensibles que d’autres à la sélection d’hyperparamètres, et de nombreux problèmes métier présentent des degrés variables de complexité et des besoins variables d’interprétabilité par les algorithmes de Machine Learning utilisés pour les résoudre. AutoML peut aider à réduire certaines de ces erreurs humaines en appliquant de nombreux algorithmes d’entraînement machine différents au même jeu de données puis en déterminant lequel est le plus efficace.

Un professionnel de l’entraînement machine peut également se servir d’AutoML comme référence ou point de départ initial dans un projet d’entraînement machine. Il peut l’utiliser afin de développer automatiquement un modèle de ligne de base pour un jeu de données, ce qui peut lui apporter des informations préliminaires sur un problème spécifique. Il peut décider d’ajouter ou de supprimer certaines entités dans un jeu de données en entrée ou de s’intéresser à un algorithme de Machine Learning particulier pour en optimiser les hyperparamètres. En ce sens, un professionnel du Machine Learning peut percevoir AutoML comme un moyen d’affiner ses choix initiaux afin de pouvoir se concentrer sur l’amélioration des performances du système de Machine Learning dans son ensemble. Il s’agit d’un processus courant, au cours duquel les experts en Machine Learning développent une référence orientée sur les données avec AutoML, puis exploitent cette référence en intégrant leur expertise pour affiner les résultats.

Standardiser le Machine Learning avec AutoML dans une organisation permet aux spécialistes de se concentrer sur le problème métier et d’obtenir des résultats exploitables, permet à davantage d’analystes de créer de meilleurs modèles et peut limiter le nombre d’experts en Machine Learning nécessaires à l’organisation. Cela peut également renforcer la productivité des professionnels du Machine Learning et des scientifiques des données formés, leur permettant de se concentrer sur la multitude des autres tâches qui en ont le plus besoin.

Identifier le modèle le plus adapté

Pour identifier le modèle le plus adapté à l’aide de l’outil Entraîner à l’aide d’AutoML, procédez comme suit :

- Exécutez des algorithmes simples, comme l’arbre décisionnel (un arbre simple présentant une profondeur maximale de 4) et les modèles linéaires.

Cela permet d’examiner rapidement les données et les résultats attendus.

- Entraînez les modèles sélectionnés à l’étape précédente avec les paramètres par défaut. Exécutez les données via un jeu d’algorithmes plus complexes en n’utilisant que les hyperparamètres par défaut.

Un ajustement de modèle est tenté pour chaque algorithme et pour tous les algorithmes disponibles. Les algorithmes disponibles sont Linear, RandomForest, XGBoost, LightGBM, DecisionTree et ExtraTree.

- Effectuez une recherche aléatoire sur l’espace d’hyperparamètre de chaque algorithme pour obtenir le jeu optimal d’hyperparamètres.

- Construction de nouvelles entités à l’aide d’entités finalisées. Déterminez lesquelles des nouvelles entités offrent la plus grande capacité de prévision et ajoutez-les au jeu de données initial.

Le meilleur jeu d’hyperparamètres identifié à l’étape précédente est utilisé à cette étape.

- Utilisez le jeu optimal d’hyperparamètres déterminé à l’étape 4 afin d’entraîner le modèle le plus efficace pour chaque algorithme, puis déterminez les entités les moins importantes et supprimez-les.

Les résultats issus des modèles les plus adaptés, entraînés à ce jour sont combinés. Les modèles sont ensuite empilés et les résultats des modèles les plus adaptés (y compris ceux empilés) sont combinés.

Créer un ensemble

Un ensemble est une collection de modèles dont les prévisions sont combinées par le calcul de la moyenne pondérée ou le vote.

Les stratégies les plus courantes pour créer un ensemble sont le « bagging » (RandomForest est un exemple classique de bagging) et l’optimisation (XGBoost est un exemple d’optimisation), qui combinent les sorties des modèles appartenant aux mêmes algorithmes. Les techniques récentes, telles que celles mentionnées dans Ensemble Selection from Libraries of Models (Caruana et. al 2004) combinent divers modèles.

Pour créer un ensemble, procédez comme suit :

Commencez par l’ensemble vide.

- Ajoutez le modèle dans la bibliothèque qui maximise les performances de l’ensemble à la mesure d’erreur sur un jeu de validation.

- Répétez l’étape précédente pour un nombre fixe d’itérations ou jusqu’à ce que tous les modèles aient été ajoutés.

- Renvoyez l’ensemble du jeu imbriqué d’ensembles qui offre les performances maximales sur le jeu de validation.

L’empilage de modèles implique également de combiner les résultats de plusieurs modèles et d’en retirer le meilleur résultat.

Alors que les approches orientées sur un ensemble combinent les résultats de divers modèles en appliquant différentes pondérations aux sorties, l’empilage utilise les sorties de chaque modèle de base en tant qu’entités et les ajoute à un modèle de niveau supérieur : un métamodèle. La sortie du métamodèle de niveau supérieur est utilisée comme sortie finale.

Pour améliorer les performances, vous pouvez créer des piles de modèles et combiner leurs sorties pour former une pile d’ensembles.

Interpréter les rapports en sortie

L’outil Entraîner à l’aide du processus AutoML peut générer un rapport HTML en sortie.

La page principale du rapport affiche le tableau de classement. Les mêmes informations sont également disponibles dans la fenêtre en sortie de l’outil.

Le tableau de classement affiche les modèles évalués et leur valeur de mesure. Pour le problème de régression, le modèle présentant le moins d’EQM est considéré comme le modèle le plus adapté (en l’occurrence, l’ensemble). Ce sera différent (par exemple, Logloss) pour les problèmes de classification.

La boîte à moustaches Performances d’AutoML ci-dessous compare la mesure d’évaluation de différents modèles avec une mesure d’évaluation (EQM) sur l’axe y et les modèles sur l’axe x, comme indiqué ci-dessous. La boîte à moustaches montre que le modèle le plus adapté est le modèle d’ensemble dont le nombre d’erreurs quadratiques moyennes (RMSE) est le plus faible.

Le diagramme des performances d’AutoML ci-dessous montre comment la mesure d’évaluation du modèle le plus performant, en l’occurrence le modèle d’ensemble, varie selon les différentes itérations. Le diagramme d’itération peut vous aider à comprendre la cohérence du modèle dans ses différentes exécutions.

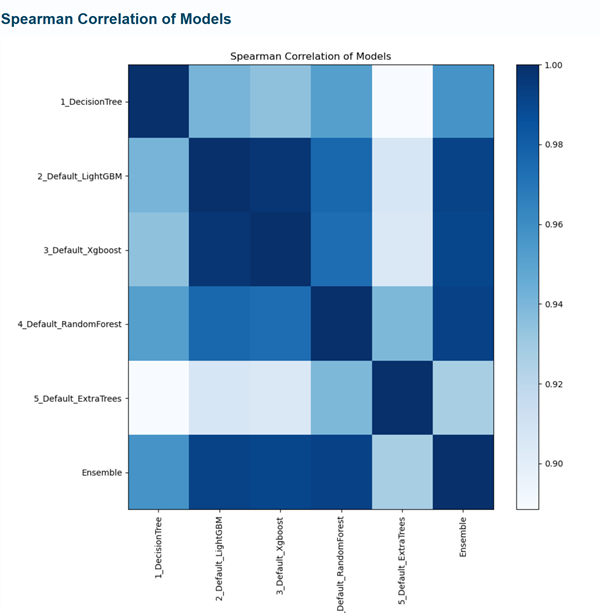

La corrélation de Spearman illustrée ci-dessous est générée pour tous les modèles ayant été évalués. Les modèles associés plus étroitement sont affichés dans des tons plus foncés de bleu. Par exemple, les sorties issues des modèles LightGBM et LightGBM sont les plus étroitement associées (cela étant normal puisque les deux sont des algorithmes d’optimisation). La sortie issue de LightGBM ressemble à celle issue de RandomForest par rapport à la sortie d’ExtraTrees.

Dans le tableau de classement, vous pouvez cliquer sur le lien de l’un des modèles dans la colonne Nom pour accéder à une page qui montre les hyperparamètres ayant été finalisés pour l’entraînement du modèle après leur optimisation. Dans cet exemple, l’arbre de décision a été entraîné avec la valeur max_depth égale à 3.

La même page affiche également d’autres mesures, outre celle ayant été utilisée pour l’évaluation. Dans l’exemple ci-dessous, qui consiste en une tâche de régression, les mesures MAE, MSE, EQM, R2 et MAPE ont été utilisées pour évaluer le modèle.

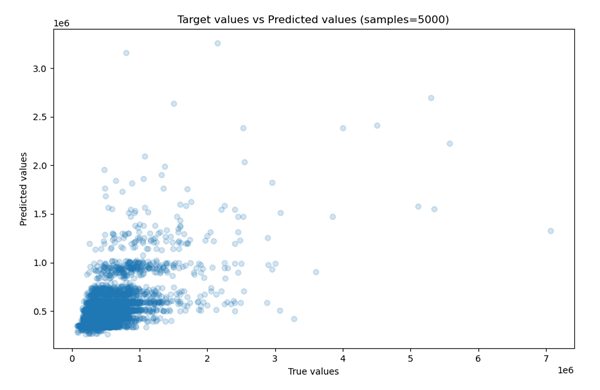

Le nuage de points des sorties réelles et prévues (pour un échantillon de 5 000 points de données) apparaît également.

Vous pouvez utiliser ce diagramme pour déterminer les performances du modèle. Les illustrations ci-dessus comparent les nuages de points de deux modèles obtenus à partir du rapport. Le second modèle est plus performant que le premier, dont les valeurs prédites et réelles divergent davantage.

Pour faciliter l’explication des modèles, l’importance de chaque variable dans le modèle final est également incluse dans le rapport (comparable à l’importance des entités dans sklearn). Contrairement à sklearn, ce diagramme peut être généré pour les modèles autres que des arbres de sklearn également. Cette capacité d’explication de modèles qui ne reposent pas sur des arbres est proposée par SHAP (SHapley Additive exPlanations).

SHAP est une approche basée sur la théorie des jeux qui permet d’expliquer la sortie d’un modèle de Machine Learning. Elle établit une relation entre l’allocation optimale de crédits et les explications locales, en utilisant les valeurs Shapley classiques selon la théorie des jeux et leur extensions associées. Vous trouverez d’autres informations sur SHAP et son implémentation dans le dossier GitHub SHAP. La sortie SHAP est disponible uniquement avec l’option Standard.

Dans le diagramme ci-dessous, vous pouvez voir l’impact global de chaque variable du jeu de données de logement sur le modèle entraîné. Cela montre que l’entité sqft_living influence le plus le modèle et qu’elle est l’entité la plus importante, suivie du nombre de salles de bain et de chambres dans la prévision des prix de logement.

Avec l’option Basic, vous avez la possibilité de consulter le rapport automatique d’analyse exploratoire des données (rapport EDA), qui produit des résumés statistiques pour la variable cible et les facteurs de prévision utilisés dans l’entraînement du modèle. Voici un exemple de rapport EDA pour une variable nommée altclip.tif :

Outil Prévoir à l’aide d’AutoML

L’outil Prévoir à l’aide d’AutoML prévoit des variables continues (régression) ou des variables catégorielles (classification) sur des jeux de données compatibles cachés à l’aide d’un modèle DLPK entraîné produit par l’outil Entraîner à l’aide d’AutoML.

L’entrée est un fichier de définition de modèle Esri (.emd) ou un fichier de paquetage de Deep Learning (.dlpk), qu’il est possible de créer à l’aide de l’outil Entraîner à l’aide d’AutoML.

Certaines des sorties facultatives qui sont générées par l’outil Prévoir à l’aide d’AutoML, outre la prévision, sont définies par les paramètres et le champ suivants :

Obtenir une explication pour chaque prévision : ce paramètre permet d’estimer l’importance des variables locales et est utile pour comprendre un modèle à une échelle locale. Lorsque le paramètre est sélectionné, l’importance des variables locales est générée pour toutes les variables explicatives, y compris les entités explicatives, les rasters explicatifs et les entités de distance explicatives. Un score de pourcentage est ajouté pour les variables explicatives représentant l’importance des variables locales pour les valeurs prévues à la localisation respective à la valeur du paramètre Entités de prévision en sortie. Par exemple, si des facteurs de prévision nommés var1, var2 et var3 sont utilisés pour entraîner le modèle (qui peut être une variable d’entité, un raster ou une variable de distance), les champs nommés var1_imp, var2_imp et var3_imp sont ajoutés pour chaque échantillon dans la valeur Entités de prévision en sortie :

L’importance des variables indique les différents degrés d’importance de chaque facteur de prévision par localisation, ce qui révèle également la force et la faiblesse de chaque facteur de prévision contribuant aux prévisions locales. Ce paramètre est actif lorsque le paramètre Type de prévision est défini sur Prévoir l’entité.var1_imp var2_imp var3_imp 0,26

0.34

0.40

0,75

0.15

0.10

- Score de confiance : ce score montre le niveau de confiance du modèle concernant la classe prévue renvoyée par le modèle. Il est disponible uniquement pour un problème de classification. Un champ prediction_confidence est ajouté à la table attributaire en sortie présentant les scores compris entre 0 et 1, qui représentent la probabilité faible à élevée de l’exactitude de la classe. Ce champ permet d’identifier les prévisions plus et moins fiables.

Bibliographie

Caruana, Rich, Alexandru Niculescu-Mizil, Geoff Crew et Alex Ksikes. 2004 « Ensemble Selection from Libraries of Models. » Proceedings of the 21st International Conference on Machine Learning. Banff, Canada. Ensemble Selection from Libraries of Models.

Vous avez un commentaire à formuler concernant cette rubrique ?