Image Analyst ライセンスで利用できます。

ArcGIS Image Analyst エクステンションの地理空間ビデオ機能では、モーション イメージとビデオを含めることができ、メタデータ準拠のビデオに対して再生機能と地理空間解析機能を提供します。 地理空間ビデオとは、ビデオ ストリームと、それに関連するメタデータを 1 つのビデオ ファイルで組み合わせることで、地理空間を意識したビデオにすることができます。 センサー システムは、カメラの方向、プラットフォームの位置および姿勢などのデータを収集し、ビデオ ストリームにエンコードすることで、各ビデオ フレームが地理的位置情報に関連付けられるようにします。

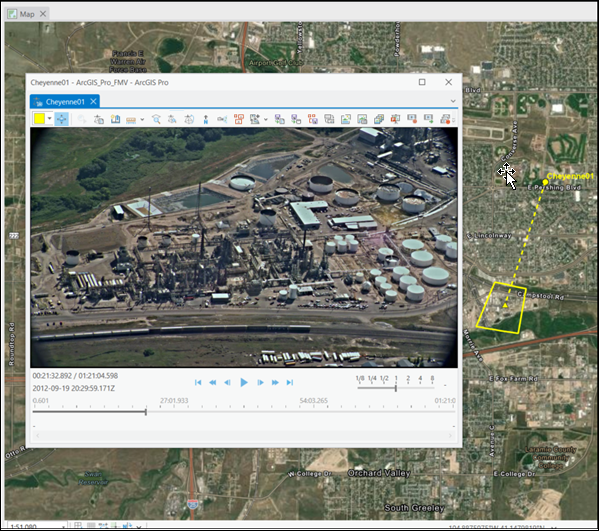

地理空間に対応した動画データと ArcGIS Pro の計算機能を併用することで、センサー動力学と視野 (FOV) を認識しながら動画を表示して操作し、この情報をマップ ビューに表示することができます。 また、ビデオ ビューまたはマップ ビューのいずれかでフィーチャ データを解析および編集し、テレストレーション機能を提供することもできます。

ArcGIS Pro のモーション イメージ ツールは、メタデータを使用して、画像空間解析の画像座標系が静止画を変換する方法と同様に、ビデオ画像空間とマップ空間の間で、座標をシームレスに変換します。 この変換は、GIS 内のその他すべての地理空間データおよび情報を十分に考慮した状態で、ビデオ データ解釈の基礎を提供します。 たとえば、動画を再生しながら、マップ ビュー上の動画フレームのフットプリント、フレーム中央、画像プラットフォームの位置に加え、建物とその ID などの GIS レイヤー、ジオフェンス、その他の関連情報を表示することができます。

ビデオ データは、収集された直後にリアルタイムまたはフォレンジック解析を行うことができます。 対象位置の最新画像であることが多いため、状況認識に適しています。 たとえば、自然災害後の損害評価を提供している場合、ビデオを使用してドローンから収集した最新のビデオ データを既存の GIS データ レイヤーとともに解析できます。 ビデオ フットプリントはマップ上に表示されるため、ビデオに表示される建物やインフラストラクチャーを正確に把握したり、その状態を評価したり、ビデオおよびマップ内の地表フィーチャをマークしたり、その位置をブックマークしたり、メモに記したりすることができます。 ビデオを使用することで、実用的な情報を迅速に評価、分析、出力でき、タイムリーな意思決定をサポートします。

ArcGIS Pro のビデオの詳細については、「よくあるご質問」をご参照ください。

地理空間ビデオの特長とメリット

ビデオは重要なメタデータを使用し、視覚的な解析処理ツールを提供するほか、プロジェクトおよびミッションクリティカルなワークフローをサポートする以下の ArcGIS Pro 機能も提供します。

- ビデオは ArcGIS Pro に完全に統合され、システム アーキテクチャー、データ モデル、ツールと機能、および ArcGIS 全体にわたる共有を使用することができます。

- ライブストリーム ビデオやアーカイブされたビデオを表示および解析します。

- ビデオ プレーヤーを、コンピューター ディスプレイの任意の場所に移動したり、サイズを変更したり、最小化したり、閉じたりできます。

- ビデオ プレーヤーはマップ表示にリンクされているため、以下を実行できます。

- マップへのビデオ フットプリント、センサー位置、および視野の表示。

- ビデオ プレーヤーで収集された情報を、既存の GIS データとともにマップ上に投影および表示できます。

- マップを更新してビデオ フレームを拡大し、ビデオに追従してマップ全体が表示できます。

- 複数のビデオを同時に開いて再生できます。 各ビデオおよび関連情報はマップに表示される際、一意の色で識別できます。

- 直感的な再生コントロール、画像およびビデオ クリップ キャプチャー、および解析ツールを使用できます。

- メタデータをリアルタイムで表示できます。

- ブックマークの作成および管理。

- 対象位置および現象のマーク。

- 表示を GPU で高速化できます。

- ビデオ メタデータの作成

これらの機能は、空間コンテキストをビデオ解析プロセスに統合するワークフローの基礎となります。

地理空間ビデオの用途

ビデオは主に運用環境の意思決定サポートに使用されます。 ビデオのユーザー、収集および利用方法を理解することで、ビデオの機能を評価するための重要なコンテキストを得ることができます。

地理空間ビデオを使用する業種

ビデオは、遠隔地、人が近づきにくい場所、危険な場所の監視に使用できます。 次のような組織がビデオを使用しています。

- 公共管理および危機管理

- ディフェンス

- 石油会社

- 地方政府および連邦政府

- 国境監視

- ユーティリティー

- 天然資源担当者

地理空間ビデオの用途の一部は、次のとおりです。

- 危機管理および公共管理

- 状況認識

- 損害評価

- 応答

- 減災

- セキュリティー監視

- 資産管理

- コリドーのマッピング、監視、および管理

- 電気、ガス、水道などのユーティリティー伝送およびその他の輸送

- 道路、橋、鉄道、高速道路、陸海空港などの交通

- 無線基地局やインフラストラクチャーなどの通信

- 自然インフラストラクチャーや人工インフラストラクチャーなどの水文解析

- リーチごとの河川バッファー、生息地、多様性マッピング、リンクなどの水辺

- ディフェンス

- インテリジェンス、監視、偵察

- ミッション サポート

- スパイ防止活動

- インフラストラクチャーの監視

- インベントリ

- 新規開発

- 計画に対する現況の確認

- コンプライアンスおよび安全管理

地理空間ビデオ データの収集

ArcGIS Pro のビデオ アプリケーションは、さまざまなリモート センシング プラットフォームから収集されたデータを使用します。 ビデオ データおよびメタデータは同時に収集され、メタデータはリアルタイムにセンサー プラットフォーム上でビデオ ファイルにエンコードされるか、後で多重化と呼ばれる処理手順でビデオ ファイルにエンコードされます。

ビデオ データは、以下などのさまざまなセンサー プラットフォームから収集されます。

- ドローン (UAV、UAS、および RPV)

- 固定翼およびヘリコプター航空機プラットフォーム

- 周回軌道宇宙センサー

- 車載カメラ

- ハンドヘルド モバイル デバイスおよびカメラ

- 永続的な監視のための固定デバイス

サポートされているビデオ形式 (高解像度の 4K 形式を含む) を次の表に示します。

| 説明 | 拡張子 |

|---|---|

AOMedia Video 1 ファイル | .av1 |

Audio Video Interleaved | .avi |

H264 ビデオ ファイル¹ | .h264 |

H265 ビデオ ファイル¹ | .h265 |

HLS (アダプティブ ビットレート (ABR)) | .m3u8 |

MOV ファイル | .mov |

MPEG-2 トランスポート ストリーム | .ts |

MPEG-2 プログラム ストリーム | .ps |

M2TS トランスポート ストリーム | .m2ts |

MPEG ファイル | .mpg |

MPEG-2 ファイル | .mpg2 |

MPEG-2 ファイル | .mp2 |

MPEG ファイル | .mpeg |

MPEG-4 ムービー | .mp4 |

MPEG-4 ファイル | .mpg4 |

MPEG-Dash | .mpd |

VLC (MPEG2) | .mpeg2 |

VLC メディア ファイル (MPEG4) | .mpeg4 |

VLC メディア ファイル (VOB) | .vob |

Windows Media Video ファイル | .wmv |

¹ 多重化が必要です。 |

ビデオのシステム要件

ArcGIS Pro でのモーション イメージの最小要件、推奨要件、および最適要件を以下に示します。 最小要件は、単一ビデオの再生をサポートします。 推奨要件は、単一ビデオの再生中に Full Motion Video ツールの使用をサポートします。 最適要件は、複数の単一ビデオの再生中にビデオ ツールの使用をサポートします。

| アイテム | サポートおよび推奨される要件 |

|---|---|

CPU | 最小 4 コア @ 2.6 GHz、同時マルチスレッディングが必要です。 CPU の同時マルチスレッディング、すなわちハイパースレッディングは標準でコア当たり 2 スレッドに対応しています。 マルチスレッディング搭載 2 コア CPU では 4 スレッドの並列処理が可能であり、マルチスレッディング搭載 6 コア CPU では 12 スレッドの並列処理が可能です。 6 コアを使用することを推奨します。 最適なパフォーマンスには、10 コアを使用します。 |

GPU | GPU タイプには、CUDA 計算機能 3.7 (最小) を搭載した NVIDIA の 6.1 以降をおすすめします。 GPU の計算機能を特定するには、CUDA 対応カードのリストをご参照ください。 GPU ドライバーには、より良いパフォーマンスを得られるよう、NVIDIA ドライバーのバージョン 531.61 以降をおすすめします。 専用のグラフィックス メモリーには、最小 4 GB が必要です。 同時にアクティブになるビデオの数によって、8 GB 以上を使用することをおすすめします。 |

地理空間ビデオ機能

ビデオは、ライブストリーミング ビデオを利用した緊急を要する状況認識および緊急時応急措置から、監視用の時間単位または日単位のアーカイブ ビデオの解析や、過去のアーカイブ データのフォレンジック分析まで、さまざまな運用環境をサポートしています。 それぞれの用途には、直感的な視覚化および解析ツールが必要です。これらのツールにより、対象のフィーチャや状況を迅速に識別および記録し、抽出された情報を意思決定者や関係者に提示します。 意思決定をサポートするビデオ機能は、以下で説明される必須機能に分類されます。

コンテキスト ビデオ タブ

ビデオをマップに読み込んで、[コンテンツ] ウィンドウでそのビデオを選択すると、[スタンドアロン ビデオ]、[プレーヤー]、[メタデータ]、[オブジェクト トラッキング] コンテキスト タブが表示されます。

スタンドアロン ビデオ タブ

ビデオがディスプレイに読み込まれると、ビデオ ファイルが [コンテンツ] ウィンドウに表示され、[スタンドアロン ビデオ] タブが有効になります。 [スタンドアロン ビデオ] タブのツールを使用すると、ビデオ データを管理できます。 このタブは、[開く]、[ブックマーク]、[保存]、[管理] のグループに分かれています。

[スタンドアロン ビデオ] タブに表示されるツールについては、「スタンドアロン ビデオ タブ」のトピックをご参照ください。

プレーヤー タブ

[プレーヤー] タブは、[コンテンツ] ウィンドウでビデオを選択すると有効になります。

[プレーヤー] タブには、ビデオの操作、グラフィックスの追加と管理、およびビデオ メタデータの表示を行うツールが含まれています。 これらのツールは、プレーヤーでも利用できます。

ツールの操作には、関連付けられたマップ ビューの拡大による地表でのフル ビデオ フレームの表示、地表でのセンサー地表トラックおよびビデオ フレームの視野の表示、マップの拡大および移動による地表でのビデオの追従などがあります。 これらのツールを使用すると、ビデオ データの操作時に地理的状況を把握できます。

メタデータ タブ

[メタデータ] タブには、地理空間ビデオ メタデータの操作を支援するためのツールが含まれており、静的センサー向けのメタデータを生成できます。今後のリリースでさらに拡大する予定です。

オブジェクト トラッキング タブ

[オブジェクト トラッキング] タブの詳細については、「モーション イメージのオブジェクト トラッキング」ドキュメントをご参照ください。

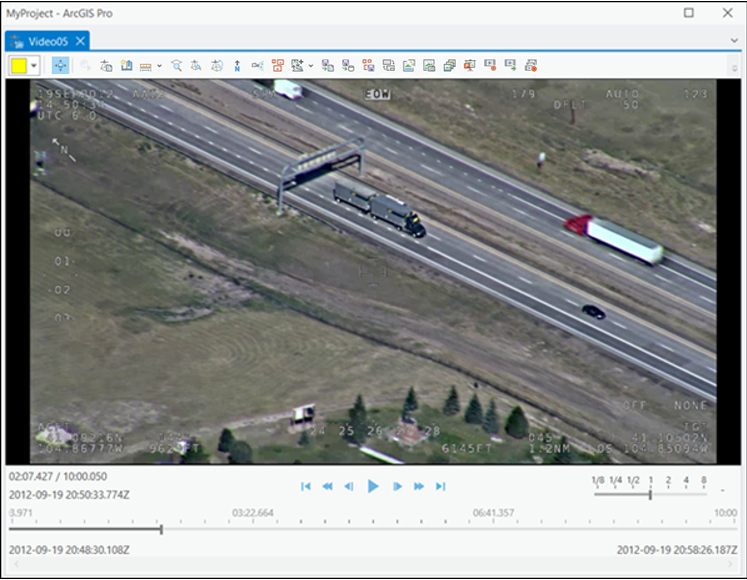

ビデオ プレーヤー

ビデオ プレーヤーには、再生、早送り、巻き戻し、早送り、次のステップへ進む、前のステップに戻る、先頭へのジャンプ、またはビデオの最後へのジャンプなど、標準的なビデオ コントロールが含まれています。 ビデオが再生モードまたは一時停止モードの間、ビデオの拡大およびローミングを行うことができます。 ビデオ プレーヤーは、マップ、グローバル シーン、ローカル シーンを操作します。 [シーン カメラの方向付け] 機能は、シーン ビュー カメラの向きをビデオ センサーの視点方向に設定します。これは、ローカル シーンとグローバル シーンでのみ有効になります。

その他のツールには、ビデオ ブックマークのキャプチャー、アノテーション、保存のほか、単一ビデオ フレームの画像としてのキャプチャー、ビデオ クリップのエクスポートなどがあります。

ブックマーク

ビデオ ブックマークの作成は、ビデオを解析する際に対象の現象やフィーチャを記録するための重要な機能です。 ビデオ ブックマークは、再生、一時停止、早送り、巻き戻しなど、ビデオ再生のさまざまなモードで収集できます。 ブックマークは、ビデオ ブックマークの収集時に開く [ブックマーク] ウィンドウに記述できます。 ブックマークは、ArcGIS Pro の [マップ] タブの [ナビゲーション] グループにある [ブックマーク] ウィンドウで収集および管理されます。

メタデータのビデオへの追加

必須のメタデータを含むビデオのみをモーション イメージで使用できます。 プロ仕様の空中ビデオ データ収集システムは、一般的に必要なメタデータを収集し、リアルタイムでビデオ ファイルにエンコードします。 このデータは、ライブストリーミング モードまたはアーカイブされたファイルから Full Motion Video アプリケーションに直接入力できます。

消費者向けのビデオ コレクション システムでは、1 つのメタデータ準拠ビデオ ファイルに結合する必要がある、個別のビデオ データとメタデータ ファイルが生成されることがよくあります。 この処理はソフトウェアで実行され、多重化と呼ばれます。 Full Motion Video は、適切なメタデータをビデオ ファイルの適切な位置にエンコードして、1 つのメタデータ準拠ビデオ ファイルを生成する [ビデオ マルチプレクサー (Video Multiplexer)] ツールを含んでいます。 各ビデオおよびメタデータ ファイルは、タイム スタンプを使用して、ビデオ ファイル内の適切な位置に適切なメタデータ エンコードを同期します。

メタデータは、X、Y、Z 位置を示す GPS、高度計、慣性測定ユニット (IMU)、カメラの方向を示す他のデータ ソースなどの適切なセンサーから生成されます。 メタデータ ファイルは、カンマ区切り値 (CSV) 形式である必要があります。

ビデオ メタデータを使用して、ビデオ センサーのフライト パス、ビデオ画像フレーム センター、およびビデオ画像フレームの地表のフットプリントが計算されます。 Full Motion Video は MISB (Motion Imagery Standards Board) メタデータ仕様にも対応しています。 指定したすべての MISB パラメーターが、最終的なメタデータ準拠ビデオにエンコードされます。

モーション イメージのパラメーター セットの中には、地表に投影されたビデオ画像フレームの四隅のマップ座標を含むものがあります。 四隅のマップ座標を指定した場合、この値が使用されます。 指定されていない場合、アプリケーションは必須パラメーターのサブセットからビデオ フットプリントを計算します。

ビデオ フレーム フットプリントの相対的なコーナー ポイントを計算して、マップ上にフレーム アウトラインとして表示するには、次に示す 12 個のメタデータ フィールドが必要です。

- 精度タイムスタンプ

- Sensor Latitude

- Sensor Longitude

- Sensor Ellipsoid Height、または Sensor True Altitude

- Platform Heading Angle

- Platform Pitch Angle

- Platform Roll Angle

- Sensor Relative Roll Angle

- Sensor Relative Elevation Angle

- Sensor Relative Azimuth Angle

- Sensor Horizontal Field of View

- Sensor Vertical Field of View

- 遠距離

メタデータの完全性と正確性が確保されている場合は、このアプリケーションでビデオ フレームのコーナーが算出され、マップ上に表示できるビデオ フレーム アウトラインのサイズ、形状、および位置が求められます。 これら 13 のフィールドは、ビデオとマップ間の変換の算出、マップ上でのビデオ フットプリントの表示、その他の機能 (ビデオとマップのデジタイズやマーキングなど) の有効化を実行するのに最低限必要なメタデータで構成されます。

Full Motion Video は、モーション イメージのオブジェクト トラッキング方法に基づいて VMTI (Video Moving Target Indicator) データをサポートしています。 VMTI データは、関連するビデオ ファイルとは別のファイルに記録されている場合、ビデオ マルチプレクサー ツールを使用してビデオ ファイルにエンコードできます。

生成される多重化ビデオ ファイルのパフォーマンスは、メタデータ ファイルに含まれるデータの種類と品質、およびビデオ データとメタデータ ファイルの同期の精度によって異なります。 メタデータが正確でないか異常値が含まれている場合、これらの差異はビデオにエンコードされ、ビデオが再生されるときにマップに表示されます。 metadata.csv ファイルに UNIX Time Stamp、Sensor Latitude、および Sensor Longitude フィールドのみが含まれている場合、センサーの位置がマップ上に表示されますが、ビデオ フレーム フットプリントは表示されません。また、ビデオ内のフィーチャのデジタイズや距離の測定などの機能もサポートされません。

メタデータは、C:\Program Files\ArcGIS\Pro\Resources\MotionImagery フォルダー内の Video_Multiplexer_Field_Mapping_Template.csv メタデータ テンプレートに入力できます。 このテンプレートには、ビデオ フレーム フットプリントの計算に必要な 12 個の必須メタデータ フィールドが含まれています。 メタデータ フィールド名がメタデータ テンプレートに必要なフィールドと一致しない場合は、Video_Multiplexer_Field_Mapping_Template.csv テンプレートのメタデータ テンプレート フィールド名と照合することができます。

ビデオ データとメタデータは時刻同期していることが理想です。 ビデオとメタデータをリンクするタイム スタンプが正確に同期されていない場合、マップ上のビデオ フットプリントとセンサーの位置は、ビデオ プレーヤーのビューからオフセットされます。 時間シフトが観測可能で一貫性がある場合、マルチプレクサーではメタデータのタイミングがビデオと合致するよう調整することができます。 時間シフトは、オプションの .csv ファイルを作成し、ビデオ内のオフセット位置と関連する時間の不一致を識別する [ビデオ マルチプレクサー (Video Multiplexer)] ツールに入力することで適用されます。 C:\Program Files\ArcGIS\Pro\Resources\MotionImagery フォルダー内の Video_Multiplexer_TimeShift_Template.csv テンプレートを使用してオフセットを調整します。 テンプレートには、時間シフトが発生するビデオ内の位置を示す elapsed time 列、および時間オフセット量を示す time shift 列が含まれています。 ビデオとメタデータの間の時間シフトに一貫性がない場合、ビデオ内の複数の位置を、テンプレート内の関連するタイムシフトとともに表示できます。 これにより、マルチプレクサーがビデオのタイミングに対して適切なメタデータを配置する位置を指示できます。

オブジェクト トラッキング

Full Motion Video は VMTI (Video Moving Target Indicator) とディープ ラーニング ベース トラッキングの 2 つのオブジェクト トラッキング方法をサポートしています。 VMTI 方法では、オブジェクトを手動または自動でトラッキングし、特定のビデオ フレーム内におけるオブジェクトの位置をエンコードします。 オブジェクトごとに識別子 (ID) と境界四角形が、アーカイブ ビデオで保存されるオブジェクトに関連付けられます。 ビデオが再生されると、VMTI オブジェクトに関連付けられた情報が表示されます。 Full Motion Video では、エンコードされたビデオ メタデータが「Motion Imagery Standards Board (MISB) Video Moving Target Indicator and Track Metadata」規格 (ST 0903) に準拠している必要があります。

ディープ ラーニング ベース オブジェクト トラッキング機能では、ビデオ画像内のオブジェクトを識別してトラッキングするときのさまざまな状況に対処できるように、自動化されたコンピューター支援ツールが提供されます。 この機能は、ディープ ラーニング テクノロジーを利用して、オブジェクトの検出、抽出、およびマッチングを支援します。 特定のオブジェクトおよびフィーチャのクラスを識別するディープ ラーニング モデルを構築し、一連のツールを使用して、それらの対象オブジェクトを識別、選択、トラッキングします。 オブジェクトの識別用四角形の重心をデジタイズして、プロジェクトのジオデータベースにポイント クラスとして保存できます。 その後、アーカイブ ビデオの再生時に、これらのオブジェクトを表示できます。

注意:

ディープ ラーニング ベースのオブジェクト トラッキングを実行するには、ディープ ラーニング フレームワーク パッケージをインストールする必要があります。 詳細については、システム要件をご参照ください。

サマリー

Full Motion Video の地理空間対応特性は、リアルタイムまたはフォレンジック分析および状況認識アプリケーションに最適です。 マップ上にビデオ フレーム フットプリントおよびフライト パスを投影および表示する機能により、ビデオに重要なコンテキストを与え、ビデオ プレーヤーとマップで双方向なフィーチャ コレクションを実現できます。

これらの機能とアノテーション付きのビデオ ブックマークを使用すると、アナリストは今後の分析に役立つビデオ フレームまたはセグメントを特定し、この情報を他の関係者と共有することができます。 FMV 準拠ビデオとフル GIS 機能を統合することにより、重要なコンテキスト情報を合成して、運用環境での情報に基づく意思決定をサポートすることができます。