获得 Image Analyst 许可后可用。

计算对象检测的精度工具通过对使用深度学习检测对象工具检测到的对象和地面参考数据进行比较来计算深度学习模型的精度。可使用四个准确率指标评估模型的准确率:平均精度 (AP)、F1 分数、COCO 平均精度均值 (mAP)以及精确率 x 召回率曲线。

解释模型结果

要了解计算对象检测的精度工具的输出,首先必须对检测模型的结果有一些了解。

在对象检测和分类中,可使用模型预测正类或反类,并且预测可以为正确或错误。例如,当检测影像中是否存在树木时,正类可以是“树木”,而反类可以是“无树木”。当预测正确时,意味着发生了正确预测;而当预测错误时,意味着发生了错误预测。

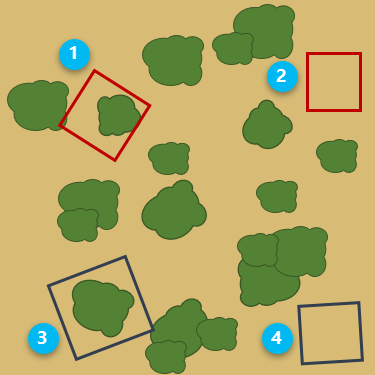

在下图中,红色边界框表示正确预测,模型预测到存在树木。深蓝色边界框表示错误预测,模型预测到不存在树木。

下表介绍了每个边界框的解释。

| 数值 | 说明 |

|---|---|

| 真正 - 模型预测到存在一棵树,实际上确实存在。 |

| 假正 - 模型预测到存在一棵树,实际上并不存在。 |

| 假负 - 模型预测到不存在树木,实际上存在。 |

| 真负 - 模型预测到不存在树木,实际上确实不存在。 |

准确率输出

对象检测模型的准确率取决于训练样本的质量和数量、输入影像、模型参数以及要求的准确率阈值。

交并比 (IoU) 用作确定预测结果为真正还是假正的阈值。 IoU 比率是预测对象周围的边界框与地面参考数据周围的边界框之间的重叠量。

| 预测边界框与地面参考边界框的相交区域 |

| 组合的预测边界框和地面参考边界框的总面积 |

计算对象检测的精度工具生成的输出准确率表和准确率报表都包含一套准确率指标,这些指标取决于 IoU 阈值和模型的性能。准确率指标描述如下:

- 精确率 - 精确率指真正数与阳性预测总数之比。例如,如果模型检测到 100 棵树,其中 90 棵是正确的,则精确率为 90%。

Precision = (True Positive)/(True Positive + False Positive) - 召回率 - 召回率指真正数与实际(相关)对象总数之比。例如,如果模型正确检测到影像中的 75 棵树,而实际上影像中存在 100 棵树,则召回率为 75%。

Recall = (True Positive)/(True Positive + False Negative) - F1 分数 - F1分数指精确率与召回率的加权平均值。值的范围从 0 到 1,1 表示最高精度。

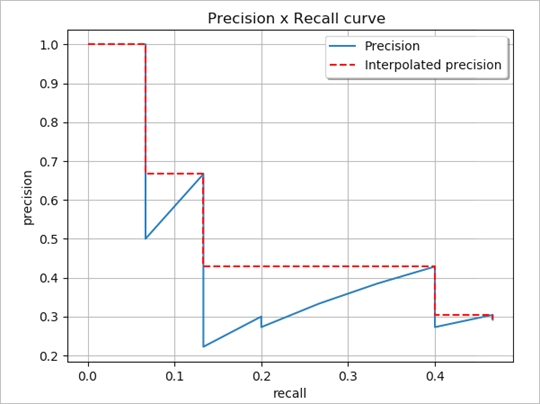

F1 score = (Precision × Recall)/[(Precision + Recall)/2] - 精确率-召回率曲线 - 这是精确率(y 轴)和召回率(x 轴)的绘图,用于评估对象检测模型的性能。如果精确率随着召回率的增加而不断增加,则该模型会被视为良好的预测模型。

显示了精确率-召回率曲线(Padilla 等人于 2020 年提出)。 - 平均精度 - 平均精度 (AP) 是在不同 IoU 阈值下,介于 0 和 1 之间的所有召回率值的精度平均值。通过在所有点上进行插值,AP 可以解释为精确率-召回率曲线的曲线下面积。

- 平均精度均值 - 平均精度均值 (mAP) 指多个 IoU 阈值上的 AP 平均值。例如,mAP@[0.5:0.05:0.95] 对应于范围介于 0.5 到 0.95、间隔为 0.05 并基于所有类平均的 IoU 比率值的 Ap。

参考文献

Hui, Jonathan. “mAP (mean Average Precision) for Object Detection." Posted March 6, 2018 on Medium. https://medium.com/@jonathan_hui/map-mean-average-precision-for-object-detection-45c121a31173.

Padilla, Rafael, Sergio L. Netto, and Eduardo A. B. da Silva. “A Survey on Performance Metrics for Object-Detection Algorithms." 2020 International Conference on Systems, Signals and Image Processing (IWSSIP), 237-242 (2000).

“Detection Evaluation." COCO Common Objects in Context, accessed October 15, 2020, https://cocodataset.org/#detection-eval.