GeoAI 工具箱中的“文本分析”工具使用最新开发的转换器架构来执行自然语言处理 (NLP) 任务。 此架构可以在需要更少的标注数据训练模型的同时,构建更准确且可并行化的工具。

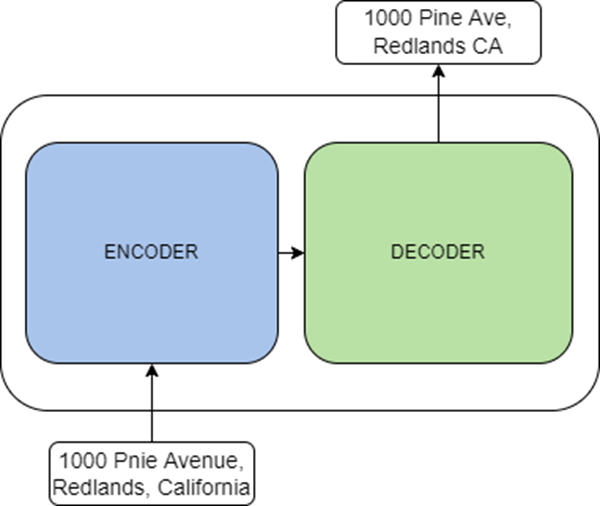

转换器是以自监督方式对大量原始文本形式的数据进行训练的语言模型。 您可以使用迁移学习针对其数据微调这些预训练模型。 这是是论文 Attention Is All You Need 中提出的新型架构,旨在解决文本分类、文本翻译、文本生成和实体识别等任务。 转换器由两个主要组件组成:编码组件和解码组件。 编码组件是编码器堆栈,它们接收输入并将其编码为要素形式的表示。 解码组件是解码器堆栈,它们使用来自编码组件的表示以及其他输入来生成目标序列形式的输出。

可以基于任务,通过以下方式使用编码器和解码器:

- 编码组件可用于文本分类和指定实体识别等任务。 熟知的编码模型包括 ALBERT、BERT 和 RoBERTa。

- 解码组件可用于文本生成等任务。 熟知的解码模型包括 CTRL 和 Transformer XL。

- 这些组件可以共同用于文本翻译和汇总等任务。 熟知的编码-解码模型包括 BART 和 T5。

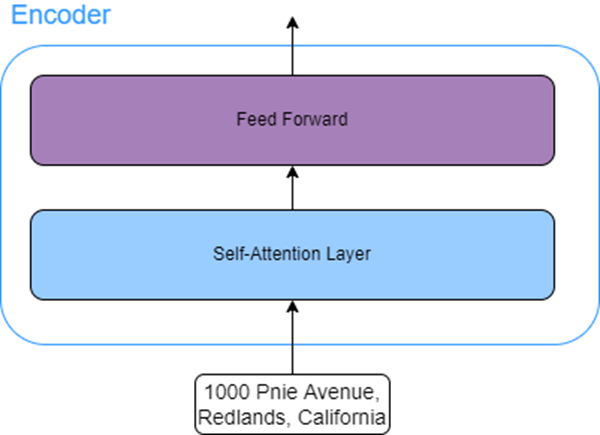

编码组件中的所有编码器具有相同的结构。 每个编码器包含两个子图层:

- 自注意力图层 - 该图层允许模型在输入序列中查找其他单词以增强当前单词的编码。

例如,可以考虑以下输入序列:The man couldn't cross the road as he was injure。 此处,he 指的是不能过马路的人。 在这种情况下,自注意力图层允许模型将单词 he 与单词 man 相关联。

- 前馈图层 - 该图层接受注意力图层的输出,并将其转换为下一个编码器可以接受的形式。

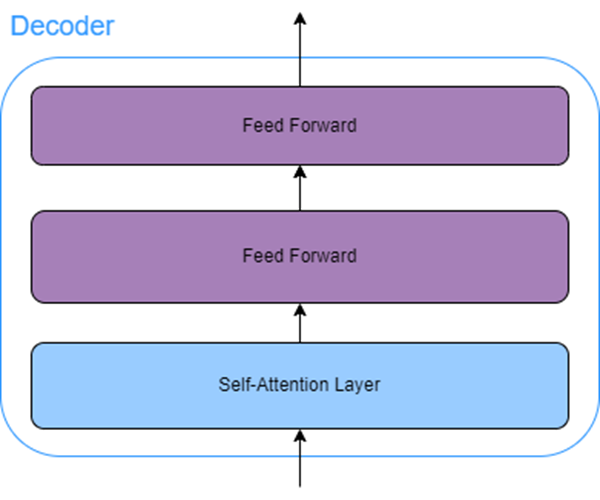

解码组件中的所有解码器除了自注意力和前馈图层外,还包含另一个注意力图层,也称为编码器-解码器注意力。 此编码器-解码器注意力图层允许解码器专注于输入序列中的某些部分。

资源

有关详细信息,请参阅以下资源: