Das Werkzeug Forest-basierte und geboostete Klassifizierung und Regression trainiert ein Modell auf der Grundlage bekannter Werte, die als Teil eines Trainings-Datasets bereitgestellt werden. Anhand des Modells können dann unbekannte Werte in einem Dataset, in dem die gleichen erklärenden Variablen vorliegen, vorhergesagt werden. Das Werkzeug erstellt Modelle und generiert Vorhersagen, wobei eine von zwei Methoden für überwachtes maschinelles Lernen zum Einsatz kommt: eine Adaption des "Random Forest"-Algorithmus, der von Leo Breiman und Adele Cutler entwickelt wurde, oder XGBoost, eine von Tianqi Chen und Carlos Guestrin entwickelte, häufig eingesetzte Boosting-Methode.

Das Forest-basierte Modell erstellt zahlreiche voneinander unabhängige Entscheidungsbäume, die gesammelt als Ensemble oder Wald bezeichnet werden. Jeder Entscheidungsbaum wird mithilfe einer zufälligen Teilmenge der Trainingsdaten und erklärenden Variablen erstellt. Jede Baumstruktur erstellt eine eigene Vorhersage und wird als Teil eines Aggregationsschemas zur Erstellung der endgültigen Vorhersagen verwendet. Die endgültigen Vorhersagen basieren nicht auf einer einzelnen Baumstruktur, sondern vielmehr auf dem gesamten Wald. Dadurch wird eine Überanpassung (Overfitting) des Modells an das Trainings-Dataset vermieden.

Das Gradient-Boosting-Modell erstellt eine Baumsequenz, d. h. eine Reihe von aufeinander aufbauenden Entscheidungsbäumen, durch die das Modell schrittweise geboostet wird. Jeder nachfolgende Entscheidungsbaum ist so konzipiert, dass er die Fehler (Verzerrung) des vorherigen Entscheidungsbaums korrigiert, wodurch das Gradient-Boosting-Modell mehrere schwache Learner zu einem starken Vorhersagemodell kombiniert. Das Gradient-Boosting-Modell umfasst die Normalisierung sowie Early Stopping, womit eine Überanpassung des Modells an das Trainings-Dataset verhindert wird.

Beide Modelltypen können zur Vorhersage einer kategorialen Variable (binäre Klassifizierung und Mehrklassen-Klassifizierung) oder einer kontinuierlichen Variable (Regression) verwendet werden. Wenn die vorherzusagende Variable eine kategoriale Variable ist, basiert das erstellte Modell auf Klassifizierungsbäumen. Bei einer kontinuierlichen Variable basiert das erstellte Modell auf Regressionsbäumen.

Potenzielle Anwendungsbereiche

Das Werkzeug hat folgende potenzielle Anwendungsbereiche:

- Liegen Daten über das Vorkommen von Seegras, verschiedene erklärende Umgebungsvariablen, die sowohl als Attribute als auch als Raster dargestellt sind, sowie Entfernungen zu flussaufwärts liegenden Fabriken und großen Häfen vor, können Vorhersagen, die auf Zukunftsprognosen für die vorliegenden erklärenden Umgebungsvariablen basieren, über das künftige Vorkommen von Seegras getroffen werden.

- Angenommen, Sie haben Daten zu Ernteerträgen in Hunderten von landwirtschaftlichen Betrieben im ganzen Land, Daten zu den Merkmalen dieser Betriebe (Anzahl der Mitarbeiter, Anbauflächen etc.) sowie verschiedene Rastern, die die Neigung, Höhe, den Niederschlag und die Temperatur für die einzelnen Betriebe darstellen. Anhand der einzelnen Daten können Sie ein Modell erstellen, mit dem der Ernteertrag vorhergesagt wird. Wenn Sie anschließend im Modell eine Reihe von Features mit den landwirtschaftlichen Betrieben sowie dieselben erklärenden Variablen angeben, können Sie eine Vorhersage zum Ernteertrag der einzelnen Betriebe treffen.

- Wohnwerte können anhand der Preise von Häusern, die im laufenden Jahr verkauft wurden, vorhergesagt werden. Der Verkaufspreis der verkauften Häuser kann zusammen mit Informationen über die Anzahl der Schlafzimmer, die Entfernung zu den Schulen, die Nähe zu den Hauptverkehrsstraßen, das Durchschnittseinkommen und die Kriminalitätsrate verwendet werden, um die Verkaufspreise ähnlicher Häuser vorherzusagen.

- Flächennutzungsarten können anhand von Trainingsdaten, einer Kombination aus Raster-Layern, darunter mehrere einzelne Bänder, und Produkten wie NDVI klassifiziert werden.

- Anhand von Informationen über die Bleiwerte im Blut von Kindern, der Steuerflurstücks-ID der jeweiligen Häuser, Attributen auf Flurstückebene wie das Alter des Hauses, offiziellen Bevölkerungsdaten wie Einkommens- und Bildungsniveau sowie nationalen Datasets, die die toxische Freisetzung von Blei und Bleiverbindungen darstellen, kann das Risiko einer Bleiexposition für Flurstücke ohne Daten zu Blutbleiwerten vorhergesagt werden. Diese Risikovorhersagen könnten für Maßnahmen und Aufklärungsprogramme in dem Gebiet genutzt werden.

Trainieren eines Modells

Der erste Schritt bei der Verwendung des Werkzeugs Forest-basierte und geboostete Klassifizierung und Regression besteht im Trainieren eines Modells für die Vorhersage. Durch das Training wird ein Wald oder eine Baumsequenz erstellt, worüber eine Beziehung zwischen den erklärenden Variablen und dem Parameter Vorherzusagende Variable hergestellt wird. Unabhängig davon, ob Sie sich für die Option Nur trainieren, Features vorhersagen oder Raster vorhersagen entscheiden, erstellt das Werkzeug zunächst ein Modell, das auf dem Parameter Vorherzusagende Variable und einer Kombination aus den Parametern Erklärende Trainingsvariablen, Erklärende Trainings-Entfernungs-Features und Erklärende Trainings-Raster (verfügbar mit einer Lizenz für die Spatial Analyst-Erweiterung) basiert.

Erklärende Trainingsvariablen

Als Quelle für die erklärenden Variablen, mit denen das Modell trainiert wird, dienen häufig die anderen Felder im Trainings-Dataset, das den Parameter Vorherzusagende Variable enthält. Unabhängig davon, ob Sie eine kontinuierliche Variable oder eine kategoriale Variable vorhersagen möchten, können die Felder in den Werten für Erklärende Trainingsvariablen kontinuierlich oder kategorial sein. Wenn das trainierte Modell auch zur Vorhersage verwendet wird, müssen alle bereitgestellten Werte unter Erklärende Trainingsvariablen für das Trainings-Dataset und das Vorhersage-Dataset verfügbar sein.

Erklärende Trainings-Entfernungs-Features

Auch wenn Forest-basierte und geboostete Klassifizierung und Regression kein Werkzeug für räumliches maschinelles Lernen darstellt, können Sie dessen räumliche Möglichkeiten mithilfe von Entfernungs-Features in Ihrer Analyse nutzen. Beispielsweise kann bei der Modellierung der Performance von Einzelhandelsgeschäften eine Variable, die die Entfernung zu Autobahnauffahrten oder zum nächsten Mitbewerber darstellt, für die Erstellung genauer Vorhersagen entscheidend sein. Ähnlich wäre bei der Modellierung der Luftqualität eine erklärende Variable zur Darstellung der Entfernung zu den größten Verschmutzungsquellen oder den Hauptverkehrsstraßen wichtig. Entfernungs-Features dienen zum automatischen Erstellen erklärender Variablen durch die Berechnung der Entfernung zwischen bereitgestellten Features und dem Wert für Eingabe-Trainings-Features. Entfernungen werden von jedem Feature unter Eingabe-Trainings-Features zu dem nächstgelegenen Feature aus den Eingabewerten unter Erklärende Trainings-Entfernungs-Features berechnet. Wenn der Eingabewert unter Erklärende Trainings-Entfernungs-Features Polygone oder Linien umfasst, werden die Entfernungsattribute als Entfernung zwischen den nächstgelegenen Segmenten des Feature-Paares berechnet. Allerdings werden Entfernungen bei Polygonen und Linien anders berechnet. Weitere Informationen hierzu finden Sie unter So wird die Entfernung mit Proximity-Werkzeugen berechnet.

Erklärende Trainings-Raster

Mit den Werten für Erklärende Trainings-Raster kann ebenfalls das Modell trainiert werden. Dadurch können Sie Fernerkundungsdaten, DEMs, Modelle zur Bevölkerungsdichte, Umweltmessungen und viele andere Datenquellen im Modell verwenden. Unabhängig davon, ob Sie eine kontinuierliche Variable oder eine kategoriale Variable vorhersagen möchten, können die einzelnen Werte für Erklärende Trainingsvariablen kontinuierlich oder kategorial sein. Der Parameter Erklärende Trainings-Raster ist nur mit einer Spatial Analyst-Lizenz verfügbar.

Wenn es sich bei den Features unter Eingabe-Trainings-Features um Punkte handelt und Sie einen Wert für Erklärende Trainings-Raster angegeben haben, führt das Werkzeug einen Drilldown durch, um erklärende Variablen an den einzelnen Punktpositionen zu extrahieren. Bei Multiband-Rastern wird nur das erste Band verwendet. Verwenden Sie für Mosaik-Datasets zunächst das Werkzeug Mosaik-Layer erstellen. Wenn der Wert unter Eingabe-Trainings-Features Polygone enthält, der Wert des Parameters Vorherzusagende Variable kategorial ist und Sie einen Wert für Erklärende Trainings-Raster angegeben haben, wird der Parameter Polygone für Training in Raster-Auflösung konvertieren aktiviert. Ist diese Option aktiviert, wird jedes Polygon am Schwerpunkt aller Raster-Zellen, deren Schwerpunkt innerhalb des Polygons liegt, in Punkte unterteilt und als Punkt-Dataset behandelt. Anschließend werden die Raster-Werte an den einzelnen Punktpositionen extrahiert und zum Trainieren des Modells verwendet. Das Modell wird nicht länger am Polygon trainiert, sondern an den für die einzelnen Zellenschwerpunkten extrahierten Raster-Werten. Für numerische Variablen wird eine bilineare Stichprobenmethode verwendet und für kategoriale Variablen die Nächster-Nachbar-Methode. Die Standard-Zellengröße der konvertierten Polygone entspricht der maximalen Zellengröße der Eingabe-Raster. Diese Größe können Sie über die Umgebungseinstellung Zellengröße ändern. Wird der Parameter Polygone für Training in Raster-Auflösung konvertieren nicht aktiviert, wird für jedes Polygon ein Raster-Wert im Modell verwendet. Jedem Polygon wird für kontinuierliche Raster der Durchschnittswert und für Kategorie-Raster die Mehrheit zugewiesen.

Vorhersagen mithilfe eines Modells

Es empfiehlt sich, mit der Option Nur trainieren zu beginnen, die Ergebnisse der Analyse zu evaluieren und die zu berücksichtigenden Variablen sowie die erweiterten Parameter nach Bedarf anzupassen. Sobald ein gutes Modell gefunden wurde, können Sie das Werkzeug erneut ausführen, um Features oder ein Raster vorherzusagen. Bei der Bestimmung des besten Modells können Sie sich vom Werkzeug unterstützen lassen. Aktivieren Sie das Kontrollkästchen des Parameters Optimieren, und wählen Sie eine Option für den Parameter Optimierungsmethode aus.

Weitere Informationen zur Parameteroptimierung

Beim Übergang zur Vorhersage empfiehlt es sich, den Parameter % der Trainingsdaten für die Validierung ausgeschlossen in 0 Prozent zu ändern, um alle verfügbaren Trainingsdaten in dem endgültigen für Vorhersagen verwendeten Modell zu berücksichtigen. Sie können Vorhersagen wie folgt treffen:

Vorhersagen im gleichen Untersuchungsgebiet

Bei der Vorhersage von Features im gleichen Untersuchungsgebiet muss jedes Vorhersage-Feature alle zugeordneten erklärenden Variablen (Felder) enthalten. Die Ausdehnung der Features muss sich mit der Ausdehnung der Werte für Erklärende Trainings-Entfernungs-Features und Erklärende Trainings-Raster überlappen.

Bei Vorhersagen für ein Raster im gleichen Untersuchungsgebiet anhand des bereitgestellten Wertes für Erklärende Trainings-Raster entspricht die Ausdehnung des Vorhersage-Rasters der überlappenden Ausdehnung aller erklärenden Raster.

Vorhersagen in einem anderen Untersuchungsgebiet

Bei der Vorhersage von Features in einem anderen Untersuchungsgebiet muss jedes Vorhersage-Feature alle zugeordneten erklärenden Variablen (Felder), erklärenden Entfernungs-Features und erklärenden Raster enthalten. Diese neuen Entfernungs-Features und Raster müssen für das neue Untersuchungsgebiet verfügbar sein und den Werten für Erklärende Trainings-Entfernungs-Features und Erklärende Trainings-Raster entsprechen.

Bei der Vorhersage für ein Raster in einem anderen Untersuchungsgebiet müssen neue erklärende Vorhersage-Raster bereitgestellt und mit dem entsprechenden Wert für Erklärende Trainings-Raster abgeglichen werden. Die Ausdehnung des resultierenden Wertes für Ausgabe-Vorhersage-Raster entspricht der überlappenden Ausdehnung aller bereitgestellten erklärenden Vorhersage-Raster.

Vorhersagen für einen anderen Zeitraum durch das Abgleichen der für das Training verwendeten erklärenden Variablen mit Variablen mit Zukunftsprognosen

Bei der Vorhersage für einen zukünftigen Zeitraum müssen alle projizierten erklärenden Vorhersage-Variablen (Felder, Entfernungs-Features und Raster) unabhängig davon, ob es sich um Vorhersagen für Features oder ein Raster handelt, mit den entsprechenden erklärenden Trainingsvariablen abgeglichen werden.

Beim Werkzeug Forest-basierte und geboostete Klassifizierung und Regression findet keine Extrapolation statt, weswegen die entsprechenden erklärenden Variablenfelder, Entfernungs-Features und erklärenden Raster im Wert Eingabe-Vorhersage-Features keine Wertebereiche oder Kategorien aufweisen dürfen, die sich erheblich von den für das Modelltraining verwendeten Wertebereichen oder Kategorien unterscheiden.

Features vorhersagen

Ein Modell, das mit einer beliebigen Kombination aus den Parameterwerten Erklärende Trainingsvariablen, Erklärende Trainings-Entfernungs-Features und Erklärende Trainings-Raster erstellt wurde, kann für Vorhersagen von Punkten oder Polygonen im gleichen oder auch in einem anderen Untersuchungsgebiet verwendet werden. Bei der Vorhersage für Features müssen für jedes Feature, für das eine Vorhersage getroffen wird, Werte für alle Felder, Entfernungs-Features und Raster, mit denen das Modell trainiert wird, bereitgestellt werden.

Stimmen die Feldnamen der Werte unter Eingabe-Trainings-Features und Eingabe-Vorhersage-Features nicht überein, wird der Parameter Erklärende Variablen abgleichen aktiviert. Beim Abgleich von erklärenden Variablen müssen die Felder, die in den Parametern Vorhersage und Training angegeben werden, denselben Typ aufweisen. Beispiel: Ein Double-Feld unter Eingabe-Trainings-Features muss mit einem Double-Feld unter Eingabe-Vorhersage-Features abgeglichen werden. Bei Vorhersagen für ein anderes Untersuchungsgebiet oder einen anderen Zeitraum können Sie die Entfernungs-Features oder Raster verwenden, die nicht für das Modelltraining genutzt wurden. Die Parameter Entfernungs-Features abgleichen und Erklärende Raster abgleichen werden aktiviert.

Vorhersagen für Raster

Bei Verwenden eines Modells, das nur mit Erklärende Trainings-Raster trainiert wurde, können Sie ein Raster im gleichen oder in einem anderen Untersuchungsgebiet vorhersagen. Bei Vorhersagen für ein anderes Untersuchungsgebiet oder einen anderen Zeitraum können Sie die Vorhersage-Raster verwenden, die nicht für das Modelltraining genutzt wurden. Der Parameter Erklärende Raster abgleichen wird aktiviert. Bei Vorhandensein einer Spatial Analyst-Lizenz können Sie ein Ausgabe-Vorhersage-Raster erstellen, indem Sie die Option Raster vorhersagen als Wert für den Parameter Vorhersagetyp auswählen.

Bewerten eines Modells

Nachdem von diesem Werkzeug ein Modell erstellt wurde, können Sie es bewerten. Die von diesem Werkzeug erstellten Meldungen und Diagramme helfen Ihnen, die Eigenschaften des Modells besser zu verstehen und seine Performance zu bewerten.

Geoverarbeitungsmeldungen

Sie können auf diese Meldungen zugreifen, indem Sie mit der Maus auf die Fortschrittsleiste zeigen, auf die Pop-out-Schaltfläche klicken oder den Abschnitt "Meldungen" im Bereich Geoverarbeitung erweitern. Sie haben im Geoverarbeitungsverlauf auch Zugriff auf die Meldungen für eine vorherige Ausführung dieses Werkzeugs. Die Meldungen enthalten Informationen zu den Modelleigenschaften, Out-of-Bag-Fehlern (OOB), der Variablenbedeutung, Trainings- und Validierungsdiagnosen sowie Diagnosen zum Bereich der erklärenden Variablen.

Tabelle der Modelleigenschaften

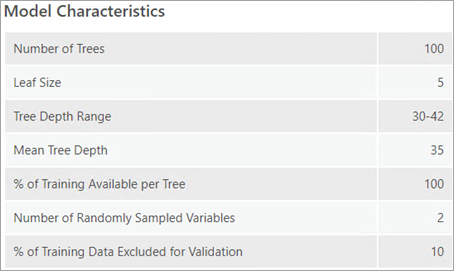

Die Tabelle Modelleigenschaften enthält Informationen zu verschiedenen wichtigen Aspekten Ihres Forest- bzw. geboosteten Modells, von denen einige über Parameter im Dropdown-Menü Erweiterte Modelloptionen ausgewählt werden, während andere datengesteuert sind. Ein Verständnis der datengesteuerten Modelleigenschaften ist beim Optimieren der Modell-Performance wichtig. Unter Bereich für Baumstrukturtiefe ist die minimale und die maximale Baumstrukturtiefe des Waldes bzw. der Baumsequenz aufgeführt. Die maximale Tiefe wird über den Parameter Maximale Baumstrukturtiefe festgelegt, jedoch sind alle Tiefenwerte, die unter dem Maximalwert liegen, möglich. Unter Durchschnittliche Baumstrukturtiefe ist die durchschnittliche Tiefe der Bäume im Wald bzw. in der Baumsequenz aufgeführt. Wenn der Parameter Maximale Baumstrukturtiefe auf 100 festgelegt wurde, jedoch für Bereich für Baumstrukturtiefe und Durchschnittliche Baumstrukturtiefe kleinere Werte festgestellt werden, kann durch die Angabe einer kleineren maximalen Baumstrukturtiefe möglicherweise die Modell-Performance verbessert werden. Grund hierfür ist, dass das Risiko einer Überanpassung des Modells an die Trainingsdaten gesenkt wird. Unter Anzahl der nach dem Zufallsprinzip erfassten Variablen findet sich die Anzahl der nach dem Zufallsprinzip ausgewählten Variablen, die für jede Baumstruktur im Modell verwendet werden. Jede Baumstruktur weist eine andere Kombination aus Variablen auf, jedoch dieselbe Variablenanzahl. Die Anzahl basiert standardmäßig auf einer Kombination aus der Feature-Anzahl und der Anzahl verfügbarer Variablen. Für die Regression ist dies ein Drittel der Gesamtzahl der erklärenden Variablen (einschließlich Features, Raster und Entfernungs-Features). Für die Klassifizierung ist dies die Quadratwurzel aus der Gesamtzahl an Variablen. Wenn für den Parameter Modelltyp die Option Forest-basiert angegeben ist, enthält die Tabelle Modelleigenschaften Werte für Anzahl der Baumstrukturen, Blattgröße, Bereich für Baumstrukturtiefe, Durchschnittliche Baumstrukturtiefe, % des Trainings verfügbar pro Baumstruktur, Anzahl der nach dem Zufallsprinzip erfassten Variablen und % der Trainingsdaten für die Validierung ausgeschlossen. Wenn für den Parameter Modelltyp die Option Gradient Boosting angegeben ist, enthält die Tabelle vier weitere Werte: L2-Normalisierung (Lambda), Minimale Verlustreduzierung für Verzweigungen (Gamma), Lernrate (Eta) und Maximale Anzahl von Abschnitten zum Suchen von Splits.

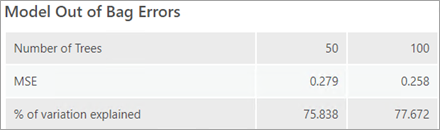

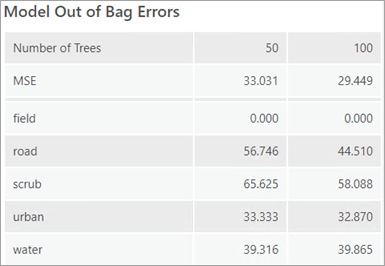

Tabelle der Out-of-Bag-Fehler des Modells

Ist für den Parameter Modelltyp die Option Forest-basiert angegeben, ist in den Geoverarbeitungsmeldungen eine Tabelle mit den Out-of-Bag-Fehlern des Modells enthalten. Anhand von OOB-Fehlern können Sie die Genauigkeit (Accuracy) des Modells bewerten. Die Werte MSE (Mean Squared Error, mittlere quadratische Abweichung) und % der erklärten Variation basieren auf der Fähigkeit des Modells, genaue Vorhersagen für den Wert Vorherzusagende Variable auf Grundlage der beobachteten Werte im Trainings-Dataset zu treffen. OOB ist ein Vorhersagefehler, der anhand der Daten berechnet wird, die zu dem Trainings-Dataset gehören, das von einer Teilmenge der Bäume im Wald nicht gesehen wird. Wenn Sie ein Modell anhand von 100 Prozent Ihrer Daten trainieren möchten, sind Sie bei der Bewertung der Genauigkeit (Accuracy) Ihres Modells auf OOB angewiesen. Diese Fehler werden für die Hälfte der Anzahl an Bäumen und die Gesamtzahl der Bäume gemeldet und sollen die Entscheidung vereinfachen, ob eine Erhöhung der Anzahl an Bäumen die Performance des Modells verbessern würde. Wenn die Fehler und der Prozentsatz der erklärten Variation für beide Baumanzahlen ähnliche Werte haben, ist dies ein Hinweis darauf, dass die Verwendung einer kleineren Anzahl an Baumstrukturen minimale Auswirkungen auf die Performance des Modells hat. Es empfiehlt sich jedoch, so viele Bäume zu verwenden, wie Ihr Computer zulässt. Eine größere Anzahl an Bäumen im Wald führt zu stabileren Ergebnissen und einem Modell, das weniger anfällig für Rauschen in den Daten und im Referenzpunktschema ist.

Wenn die vorherzusagende Variable kategorial ist (zu erkennen am Parameterwert Variable als kategorial behandeln), erfolgt die Berechnung der OOB-Fehler basierend auf dem Prozentsatz der falschen Klassifizierungen für jede Kategorie bei den Bäumen, von denen eine Teilmenge der Bäume im Wald nicht gesehen wurde. Der Prozentsatz der falschen OOB-Klassifizierungen für jede Kategorie wird in den Geoverarbeitungsmeldungen ausgegeben. Der MSE der Klassifizierungen wird ebenfalls ausgegeben und kann als Gesamtanteil der falschen OOB-Klassifizierungen bei allen Kategorien interpretiert werden. Bei einem kleinen Wert für Anzahl der Baumstrukturen kann es vorkommen, dass eine oder mehrere Kategorien nicht zum Trainieren der Daten verwendet werden. In diesem Fall ist der OOB-Fehler 100 %.

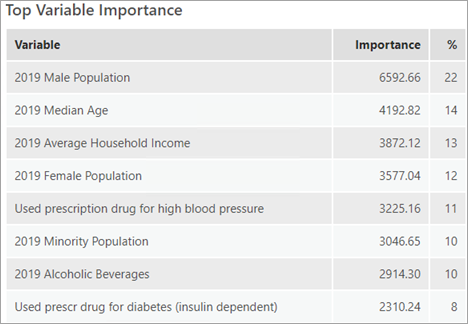

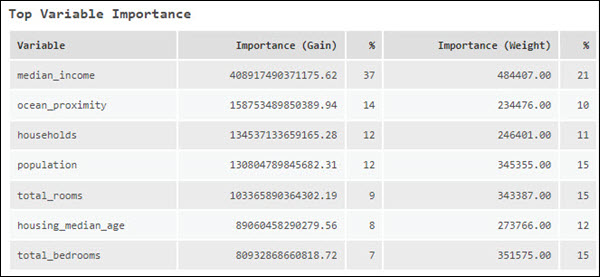

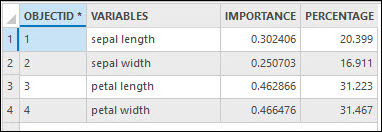

Tabelle der höchsten Variablenbedeutung

Ein weiterer Faktor für die Performance des Modells sind die verwendeten erklärenden Variablen. Die Tabelle Höchste Variablenbedeutung enthält eine Liste der erklärenden Variablen mit den 20 höchsten Werte für die Variablenbedeutung. Die Variablenbedeutung bietet eine Diagnosemöglichkeit, mit der Sie herausfinden können, welche Variablen die Modellergebnisse beeinflussen. Es empfiehlt sich, zunächst alle Daten für das Training zu verwenden und die Bedeutung der einzelnen erklärenden Variablen zu untersuchen. Anschließend können Sie anhand der Variablenbedeutung ein einfacheres (ökonomischeres) Modell erstellen, das nur die als bedeutsam erkannten erklärenden Variablen enthält.

Wenn für den Parameter Modelltyp der Wert Forest-basiert festgelegt ist, wird die Bedeutung anhand der Gini-Koeffizienten berechnet. Diese Koeffizienten können Sie sich als die Häufigkeit vorstellen, mit der eine Variable für eine Verzweigung und die Folge dieser Verzweigung verantwortlich ist, geteilt durch die Anzahl der Bäume. Jede Verzweigung ist eine einzelne Entscheidung in einem Entscheidungsbaum.

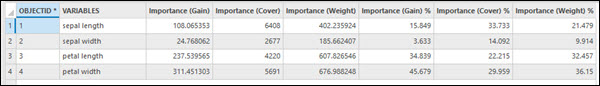

Wenn für den Parameter Modelltyp der Wert Gradient Boosting festgelegt wurde, wird die Variablenbedeutung durch drei Kennwerte gemessen: "Bedeutung (Gain)", "Bedeutung (Gewichtung)" und "Bedeutung (Abdeckung)". "Bedeutung (Gain)" gibt den relativen Beitrag einer erklärenden Variablen zum Modell an. "Bedeutung (Gain)" berechnet sich aus der Summe des Gain aller Verzweigungen, bei denen eine erklärende Variable zum Einsatz kommt. "Bedeutung (Gewichtung)" gibt an, wie oft eine erklärende Variable in allen Verzweigungen zum Einsatz kommt. "Bedeutung (Abdeckung)" entspricht der Anzahl an Beobachtungen in allen Bäumen, die von der erklärenden Variablen definiert sind. "Bedeutung (Abdeckung)" wird nicht in den Geoverarbeitungsmeldungen aufgeführt. Wenn jedoch der Parameter Ausgabetabelle zur Variablenbedeutung angegeben wird, ist "Bedeutung (Abdeckung)" ein Feld in der Tabelle und kann im Diagramm Zusammenfassung der Variablenbedeutung angezeigt werden. Diese beiden Ausgaben können über den Bereich Inhalt aufgerufen werden. Ist der Wert für Anzahl der ausgeführten Validierungen größer als 1, berechnet das Werkzeug den Variablenbedeutungssatz für jede Iteration. In den Geoverarbeitungsmeldungen wird für die Iteration der Variablenbedeutungssatz mit dem R-Squared- oder Accuracy-Wert aufgeführt, der dem R-Squared- oder Accuracy-Medianwert am nächsten liegt. Geben Sie einen Wert im Parameter Ausgabetabelle zur Variablenbedeutung an, um alle Variablenbedeutungssätze zu prüfen.

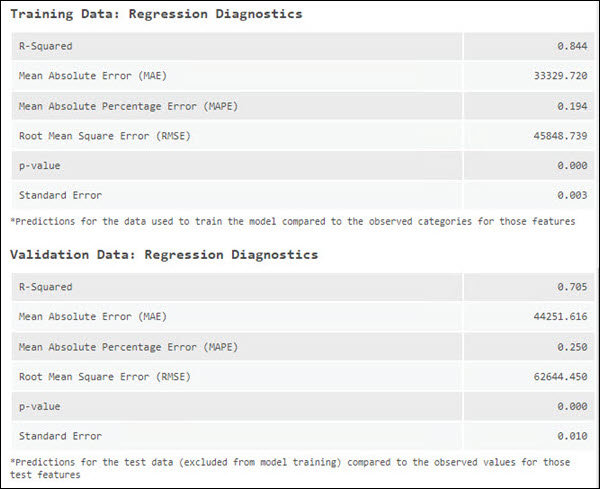

Validierungs- und Trainingsdatendiagnosen

Eine weitere wichtige Methode zur Bewertung der Modell-Performance besteht darin, mit dem Modell Werte für Features, die beim Training des Modells nicht berücksichtigt wurden, vorherzusagen und die so vorhergesagten Werte mit den beobachteten Werten zu vergleichen. Zu diesem Zweck können Diagnosen berechnet werden. Dieser Vorgang wird unter Verwendung der Trainingsdaten und der Testdaten (Validierungsdaten) durchgeführt. Zu Testzwecken schließt das Werkzeug standardmäßig 10 Prozent der Features unter Eingabe-Trainings-Features aus. Dies kann allerdings mit dem Parameter % der Trainingsdaten für die Validierung ausgeschlossen gesteuert werden. Ein Nachteil von OOB besteht darin, dass eine Teilmenge des Waldes (Bäume, die ein bestimmtes Feature des Trainings-Datasets nicht verwendet haben) und nicht der gesamte Wald verwendet wird. Durch das Ausschließen einiger Daten für die Validierung lassen sich Fehlerkennwerte für das gesamte Modell auswerten. In den Geoverarbeitungsmeldungen werden die Diagnosen in der Tabelle der Validierungsdatendiagnose sowie der Tabelle der Trainingsdatendiagnose erfasst. Mithilfe dieser Diagnosen können Sie sich einen Eindruck verschaffen, wie geeignet das Modell für die Daten ist.

Bei der Vorhersage einer kontinuierlichen Variable findet ein Vergleich zwischen dem Wert, der für die einzelnen Trainings- und Test-Features beobachtet wurde, und den Vorhersagen, die mit dem trainierten Modell für diese Features getroffen wurden, statt. In den Geoverarbeitungsmeldungen werden die zugehörigen Werte für R-Squared, Mean Absolute Error (MAE), Mean Absolute Percentage Error (MAPE), Symmetric Mean Absolute Percentage Error (SMAPE), Root Mean Square Error (RMSE), p-Wert und Standard Error erfasst. Diese Diagnosen ändern sich mit jeder Ausführung des Trainingsprozesses, da die Auswahl der Trainings- und Test-Datasets nach dem Zufallsprinzip erfolgt. Um ein Modell zu erstellen, das sich nicht mit jeder Ausführung ändert, können Sie einen Ursprung in der Umgebungseinstellung Zufallszahlengenerator festlegen.

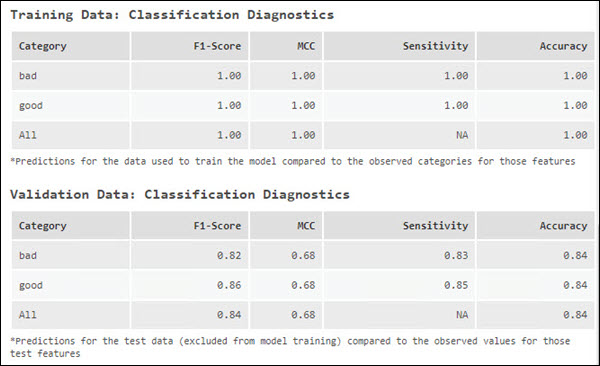

Bei der Vorhersage einer kategorialen Variable werden Sensitivität, Accuracy, F-Maß und MCC in den Geoverarbeitungsmeldungen erfasst. Diese Diagnosen werden anhand der Tabelle des Parameters Ausgabetabelle für Klassifizierungs-Performance (Konfusionsmatrix) berechnet. Darin wird festgehalten, wie oft eine Interessenkategorie richtig oder falsch klassifiziert wird und wie oft andere Kategorien fälschlicherweise als die Interessenkategorie klassifiziert werden. Die Sensitivität für die einzelnen Kategorien wird als Prozentsatz der Häufigkeit gemeldet, mit der Features mit der beobachteten Kategorie für diese Kategorie richtig vorhergesagt wurden. Wenn Sie beispielsweise "Land" und "Wasser" vorhersagen und "Land" eine Sensitivität von 1,00 hat, wurde jedes Feature, das als "Land" gekennzeichnet worden sein sollte, richtig vorhergesagt. Wurde ein Wasser-Feature jedoch fälschlicherweise als "Land" gekennzeichnet, schlägt sich dies nicht in der Sensitivitätszahl für "Land" nieder. Es zeigt sich allerdings in der Sensitivitätszahl für "Wasser", da eines der Wasser-Features nicht richtig klassifiziert wurde.

Die Accuracy-Diagnose berücksichtigt, wie gut Features einer bestimmten Kategorie vorhergesagt werden und wie häufig andere Kategorien fälschlicherweise als die Interessenkategorie klassifiziert wurden. Sie gibt eine Einschätzung dazu, wie häufig eine Kategorie in Bezug auf die Gesamtzahl an Beobachtungen für diese Kategorie richtig identifiziert wird. Bei der Klassifizierung einer Variablen mit nur zwei Klassen ist das Genauigkeitsmaß für beide Klassen gleich; die Sensitivität kann jedoch unterschiedlich sein. Bei der Klassifizierung einer Variablen mit mehr als zwei Klassen können Sensitivität und Genauigkeit (Accuracy) bei beiden Klassen unterschiedlich sein.

| Diagnose | Beschreibung | |||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

R-Squared | Der R-Squared-Wert ist ein Messwert für die Qualität der Übereinstimmung. Dies ist der Anteil der Varianz abhängiger Variablen, der durch das Regressionsmodell erklärt wird. Der Wert liegt in einem Bereich von 0,0 bis 1,0, wobei ein höherer Wert ein besseres Modell bedeutet. Wird die Anzahl an erklärenden Variablen erhöht, erhöht sich auch stets der R2-Wert. Aus diesem Grund bedeutet ein Anstieg des R2-Wertes nicht unbedingt eine Verbesserung der Modellanpassung, sondern eher eine Änderung der R2-Wertberechnung. | |||||||||||||||||||||||||

Mean Absolute Error (MAE) | MAE ist der Durchschnitt der absoluten Differenz zwischen den tatsächlichen Werten und den vorhergesagten Werten für den Parameter Interessenvariable. Der Wert 0 bedeutet, dass das Modell alle beobachteten Werte richtig vorhergesagt hat. MAE wird in den Einheiten der Interessenvariable angegeben, sodass der Wert nicht für verschiedene Modelle verglichen werden kann. | |||||||||||||||||||||||||

Mean Absolute Percentage Error (MAPE) | Der MAPE-Wert ähnelt dem MAE-Wert insofern als er die Differenz zwischen den tatsächlichen Werten und den vorhergesagten Werten darstellt. MAE stellt die Differenz in den ursprünglichen Einheiten dar, MAPE hingegen als Prozentsatz. MAPE ist somit ein relativer Fehler, wodurch er sich besser zum Vergleichen verschiedener Modelle eignet. Aufgrund der Berechnungsart kann MAPE nicht verwendet werden, wenn einer der tatsächlichen Werte 0 beträgt. Wenn die tatsächlichen Werte nahe 0 liegen, geht MAPE gegen unendlich. Eine weitere Einschränkung, die es bei MAPE zu berücksichtigen gilt, ist seine Asymmetrie. Angenommen, es liegen zwei Fälle vor, wo die Differenz zwischen den tatsächlichen Werten und den vorhergesagten Werten identisch ist, dann hat der Fall, wo der tatsächliche Wert kleiner ist, einen größeren Beitrag am MAPE-Wert. | |||||||||||||||||||||||||

Symmetric Mean Absolute Percentage Error (SMAPE) | Wie auch der MAPE-Wert stellt der SMAPE-Wert die Differenz zwischen den tatsächlichen Werten und den vorhergesagten Werten als Prozentsatz dar. Allerdings wurde beim SMAPE-Wert das Asymmetrieproblem bei der Berechnung gelöst. | |||||||||||||||||||||||||

Root Mean Square Error (RMSE) | RMSE ist die Wurzel der mittleren quadratischen Abweichung (Mean Squared Error, MSE) und entspricht der Quadratwurzel der gemittelten quadrierten Differenz zwischen den tatsächlichen Werten und den vorhergesagten Werten. Wie auch der MAE-Wert stellt der RMSE-Wert den mittleren Modell-Vorhersagefehler in den Einheiten der Interessenvariable dar, jedoch ist der RMSE sensitiv gegenüber großen Fehlern. Wenn Sie Modelle mit einer großen Differenz zwischen den tatsächlichen Werten und den vorhergesagten Werten vermeiden möchten, können Sie das Modell nach dem RMSE-Wert bewerten. | |||||||||||||||||||||||||

p-Wert | Der p-Wert ist ein statistisches Maß, das verwendet wird, um die Hypothese, dass keine Korrelation zwischen den Beobachtungen und den Vorhersagen besteht, zu validieren. Wenn der p-Wert kleiner als 0,05 ist, ist die Korrelation zwischen den Beobachtungen und den Vorhersagen signifikant. | |||||||||||||||||||||||||

Standardfehler | Dies ist der Standardfehler der Regression. Er gibt an, wie groß im Durchschnitt die Abweichung der beobachteten Werte von den vorhergesagten Werten ausfällt. | |||||||||||||||||||||||||

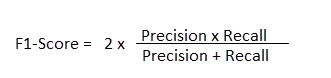

F-Maß | Das F-Maß ist ein Messwert für die Modell-Performance. Sie entspricht einem Wert zwischen 0 und 1, der für jede Klasse berechnet wird. Je höher das F-Maß, umso besser das Modell. Das F-Maß aller Klassen (Makro-F-Maß) entspricht dem Mittelwert des F-Maßes der einzelnen Klassen. Wenn in den einzelnen Klassen eine ungerade Anzahl an Features vorliegt, ist das F-Maß besser zur Modellbewertung geeignet als Accuracy. Das F-Maß ist ein Messwert, der eine Auswertung nach maximaler Precision bei maximalem Recall erlaubt. Precision berechnet sich, indem die Anzahl der richtigen Klassifizierungen für eine Interessenkategorie durch die Gesamtzahl der Vorhersagen für diese Interessenkategorie geteilt wird. Recall berechnet sich, indem die Anzahl der richtigen Klassifizierungen für eine Interessenkategorie durch die Anzahl der Features mit dieser Kategorie geteilt wird. Das F-Maß wird entsprechend wie folgt berechnet:

In der folgenden Tabelle wurde Klasse A 25 Mal richtig klassifiziert und 30 Mal vorhergesagt (25 + 4 + 1). Somit beträgt der Precision-Wert von Klasse A 25/30. Es sind 25 Features mit Klasse A (25 + 0 + 0) vorhanden. Somit beträgt der Recall-Wert von Klasse A 25/25. Das F-Maß von Klasse A beträgt 0,909.

| |||||||||||||||||||||||||

MCC | Ähnlich wie das F-Maß stellt der MCC eine Zusammenfassung der Konfusionsmatrix dar, wobei der Wert zwischen -1 und 1 liegt. Der Wert –1 bedeutet, dass das Modell alle Features falsch klassifiziert hat, und der Wert 1, dass das Modell alle Features richtig klassifiziert hat. Im Gegensatz zum F-Maß wird beim MCC auch berücksichtigt, wie oft die nicht relevante Kategorie vorhergesagt wurde. Somit ergibt sich nur dann ein hoher MCC-Wert, wenn die Modell-Performance für die Interessenkategorie und die nicht relevante Kategorie gut ist. | |||||||||||||||||||||||||

Sensitivität | Sensitivität entspricht dem Prozentsatz der Häufigkeit, mit der Features mit einer beobachteten Kategorie für diese Kategorie richtig vorhergesagt wurden. Sie berechnet sich, indem die Anzahl der richtigen Klassifizierungen für eine Interessenklasse durch die Anzahl der Features mit dieser Klasse geteilt wird. In der folgenden Tabelle wurde Klasse A 25 Mal richtig vorhergesagt, und es sind 25 Features (25 + 0 + 0) mit Klasse A vorhanden, sodass die Sensitivität von Klasse A 25/25 beträgt.

| |||||||||||||||||||||||||

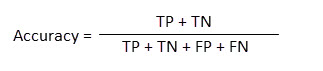

Genauigkeit | Accuracy ist die Häufigkeit, mit der eine Kategorie in Bezug auf die Gesamtzahl an Beobachtungen für diese Kategorie richtig identifiziert wird. Bei der Accuracy wird berücksichtigt, wie gut Features einer bestimmten Kategorie vorhergesagt werden und wie häufig andere Kategorien richtigerweise als nicht der Interessenkategorie entsprechend klassifiziert wurden. Die Accuracy wird wie folgt berechnet:

wobei TP für True Positive, TN für True Negative, FP für False Positive und FN für False Negative steht. In der folgenden Tabelle gilt für Klasse A Folgendes: TP beträgt 25, TN beträgt 45 (19 + 3 + 2 + 21), FP beträgt 5 (4 + 1) und FN beträgt 0 (0 + 0). Die Accuracy von Klasse A beträgt 70/(25+45+5+0) = 0,93. Die Accuracy aller Klassen beträgt (25 + 19 +21)/75 = 0,866.

|

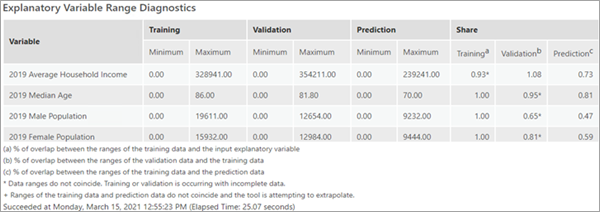

Tabelle "Diagnose des Bereichs der erklärenden Variablen"

Mithilfe der Bereichsdiagnose der erklärenden Variablen können Sie beurteilen, ob die für Training, Validierung und Vorhersage verwendeten Werte ausreichen, um ein performantes Modell zu erstellen, und ob die anderen Modelldiagnosen zuverlässig sind. Die für das Modelltraining verwendeten Daten haben erheblichen Einfluss auf die Qualität der resultierenden Klassifizierung und Vorhersagen. Im Idealfall sollten die Trainingsdaten repräsentativ für die zu modellierenden Daten sein. Standardmäßig werden 10 Prozent der Features aus dem Parameter Eingabe-Trainings-Features nach dem Zufallsprinzip für die Validierung ausgeschlossen. So ergibt sich ein Trainings-Dataset sowie ein Validierungs-Dataset. Die Tabelle Diagnose des Bereichs der erklärenden Variablen zeigt die Minimal- und die Maximalwerte für diese Datasets an. Wenn Features oder Raster vorhergesagt werden, werden außerdem die für die Vorhersage verwendeten Daten angezeigt.

Da Subsets nach dem Zufallsprinzip bestimmt werden, sind die Werte für die Variablen im Trainings-Subset möglicherweise nicht für alle Werte in Eingabe-Trainings-Features repräsentativ. Für jede kontinuierliche erklärende Variable gibt die Spalte Training in der Gruppe Anteil den Überlappungsprozentsatz zwischen dem Wertebereich des Trainings-Subsets und dem Wertebereich aller Features in Eingabe-Trainings-Features an. Wenn Variable A aus Eingabe-Trainings-Features z. B. die Werte 1 bis 100 und das Trainings-Subset die Werte 50 bis 100 aufweist, beträgt in der Spalte Training der Gruppe Anteil der Wert für Variable A 0,50 bzw. 50 Prozent. Für Variable A umfasst das Trainings-Subset 50 Prozent des Wertebereichs der Eingabe-Trainings-Features. Deckt das Trainings-Subset für jede erklärende Variable im Modell keinen ausreichend großen Wertebereich der Eingabe-Trainings-Features ab, kann dies andere Modelldiagnosen verzerren. Eine ähnliche Berechnung wird durchgeführt, um den Wert in der Tabellenspalte Validierung der Gruppe Anteil zu erstellen. Es ist wichtig, dass der Wertebereich, der zum Validieren des Modells verwendet wird, einen möglichst großen Bereich der zum Trainieren des Modells verwendeten Werte abdeckt. Wenn Variable B aus dem Trainings-Subset z. B. die Werte 1 bis 100 und das Validierungs-Subset die Werte 1 bis 10 aufweist, beträgt in der Spalte Validierung der Gruppe Anteil der Wert für Variable B 0,10 bzw. 10 Prozent. Ein solch geringer Wertebereich könnte nur niedrige Werte oder nur hohe Werte enthalten und somit andere Diagnosen verzerren. Enthält das Validierungs-Subset nur niedrige Werte, würden andere Modelldiagnosen, z. B. MSE (Mean Squared Error, mittlere quadratische Abweichung) oder der Prozentsatz der erklärten Variation, lediglich angeben, wie gut das Modell niedrige Werte vorhersagt, und nicht den gesamten Wertebereich der Eingabe-Trainings-Features berücksichtigen. Ein Wert größer als 1 gibt zudem an, dass der Wertebereich der Validierung größer ist als der Wertebereich im Trainings-Subset. Aus diesem Grund ergibt sich eine schlechte Validierungsdiagnose, da der Random-Forest-Algorithmus und der XGBoost-Algorithmus keine Extrapolation durchführen können.

Die Spalte Vorhersage in der Gruppe Anteil der Tabelle Diagnose des Bereichs der erklärenden Variablen ist von zentraler Bedeutung. Forest-basierte und Gradient-Boosting-Modelle nehmen keine Extrapolation vor, sie können nur den Wertebereich klassifizieren oder vorhersagen, für den das Modell trainiert wurde. Die Spalte Vorhersage in der Gruppe Anteil entspricht dem Überlappungsprozentsatz zwischen dem Wertebereich der Trainingsdaten und dem Wertebereich der Vorhersagedaten. Ein Wert von 1 gibt an, dass der Wertebereich im Trainings-Subset und der für die Vorhersage verwendete Wertebereich übereinstimmen. Ein Wert größer als 1 gibt an, dass der Wertebereich der Vorhersage größer ist als der Wertebereich im Trainings-Subset. Es ist ebenfalls ein Hinweis darauf, dass Sie versuchen, einen Wert vorherzusagen, für den das Modell nicht trainiert wurde.

Alle drei Anteildiagnosen sind nur gültig, wenn die Bereiche der Subsets übereinstimmen. Wenn das Validierungs-Subset für Variable C z. B. die Werte 1 bis 100 und das Trainings-Subset die Werte 90 bis 200 aufweist, würden sich die Werte um 10 Prozent überlappen, aber die Bereiche wären nicht lagegleich. In diesem Fall wird die Diagnose mit einem Sternchen gekennzeichnet, um anzugeben, dass es sich um nicht lagegleiche Bereiche handelt. Überprüfen Sie die Minimal- und Maximalwerte, um das Ausmaß und die Richtung der Nichtüberlappung zu ermitteln. Die Spalte Vorhersage in der Gruppe Anteil wird mit einem Pluszeichen (+) gekennzeichnet, wenn das Modell versucht, Vorhersagen außerhalb des Bereichs der Trainingsdaten zu treffen.

Es gibt keine absoluten Regeln hinsichtlich der Werte, die für ein Modell in der Tabelle Diagnose des Bereichs der erklärenden Variablen zulässig sind. In Anbetracht der Einschränkungen Ihrer Trainingsdaten sollten die Werte in den Spalten Training und Validierung der Gruppe Anteil so hoch wie möglich sein. Ist der Wert in der Spalte Validierung der Gruppe Anteil niedrig, sollten Sie in Erwägung ziehen, einen höheren Wert für den Parameter % der Trainingsdaten für die Validierung ausgeschlossen anzugeben. Der Wert in der Spalte Vorhersage der Gruppe Anteil sollte so nah an 1 liegen wie möglich. Ist der Wert in der Spalte Vorhersage der Gruppe Anteil niedrig, sollten Sie in Erwägung ziehen, einen niedrigeren Wert für den Parameter % der Trainingsdaten für die Validierung ausgeschlossen anzugeben. Sie können das Modell auch mehrmals ausführen und dann den Lauf auswählen, der die Werte für die Bereichsdiagnose am besten ausgleicht. Der für jeden Lauf verwendete Zufallsursprung wird in den Meldungen angezeigt.

Zusätzliche Ausgaben

Das Werkzeug Forest-basierte und geboostete Klassifizierung und Regression erzeugt verschiedene Tabellen, Diagramme und Ausgaben.

Trainierte Ausgabe-Features

Der Wert des Parameters Trainierte Ausgabe-Features enthält den Wert von Eingabe-Trainings-Features, einschließlich des Trainings-Datasets und des Test-(Validierungs-)Datasets, des im Modell verwendeten Wertes des Parameters Erklärende Trainingsvariablen, der vorhergesagten Werte, der Wahrscheinlichkeit des vorhergesagten Wertes in der Klassifizierung und der Wahrscheinlichkeit der anderen möglichen Werte in der Klassifizierung, wenn der Parameter Alle Vorhersagewahrscheinlichkeiten einbeziehen aktiviert ist. Ist die vorherzusagende Variable kontinuierlich, enthält die Ausgabe die Felder Residual und Standardized Residual. Ist die vorherzusagende Variable kategorial, enthält die Ausgabe das Feld Correctly Classified. Wenn das Modell die bekannte Kategorie richtig vorhersagt, wird das Feature mit Korrekt klassifiziert beschriftet, andernfalls mit Falsch klassifiziert. Bei Regressionsmodellen werden die trainierten Features basierend auf den standardisierten Residuen der Vorhersagen symbolisiert. Für die Klassifizierung beruht die Symbolisierung der trainierten Features darauf, ob ein Feature richtig klassifiziert wurde.

Die Felder der trainierten Ausgabe-Features enthalten die extrahierten Raster-Werte für jede Variable unter Erklärende Trainings-Raster und berechnete Entfernungswerte für jede Variable unter Erklärende Trainings-Entfernungs-Features. Diese neuen Felder können verwendet werden, um den Trainingsteil der Analyse erneut auszuführen, ohne jedes Mal die Raster-Werte zu extrahieren und Entfernungswerte zu berechnen. Der Wert von Trainierte Ausgabe-Features enthält zudem Vorhersagen für alle Features, darunter auch für die Features, die zum Training verwendet wurden und die zu Testzwecken ausgeschlossen wurden. Dies kann bei der Auswertung der Performance des Modells hilfreich sein. Das Feld trained_features im Wert von Trainierte Ausgabe-Features gibt an, ob ein Feature für das Training verwendet wurde.

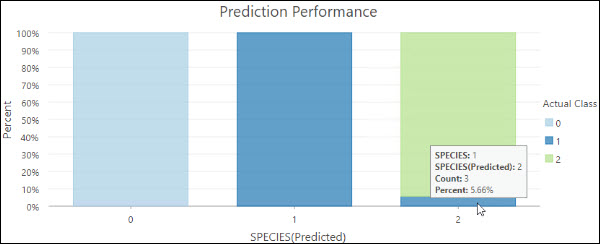

Wenn die vorherzusagende Variable kategorial ist, enthält der Wert von Trainierte Ausgabe-Features zudem die folgenden Diagramme:

- Vorhersage-Performance: Ein gestapeltes Balkendiagramm. Die einzelnen Balken stellen die vorhergesagte Kategorie dar, wobei die Farbe der Unterbalken der tatsächlichen Kategorie entspricht. Die Größe der Unterbalken zeigt den Anteil der Features mit einer bestimmten tatsächlichen Klasse, der in einer bestimmten vorhergesagten Klasse liegt. Beispiel: Der rechte Balken gibt an, dass 5,66 % der Features, für die die Kategorie "Species 2" vorhergesagt wurde, die tatsächliche Kategorie "Species 1" aufweisen.

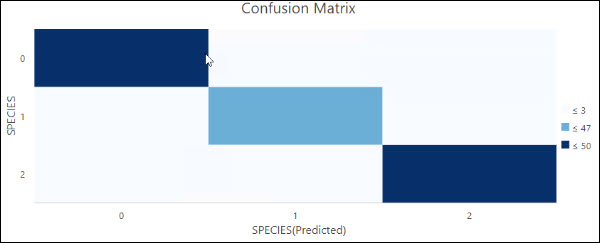

- Konfusionsmatrix: Ein Matrix-Heat-Diagramm. Die X-Achse repräsentiert die vorhergesagte Kategorie der Features für den Wert Eingabe-Trainings-Features, während die Y-Achse die tatsächliche Kategorie darstellt. Die diagonalen Zellen zeigen an, wie oft das Modell eine Kategorie richtig vorhergesagt hat. Eine höhere Anzahl in den diagonalen Zellen gibt an, dass das Modell gut funktioniert hat. Dieses Diagramm wird nur erzeugt, wenn der Parameter Variable als kategorial behandeln aktiviert wurde.

Beide Diagramme enthalten sowohl die Trainings- als auch die Testdaten. Um die Anpassung des Modells an die Trainingsdaten zu bewerten, müssen Sie die Features auswählen, bei denen das Feld trained_features den Wert 1 hat, und dann das Diagramm neu erstellen. Um die Modell-Performance für die Testdaten zu bewerten, müssen Sie die Features auswählen, bei denen das Feld trained_features den Wert 0 hat, und dann das Diagramm neu erstellen.

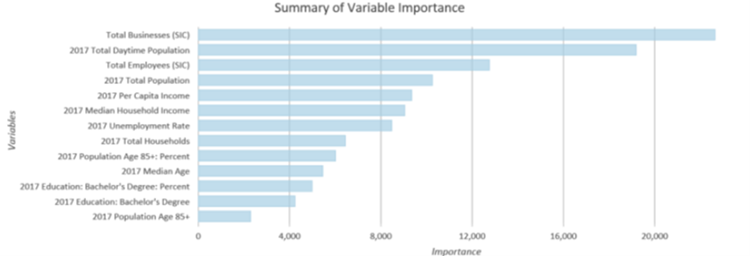

Ausgabetabelle zur Variablenbedeutung

Die Ausgabetabelle zur Variablenbedeutung enthält die im Modell verwendeten erklärenden Variablen und ihre Bedeutung.

Wenn Sie den Parameterwert Ausgabetabelle zur Variablenbedeutung angeben und der Wert für Anzahl der ausgeführten Validierungen 1 ist, gibt das Werkzeug ebenfalls das Diagramm Zusammenfassung der Variablenbedeutung aus. Wenn für den Parameter Modelltyp der Wert Forest-basiert angegeben wurde, werden im Diagramm die im Modell verwendeten Variablen auf der Y-Achse und ihre Bedeutung gemäß Gini-Koeffizient auf der X-Achse angezeigt. Wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde, basiert die auf der X-Achse angezeigte Bedeutung auf den Gain-Werten. Die erklärenden Variablen werden in der Reihenfolge ihrer Bedeutung angezeigt, wobei sich die Variable mit der höchsten Bedeutung oben befindet und die Variable mit der geringsten Bedeutung unten.

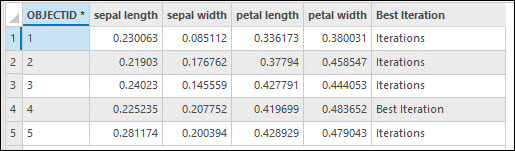

Wenn Sie den Parameterwert Ausgabetabelle zur Variablenbedeutung angeben und der Wert für Anzahl der ausgeführten Validierungen größer als 1 ist, enthält der Wert Ausgabetabelle zur Variablenbedeutung die Bedeutung jeder erklärenden Variablen für die einzelnen Ausführungen. Die Iteration mit dem höchsten Accuracy- oder R2-Wert wird zudem markiert. Der in den Geoverarbeitungsmeldungen ausgegebene Variablenbedeutungssatz ist nicht der Satz mit dem besten R-Squared- oder Accuracy-Wert, sondern der Satz, dessen R2- bzw. Accuracy-Wert dem R2- oder Accuracy-Medianwert am nächsten liegt.

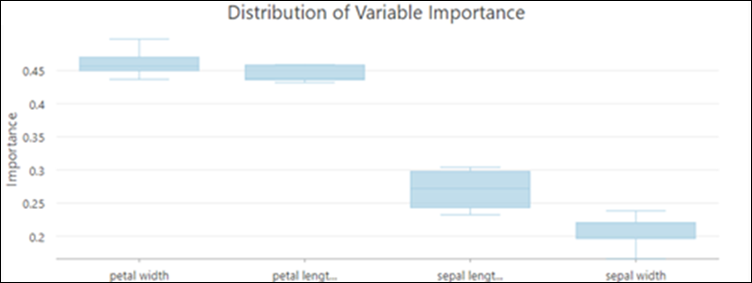

Wenn zudem der Wert für Anzahl der ausgeführten Validierungen größer als 1 ist, gibt das Werkzeug das Diagramm Verteilung der Variablenbedeutung aus. Über diesen Boxplot können Sie auswerten, wie sich die Variablenbedeutung in verschiedenen Ausführungen verändert.

Der Boxplot enthält die Verteilung der Werte für die Variablenbedeutung in allen ausgeführten Validierungen. Die Verteilung der Variablenbedeutung ist ein Indikator für die Stabilität des trainierten Modells. Wenn sich die Bedeutung einer Variablen im Laufe mehrerer Validierungen erheblich ändert, kann dies auf ein instabiles Modell hinweisen. Ein instabiles Modell lässt sich häufig durch einen höheren Wert im Parameter Anzahl der Baumstrukturen optimieren, weil dann komplexere Beziehungen zwischen den Daten erfasst werden.

Ausgabetabelle für Klassifizierungs-Performance (Konfusionsmatrix)

Ist die vorherzusagende Variable kategorial, ist der Parameter Ausgabetabelle für Klassifizierungs-Performance (Konfusionsmatrix) verfügbar. Diese Tabelle enthält alle Features aus dem Parameter Für Validierung ausgeschlossene Eingabe-Trainings-Features. Die einzelnen Zeilen stellen die tatsächliche Kategorie dar und die Spalten die vorhergesagte Kategorie. Die Tabelle enthält die Anzahl der True Positives (TP), True Negatives (TN), False Positives (FP) und False Negatives (FN) in den einzelnen Kategorien. Daraus lassen sich verschiedene Klassifizierungsdiagnosen wie Accuracy und Sensitivität berechnen.

Ausgabevorhersagen

Wenn Sie dieses Werkzeug zur Vorhersage von Features verwenden, handelt es sich bei dem Wert für Vorhergesagte Ausgabe-Features um eine Feature-Class, die den vom Modell vorhergesagten Wert für jedes Feature enthält. Wenn Sie damit Raster vorhersagen, handelt es sich bei dem Wert für Vorhergesagte Ausgabe-Oberfläche um ein Ausgabe-Raster mit den Vorhersageergebnissen.

Die Wahrscheinlichkeiten der vorhergesagten Werte werden angegeben, wenn der vorherzusagende Wert kategorial ist. Wenn der Parameter Alle Vorhersagewahrscheinlichkeiten einbeziehen aktiviert ist, werden auch die Wahrscheinlichkeiten aller anderen möglichen Werte einbezogen. Die Wahrscheinlichkeiten werden abhängig vom Wert des Parameters Modelltyp unterschiedlich berechnet:

- Forest-basiert: Die Wahrscheinlichkeiten werden anhand des Prozentsatzes der für die jeweilige Kategorie stimmenden Bäume berechnet.

- Gradient Boosting: Die Wahrscheinlichkeiten werden für jede Kategorie einzeln berechnet, indem eine logistische Funktion angepasst wird und Wahrscheinlichkeiten standardisiert werden, um sicherzustellen, dass die Summe 1 ergibt.

Sie können mittels Wahrscheinlichkeiten die Unsicherheit in einer Vorhersage messen. Werte näher 1 bedeuten eine höhere Konfidenz der Vorhersage. Sie können auch Wahrscheinlichkeiten für eine bestimmte Klasse im gesamten Untersuchungsgebiet analysieren, indem Sie den Parameter Alle Vorhersagewahrscheinlichkeiten einbeziehen aktivieren und die Wahrscheinlichkeit einer bestimmten Klasse für relevante Positionen bewerten.

Erweiterte Modelloptionen

Eine Stärke der Forest-basierten Methode besteht in der Erfassung der Gemeinsamkeiten schwacher Einflussvariablen (bzw. Bäume). Wird eine Beziehung dauerhaft durch einzelne Bäume erfasst, bedeutet dies, dass in den Daten eine starke Beziehung vorhanden ist, die auch bei einem nicht komplexen Modell erkennbar ist. Eine weitere Stärke von Forest-basierten Modellen, aber auch von Gradient-Boosting-Modellen besteht in der Kombination von schwachen Einflussvariablen (voneinander unabhängigen Bäumen bzw. einer Baumsequenz) zu einer starken Einflussvariablen. Die Anpassung der Modellparameter kann dabei helfen, eine große Anzahl schwacher Einflussvariablen zu erstellen, die zu einem starken Modell führen. Schwache Einflussvariablen werden erstellt, indem Sie weniger Informationen in den einzelnen Bäumen verwenden. Dies können Sie durch die Verwendung einer kleinen Teilmenge der Features pro Baumstruktur, einer kleinen Anzahl von Variablen pro Baumstruktur, einer geringen Baumstrukturtiefe oder einer beliebigen Kombination dieser drei Parameter erreichen. Die Anzahl der Bäume bestimmt, wie viele schwache Einflussvariablen erstellt werden. Je schwächer die Einflussvariablen (Bäume), desto mehr Bäume benötigen Sie, um ein starkes Modell zu erstellen.

Das Werkzeug verfügt über die folgenden erweiterten Trainings- und Validierungsoptionen:

- Der Standardwert für den Parameter Anzahl der Baumstrukturen ist 100. Die Erhöhung der Anzahl der Bäume im Forest- oder Boosting-Modell führt im Allgemeinen zu einer genaueren Modellvorhersage, doch wird für die Berechnung des Modells mehr Zeit benötigt. Wenn der Wert für den Parameter Anzahl der Baumstrukturen 0 beträgt, wird kein Modell erstellt, und der Wert für Trainierte Ausgabe-Features enthält nur die Features, die in den Parametern Eingabe-Trainings-Features und Erklärende Trainingsvariablen angegeben wurden.

- Die minimale Blattgröße ist die Anzahl an Beobachtungen, die mindestens erforderlich sind, um ein Blatt (den Endpunkt an einem Baum) beizubehalten. Der Standardwert beträgt 5 für die Regression und 1 für die Klassifizierung. Bei sehr umfangreichen Datasets führt ein höherer Wert für Minimale Blattgröße zu einer kürzeren Laufzeit des Werkzeugs. Bei einem kleinen Wert für Minimale Blattgröße (nah am Minimum) ist das Modell anfällig für Datenrauschen. Um ein stabileres Modell zu erhalten, experimentieren Sie mit einem größeren Wert für Minimale Blattgröße.

- Die maximale Baumstrukturtiefe ist die maximale Anzahl an Verzweigungen entlang eines Baums. Je größer die maximale Tiefe, desto mehr Verzweigungen werden erstellt. Dadurch steigt das Risiko einer Überanpassung des Modells. Der Standardwert für das Forest-basierte Modell ist datengesteuert und abhängig von der Anzahl der erstellten Bäume und der berücksichtigten Variablen. Der Standardwert für das Gradient-Boosting-Modell lautet 6. Bei Verwendung des Gradient-Boosting-Modells empfiehlt es sich, einen kleineren Wert für Maximale Baumstrukturtiefe festzulegen. Beachten Sie, dass ein Knoten nicht geteilt werden kann, wenn er den Wert für Minimale Blattgröße erreicht hat. Sind Werte für die Parameter Minimale Blattgröße und Maximale Baumstrukturtiefe festgelegt, hat der Wert für Minimale Blattgröße bei der Bestimmung der Baumstrukturtiefe Vorrang.

- Der Parameter Pro Baum verfügbare Daten (%) gibt den Prozentsatz der Features im Wert Eingabe-Trainings-Features an, die für die einzelnen Entscheidungsbäume verwendet werden. Die Standardeinstellung liegt bei 100 Prozent der Daten. Alle Entscheidungsbäume im Modell werden mithilfe einer zufälligen Teilmenge (etwa zwei Drittel) der verfügbaren Trainingsdaten erstellt. Durch die Verwendung eines niedrigeren Prozentsatzes der Eingabedaten für die einzelnen Entscheidungsbäume wird die Geschwindigkeit des Werkzeugs bei sehr großen Datasets beschleunigt.

- Der Parameter Anzahl der nach dem Zufallsprinzip erfassten Variablen gibt die Anzahl der erklärenden Variablen an, die zum Erstellen der einzelnen Entscheidungsbäume verwendet werden. Die einzelnen Entscheidungsbäume im Modell werden mithilfe einer zufälligen Teilmenge der erklärenden Variablen erstellt. Durch eine Erhöhung der Anzahl der in den einzelnen Entscheidungsbäumen verwendeten Variablen steigt die Wahrscheinlichkeit einer Überanpassung des Modells, vor allem dann, wenn mindestens eine dominante Variable vorhanden ist. Wenn es sich bei dem Wert für Vorherzusagende Variable um ein numerisches Feld handelt, besteht eine gängige Praxis (und die vom Werkzeug verwendete Standardeinstellung) darin, die Quadratwurzel aus der Gesamtzahl der erklärenden Variablen (Felder, Entfernungs-Features und Raster) zu ziehen. Wenn die Vorherzusagende Variable kategorial ist, wird die Gesamtzahl der erklärenden Variablen (Felder, Entfernungs-Features und Raster) durch 3 geteilt.

- Wenn für den Parameter Modelltyp der Wert Gradient Boosting angegeben wurde, sind in der Parameterkategorie Erweiterte Modelloptionen die folgenden Parameter verfügbar:

- L2-Normalisierung (Lambda): Ein Normalisierungsausdruck, der die Sensitivität der Vorhersagen gegenüber einzelnen Features reduziert. Eine Erhöhung dieses Wertes bewirkt, dass das Modell konservativer wird, und verhindert eine Überanpassung. Die Standardeinstellung ist 1. Wenn der Wert 0 ist, entspricht das Modell dem herkömmlichen Gradient-Boosting-Modell.

- Minimale Verlustreduzierung für Verzweigungen (Gamma): Ein Schwellenwert für die minimale Verlustreduzierung, die erforderlich ist, um Bäume zu verzweigen. Übersteigt die Verlustreduzierung einer potenziellen Verzweigung diesen Wert, wird die Verzweigung durchgeführt. Ein höherer Wert für Minimale Verlustreduzierung für Verzweigungen (Gamma) verhindert eine zu hohe Baumstrukturtiefe und die Überanpassung des Modells an die Trainingsdaten. Die Standardeinstellung ist 0.

- Lernrate (Eta): Ein Wert, der den Beitrag der einzelnen Bäume zur endgültigen Vorhersage reduziert. Eine niedrigere Lernrate verhindert eine Überanpassung des Modells, verlängert jedoch möglicherweise die Berechnungszeit.Der Standardwert ist 0,3. Zulässig ist ein Zahl größer 0 und kleiner gleich 1.

- Maximale Anzahl von Abschnitten zum Suchen von Verzweigungen: Definiert die Anzahl der Abschnitte, in die die Trainingsdaten unterteilt werden, um den besten Verzweigungspunkt zu finden. Der Standardwert beträgt 0. Dies entspricht der Verwendung eines Greedy-Algorithmus, der bei allen Datenpunkten potenzielle Verzweigungen erstellt. Bei einem Greedy-Algorithmus kann die Berechnung länger dauern. Bei einem kleineren Wert für Maximale Anzahl von Abschnitten zum Suchen von Verzweigungen werden die Daten in weniger Abschnitte aufgeteilt, sodass weniger Verzweigungen getestet werden. Niedrigere Werte führen zu geringerer Rechenzeit bei reduzierter Vorhersage-Performance. Bei einem größeren Wert werden die Daten in mehr Abschnitte aufgeteilt, sodass weitere Verzweigungen getestet werden. Niedrigere Werte führen zu besserer Modell-Performance bei längerer Rechenzeit. Der Wert 1 ist nicht zulässig.

- Der Parameter % der Trainingsdaten für die Validierung ausgeschlossen gibt den Prozentsatz (zwischen 10 und 50 Prozent) der Eingabe-Trainings-Features an, die als das Test-Dataset für die Validierung reserviert sind. Das Modell wird ohne diese zufällige Teilmenge der Daten trainiert. Die beobachteten Werte für diese Features werden mit den vorhergesagten Werten verglichen, um die Performance des Modells zu validieren. Der Standardwert ist 10 Prozent.

- Der Parameter Unsicherheit berechnen ist nur verfügbar, wenn für den Parameter Modelltyp der Wert Forest-basiert angegeben wurde und es sich bei der vorherzusagenden Variable nicht um eine kategoriale Variable handelt. Wenn Sie den Parameter Unsicherheit berechnen aktivieren, berechnet das Werkzeug für jede vorherzusagende Variable ein Vorhersageintervall von 90 Prozent. Wenn für Vorhersagetyp die Option Nur trainieren oder Features vorhersagen festgelegt ist, werden im Wert für Trainierte Ausgabe-Features oder Vorhergesagte Ausgabe-Features zwei zusätzliche Felder hinzugefügt. Diese Felder stellen die obere und untere Grenze des Vorhersageintervalls dar. Bei neuen Beobachtungen können Sie mit einem Konfidenzniveau von 90 Prozent vorhersagen, dass der Wert der Beobachtung innerhalb des Intervalls liegt, sofern die erklärenden Variablen identisch sind. Bei der Vorhersage eines Rasters werden dem Bereich Inhalt zwei Raster hinzugefügt, die die obere und untere Grenze des Vorhersageintervalls darstellen. Das Vorhersageintervall wird mit Quantil-Regressions-Forests berechnet. In einem Quantil-Regressions-Forest werden die Werte aus den einzelnen Blättern des Forests gespeichert und für eine Verteilung der vorhergesagten Werte verwendet, anstatt die vorhergesagten Werte aus der endgültigen Vorhersage des Forests beizubehalten.

Parameteroptimierung

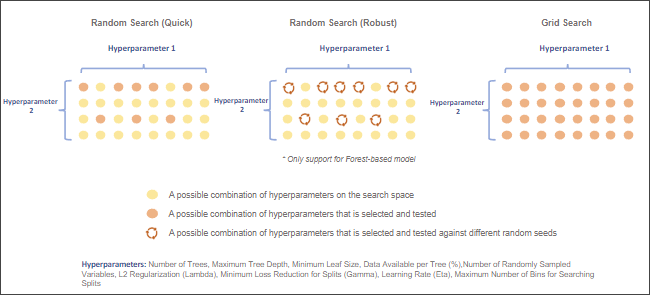

Forest-basierte und Gradient-Boosting-Modelle verfügen über mehrere Hyperparameter, mit denen das Modell optimiert werden kann. Es kann jedoch schwierig sein, für ein bestimmtes Dataset den besten Wert für die einzelnen Hyperparameter zu bestimmen. Das Werkzeug "Forest-basierte und geboostete Klassifizierung und Regression" bietet mehrere Optimierungsmethoden, mit denen verschiedene Kombinationen aus Hyperparameterwerten getestet werden, um den Hyperparametersatz mit der besten Modell-Performance zu bestimmen. Wenn Sie sich nicht sicher sind, welches der beste Wert für einen Hyperparameter ist, sollten Sie eine Optimierungsmethode verwenden. Es stehen drei Optimierungsmethoden zur Verfügung: Zufällige Suche (Schnell), Zufällige Suche (Zuverlässig) und Rastersuche.

Zur Verwendung der Parameteroptimierung müssen Sie das Kontrollkästchen Parameter optimieren und eine Option für Optimierungsmethode auswählen. Der Wert für den Parameter Optimierungsmethode ist standardmäßig die Option Zufällige Suche (Schnell). Das Werkzeug bietet zudem mehrere Optionen für die Objective-Funktion, womit unter Verwendung von ausgewählten Hyperparameterwerten die Modell-Performance bewertet wird. Ist die vorherzusagende Variable nicht kategorial, beinhaltet der Parameter Ziel optimieren (Objective) zwei Optionen: R-Squared und RMSE. Die Standardeinstellung ist R-Squared. Ist die vorherzusagende Variable kategorial, lauten die verfügbaren Optionen Accuracy, MCC (Matthews Correlation Coefficient; Matthews-Korrelationskoeffizient) und F-Maß. Die Standardeinstellung ist Accuracy. Mit dem Parameter Modellparametereinstellung werden die obere Grenze, die untere Grenze und das Intervall für den Suchraum eines Hyperparameters festgelegt. Wenn für den Parameter Optimierungsmethode der Wert Rastersuche angegeben wurde, durchsucht das Werkzeug alle Suchpunkte innerhalb des Suchraums und wählt die Hyperparameterwerte mit der besten Modell-Performance aus. Wenn für den Parameter Optimierungsmethode der Wert Zufällige Suche (Schnell) oder Zufällige Suche (Zuverlässig) angegeben wurde, wird der Parameter Anzahl der Ausführungen für Parametersets aktiviert. Damit wird die Anzahl an Suchpunkten im Suchraum, die durchsucht werden, festgelegt. Die Methode Zufällige Suche (Zuverlässig) erstellt für jeden Suchpunkt aus zehn verschiedenen Zufallsursprüngen ein Modell, wählt die Kombination aus Hyperparameterwerten aus, die den Medianwert der Modell-Performance aufweisen, und geht dann zum nächsten Suchpunkt über. Dieser Prozess wird vom Werkzeug wiederholt, bis alle potenziellen Suchpunkte durchsucht wurden. Zuletzt wählt das Werkzeug die Hyperparameterwerte mit der besten Modell-Performance aus.

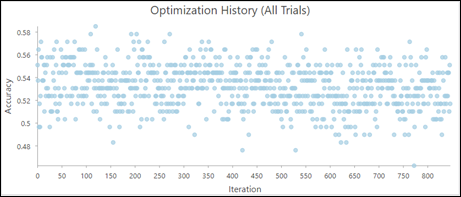

Wenn Sie die Hyperparameter optimieren, ist der Parameter Ausgabetabelle zur Parameteroptimierung verfügbar. In der Ausgabetabelle zur Parameteroptimierung werden alle Kombinationen von durchsuchten Hyperparameterwerten aufgeführt sowie die folgenden Diagramme:

- Optimierungsverlauf (alle Testläufe): Ein Diagramm zur Visualisierung des Optimierungsverlaufs.

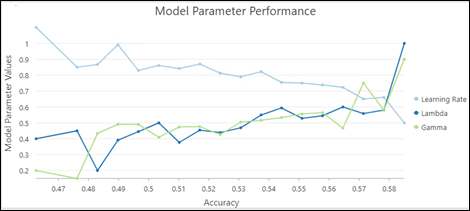

- Modellparameterleistung: Ein Diagramm, mit dem der Beitrag der einzelnen Hyperparameter zur Modell-Performance bewertet werden kann.

In diesem Beispiel führen höhere Lambda- und Gammawerte zu einer höheren Accuracy des Modells, geringere Lernraten führen ebenfalls zu einer höheren Accuracy des Modells.

Empfehlungen

Folgende Methoden haben sich bei der Verwendung dieses Werkzeugs bewährt:

- Die Performance des Werkzeugs kann eingeschränkt sein, wenn versucht wird, mit erklärenden Variablen, die außerhalb des Bereichs der für das Modelltraining verwendeten erklärenden Variablen liegen, Vorhersagen zu treffen. Forest-basierte und geboostete Modelle nehmen keine Extrapolation vor, sie können nur den Wertebereich klassifizieren oder vorhersagen, für den das Modell trainiert wurde. Bei Vorhersagen mit erklärenden Variablen, die einen erheblich höheren oder niedrigeren Bereich als den Bereich des ursprünglichen Trainings-Datasets aufweisen, schätzt das Modell, dass der Wert um den höchsten oder niedrigsten Wert im ursprünglichen Dataset liegt.

- Um die Performance beim Extrahieren von Werten aus dem Wert für Erklärende Trainings-Raster und der Berechnung von Entfernungen mithilfe des Parameters Erklärende Trainings-Entfernungs-Features zu verbessern, sollten Sie in Erwägung ziehen, das Modell anhand von 100 Prozent der Daten zu trainieren, ohne Daten für die Validierung auszuschließen. Zudem sollten Sie sich für die Erstellung von Trainierten Ausgabe-Features entscheiden. Wenn Sie das Werkzeug das nächste Mal ausführen, verwenden Sie den Wert für Trainierte Ausgabe-Features als den Wert des Parameters Eingabe-Trainings-Features und alle extrahierten Werte und Entfernungen als den Wert für Erklärende Trainingsvariablen, statt diese bei jedem Training des Modells zu extrahieren. Wenn Sie sich dazu entscheiden, legen Sie die Parameter Anzahl der Baumstrukturen, Maximale Baumstrukturtiefe und Anzahl der nach dem Zufallsprinzip erfassten Variablen auf 1 fest, um einen sehr kleinen Platzhalterbaum für die schnelle Vorbereitung Ihrer Daten zu Analysezwecken zu erstellen.

- Aus Performance-Gründen ist der Parameter Erklärende Trainings-Entfernungs-Features nicht verfügbar, wenn der Parameter Vorhersagetyp den Wert Raster vorhersagen aufweist. Um Entfernungen zu Features als erklärende Variablen einzubeziehen, können Sie mit dem Werkzeug Entfernungsakkumulation Entfernungs-Raster berechnen und diese Raster in den Parameter Erklärende Trainings-Raster aufnehmen.

- Obwohl der Standardwert des Parameters Anzahl der Baumstrukturen 100 beträgt, ist diese Zahl nicht datengesteuert. Die Anzahl der erforderlichen Bäume nimmt mit der Komplexität der Beziehungen zwischen den erklärenden Variablen, der Größe des Datasets und der vorherzusagenden Variable sowie der Variation dieser Variablen zu.

- Erhöhen Sie die Anzahl der Bäume im Wald, und beobachten Sie die OOB- oder Klassifizierungsfehler. Sie sollten den Wert für Anzahl der Baumstrukturen mindestens um das Dreifache auf mindestens 500 Bäume erhöhen, um die Performance des Modells bestmöglich auswerten zu können.

- Die Ausführungszeit des Werkzeugs ist stark abhängig von der Anzahl der pro Baum verwendeten Variablen. Bei Verwendung einer kleinen Anzahl von Variablen pro Baum sinkt die Wahrscheinlichkeit einer Überanpassung. Allerdings sollten Sie bei einer kleinen Anzahl von Variablen pro Baum viele Bäume verwenden, um die Performance des Modells zu verbessern.

Bei Verwendung des Modelltyps "Gradient Boosting" ist die Laufzeit des Werkzeugs stark vom Wert für den Parameter Maximale Anzahl von Abschnitten zum Suchen von Verzweigungen abhängig. Der Standardwert für den Parameter Anzahl von Abschnitten ist 0, was der Verwendung eines Greedy-Algorithmus entspricht. Dieser Algorithmus erstellt bei jedem Datenpunkt potenzielle Verzweigungen, was zu einer langen Laufzeit führen kann. Aus diesem Grund sollten Sie bei großen Datenmengen oder vielen Suchpunkten in der Optimierung einen geeigneten Wert für den Parameter Maximale Anzahl von Abschnitten zum Suchen von Verzweigungen verwenden.

- Um ein Modell zu erstellen, das sich nicht mit jeder Ausführung ändert, können Sie einen Ursprung in der Umgebungseinstellung "Zufallszahlengenerator" festlegen. Das Modell besitzt dann noch immer eine gewisse Zufälligkeit, doch ist diese Zufälligkeit zwischen den einzelnen Ausführungen konsistent.

- Die Variablenbedeutung bietet eine Diagnosemöglichkeit, mit der Sie herausfinden können, welche Variablen die Modellergebnisse beeinflussen. Es wird jedoch nicht gemessen, wie gut die Modellvorhersagen sind. Als Best Practice empfiehlt sich die Verwendung aller Daten für das Training. Legen Sie hierzu den Parameter % der Trainingsdaten für die Validierung ausgeschlossen auf 0 fest, und analysieren Sie den Boxplot der Variablenbedeutung. Ändern Sie als Nächstes weitere Parameter wie Anzahl der Baumstrukturen oder Maximale Baumstrukturtiefe, und analysieren Sie die Boxplots, bis Sie ein stabiles Modell erhalten. Wenn Sie in Bezug auf die Variablenbedeutung ein stabiles Modell trainiert haben, können Sie den Parameter % der Trainingsdaten für die Validierung ausgeschlossen erhöhen, um die Genauigkeit (Accuracy) des Modells zu bestimmen. Wenn es sich um ein Forest-basiertes Modell handelt, müssen Sie zur Bestimmung des Accuracy-Wertes die OOB-Fehler in den Diagnosemeldungen analysieren. Wenn das Modell eine stabile Variablenbedeutung und ausreichende Genauigkeit (Accuracy) aufweist, können Sie den Wert für Anzahl der ausgeführten Validierungen auf 1 festlegen; Sie erhalten dann ein Diagramm mit einem Balken, der die endgültige Variablenbedeutung des Modells darstellt.

Referenzen

Breiman, Leo. (1996). "Out-Of-Bag Estimation". Abstract.

Breiman, L. (1996). "Bagging predictors". Machine learning 24 (2): 123–140.

Breiman, Leo. (2001). "Random Forests". Machine Learning 45 (1): 5-32. https://doi.org/10.1023/A:1010933404324.

Breiman, L., J.H. Friedman, R.A. Olshen und C.J. Stone. (2017). Classification and regression trees. New York: Routledge. Kapitel 4.

Chen, T. und Guestrin, C. (2016). "XGBoost: A Scalable Tree Boosting System". In Proceedings of the 22nd ACM SIGKDD Conference on Knowledge Discovery and Data Mining, 785-794.

Dietterich, T. G. (Juni 2000). "Ensemble methods in machine learning". In International workshop on multiple classifier systems, 1–15. Springer, Berlin, Heidelberg.

Gini, C. (1912, 1955). Variabilità e mutabilità. Nachgedruckt in: Memorie di metodologica statistica (Hrsg. E. Pizetti und T. Salvemini). Rom: Libreria Eredi Virgilio Veschi.

Grömping, U. (2009). "Variable importance assessment in regression: linear regression versus random forest." The American Statistician 63 (4): 308–319.

Ho, T. K. (August 1995). "Random decision forests". In Document analysis and recognition, 1995., proceedings of the third international conference on Document Analysis and Recognition, Bd. 1: 278-282. IEEE.

James, G., D. Witten, T. Hastie und R. Tibshirani. (2013). An introduction to statistical learning, Bd. 112. New York: Springer.

LeBlanc, M. und R. Tibshirani. (1996). "Combining estimates in regression and classification". Journal of the American Statistical Association 91 (436): 1641–1650.

Loh, W. Y. und Y. S. Shih. (1997). "Split selection methods for classification trees". Statistica sinica, 815-840.

Meinshausen, Nicolai. "Quantile regression forests". Journal of Machine Learning Research 7. Juni (2006): 983-999.

Nadeau, C. und Y. Bengio. (2000). "Inference for the generalization error". In Advances in neural information processing systems, 307-313.

Strobl, C., A. L. Boulesteix, T. Kneib, T. Augustin und A. Zeileis. (2008). "Conditional variable importance for random forests". BMC bioinformatics 9 (1): 307.

Zhou, Z. H. (2012). "Ensemble methods: foundations and algorithms." CRC Press.