L’outil Prévision basée sur une forêt utilise la régression basée sur une forêt pour prévoir les tranches horaires futures d’un cube spatio-temporel. La sortie principale est une carte de l’intervalle temporel final prévu, ainsi que des messages d’information et des diagrammes contextuels. D’autres variables explicatives peuvent être fournies pour améliorer la prévision de la variable d’analyse, et vous pouvez estimer et visualiser les effets non immédiats entre les variables explicatives et la variable en cours de prévision. Vous pouvez également construire des modèles basés sur une forêt à chaque localisation de façon indépendante, construire un modèle unique entraîné à partir de toutes les localisations ou construire des modèles distincts dans chaque agrégat de séries chronologiques. De plus, vous avez la possibilité de détecter les points aberrants dans chaque série chronologique afin d’identifier les emplacements et les heures qui s’écartent significativement des modèles et des tendances du reste des séries chronologiques.

Cet outil utilise le même algorithme sous-jacent que l’outil Classification et régression basées sur une forêt utilisé pour la régression. Les données d’entraînement utilisées pour construire le modèle de régression basé sur une forêt sont conçues avec des fenêtres horaires sur chaque variable du cube spatio-temporel.

Pour en savoir plus sur l’outil Classification et régression basées sur une forêt

Applications possibles

Les modèles de régression basés sur une forêt reposant sur peu d’hypothèses concernant les données, ils sont utilisés dans de nombreux contextes. Ils sont plus efficaces que d’autres méthodes de prévision lorsque les données ont des tendances et des saisons complexes, ou lorsqu’elles évoluent d’une façon différente des fonctions mathématiques courantes, telles que polynômes, les courbes exponentielles ou les signaux sinusoïdaux.

Vous pouvez par exemple utiliser cet outil dans les applications suivantes :

- Un arrondissement scolaire peut utiliser cet outil pour prévoir le nombre d’élèves qui seront absents chaque jour de la semaine suivante dans chaque école de l’arrondissement.

- Un gouverneur peut anticiper le nombre d’hospitalisation pour maladie infectieuse sur deux semaines. Cette prévision peut inclure le nombre de résultats de test positifs comme variable explicative, et l’outil modélise l’effet différé entre les tests positifs et les hospitalisations.

- Des responsables publics peuvent utiliser cet outil pour anticiper les besoins en électricité et en eau pour le mois suivant dans les différents quartiers de leur propre circonscription administrative.

- Des magasins de vente au détail peuvent utiliser cet outil pour prévoir le moment où chaque produit sera épuisé afin de mieux gérer l’inventaire.

- Les urbanistes peuvent utiliser cet outil pour prévoir les populations futures et évaluer la demande en logement, énergie, alimentation et infrastructure. Les villes qui présentent des tailles et des tendances de population similaires peuvent être regroupées dans un agrégat, et des modèles basés sur une forêt peuvent être construits pour chaque groupe.

Prévision et validation

L’outil construit deux modèles tout en prévoyant chaque série chronologique. Le premier est le modèle de prévision, qui est utilisé pour prévoir les valeurs des pas de temps futurs. Le second est le modèle de validation, qui sert à valider les valeurs prévues.

Remarque :

Cette section décrit l’option Localisation spécifique du paramètre Échelle de modèle. Les options Cube entier et Agrégat de séries chronologiques fonctionnent de manière analogue. Reportez-vous à la rubrique Extension de l’échelle de modèle pour plus d’informations.

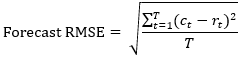

Modèle de prévision

Le modèle de prévision est construit en concevant une forêt avec les valeurs de la série chronologique à chaque localisation du cube spatio-temporel. Cette forêt sert ensuite à prévoir la prochaine tranche horaire. La valeur prévue au nouvel intervalle temporel est comprise dans le modèle de forêt, et l’intervalle temporel suivant est prévu. Ce traitement récursif se poursuit pour tous les intervalles temporels futurs. L’ajustement de la forêt à chaque série chronologique se mesure par la racine carrée de l’erreur quadratique moyenne (EQM) de prévision, qui est égale à la racine carrée de la différence au carré moyenne entre le modèle de forêt et les valeurs de la série chronologique.

L’image suivante illustre les valeurs brutes d’une série chronologique et un modèle de forêt ajusté à la série chronologique avec les prévisions de deux intervalles temporels futurs. L’EQM de prévision mesure la différence entre les valeurs ajustées de la forêt et les valeurs brutes de la série chronologique.

L’EQM de prévision mesure uniquement le degré d’ajustement du modèle de forêt avec les valeurs brutes de la série chronologique. Il ne mesure pas la qualité des prévisions des valeurs futures par le modèle de prévision. Il est courant qu’un modèle de forêt s’ajuste bien à une série chronologique, mais qu’il ne fournisse pas de prévisions exactes après l’extrapolation. Le modèle de validation résout ce problème.

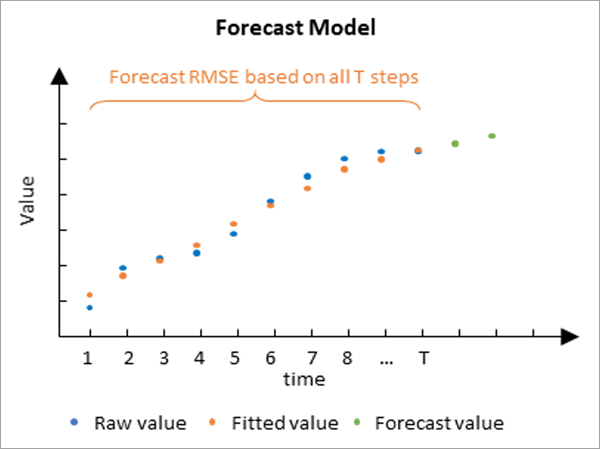

Modèle de validation

Le modèle de validation est utilisé pour déterminer l’aptitude du modèle de prévision à prévoir les valeurs futures de chaque série chronologique. Il est construit en excluant certains des intervalles temporels finaux de chaque série chronologique et en ajustant le modèle de forêt aux données non exclues. Ce modèle de forêt est ensuite utilisé pour prévoir les valeurs des données qui ont été retenues, et les valeurs prévues sont comparées aux valeurs brutes qui étaient masquées. Par défaut, 10 pour cent des intervalles temporels sont retenus pour validation, mais ce nombre peut évoluer à l’aide du paramètre Numer of Time Steps to Exclude for Validation (Nombre d’intervalles temporels à exclure pour la validation). Le nombre de pas de temps exclus ne peut pas dépasser 25 % du nombre de pas de temps, et aucune validation n’est effectuée si une valeur de 0 est spécifiée. La précision des prévisions est mesurée par le calcul d’une statistique d’EQM de validation, qui est égale à la racine carrée de la différence quadratique moyenne entre les valeurs prévues et les valeurs brutes des pas de temps exclus.

L’image suivante illustre un modèle de forêt ajusté à la première moitié d’une série chronologique et utilisé pour prévoir la seconde moitié de la série chronologique. L’EQM de validation mesure l’écart entre les valeurs prévues et les valeurs brutes aux pas de temps retenus.

Le modèle de validation est important car il peut comparer directement les valeurs prévues aux valeurs brutes en vue de mesurer la qualité de prévision de la forêt. Il n’est pas réellement utilisé pour faire des prévisions, mais sert à justifier le modèle de prévision.

Remarque :

La validation des prévisions de séries chronologiques est similaire à une technique courante appelée validation croisée, même si elles diffèrent sur le point suivant : la validation des prévisions exclut toujours les derniers pas de temps pour la validation, alors que la validation croisée exclut soit un sous-ensemble aléatoire des données, soit chaque valeur de manière séquentielle.

Interprétation

Plusieurs considérations doivent être prises en compte lors de l’interprétation des valeurs EQM de prévision et EQM de validation.

- Il n’est pas possible de comparer directement les valeurs EQM car elles mesurent des choses différentes. L’EQM de prévision mesure l’ajustement du modèle de forêt aux valeurs brutes des séries chronologiques et l’EQM de validation mesure la qualité de prévision des valeurs futures du modèle. Comme l’EQM de prévision utilise plus de données et n’effectue pas d’extrapolation, elle est généralement plus petite que l’EQM de validation.

- Les deux valeurs EQM ont les mêmes unités que les données. Par exemple, si vos données sont des mesures de température en degrés Celsius, une EQM de validation de 50 est très élevée car cela signifie que les valeurs prévues diffèrent des valeurs réelles d’environ 50 degrés en moyenne. Toutefois, si vos données correspondent aux recettes quotidiennes en dollars américains d’un important point de vente, la même EQM de validation de 50 est très faible car elle signifie que les recettes quotidiennes prévues ne diffèrent des valeurs réelles que de 50 dollars par jour en moyenne.

Créer et entraîner le modèle de forêt

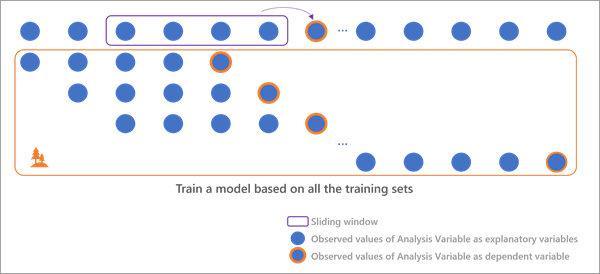

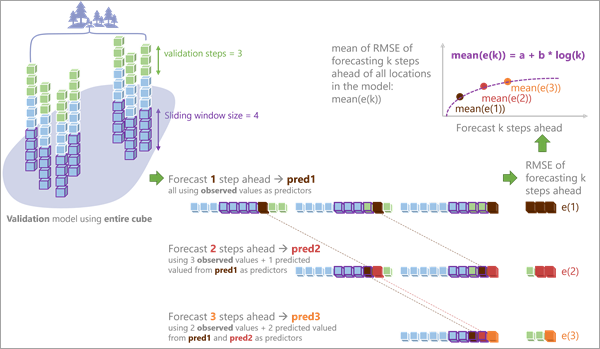

Pour prévoir les valeurs futures, le modèle de forêt doit être entraîné en associant des variables explicatives à des variables dépendantes pour chaque localisation. Le modèle de forêt a besoin de données d’entraînement répétées, mais chaque localisation ne comporte qu’une seule série chronologique. Des fenêtres horaires permettent de créer plusieurs jeux de variables explicatives et dépendantes au sein d’une seule série chronologique. Les intervalles temporels au sein de chaque fenêtre horaire sont utilisés comme variables explicatives, et l’intervalle temporel suivant après la fenêtre horaire est la variable dépendante. Par exemple, si une localisation comporte 20 intervalles temporels et que la fenêtre horaire correspond à 4 intervalles temporels, alors 16 jeux de variables explicatives et dépendantes sont utilisées pour entraîner la forêt à cette localisation. Le premier jeu comporte les intervalles temporels 1, 2, 3 et 4 comme variables explicatives et l’intervalle temporel 5 comme variable dépendante. Le deuxième jeu comporte les intervalles temporels 2, 3, 4 et 5 comme variables explicatives et l’intervalle temporel 6 comme variable dépendante. Le dernier jeu comporte les intervalles temporels 16, 17, 18 et 19 comme variables explicatives et l’intervalle temporel 20 comme variable dépendante. Vous pouvez spécifier le nombre d’intervalles temporels au sein de chaque fenêtre horaire à l’aide du paramètre Time Step Window (Fenêtre d’intervalles temporels). La valeur minimale de la fenêtre horaire est de 1 (un seul intervalle temporel dans chaque fenêtre horaire) et sa valeur maximale est égale à un tiers du nombre d’intervalles temporels à la localisation.

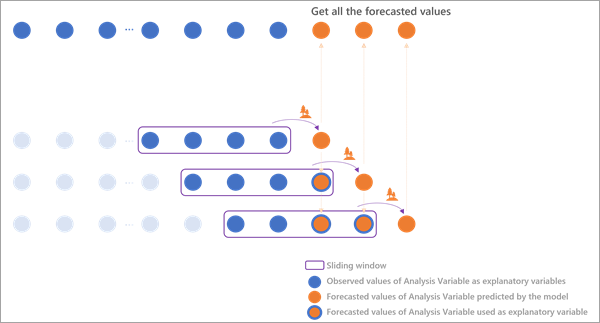

À l’aide du modèle de forêt entraîné, les intervalles temporels finaux à la localisation servent de variables explicatives pour prévoir le premier intervalle temporel futur. Le deuxième intervalle temporel futur est ensuite prévu à l’aide des intervalles temporels précédents dans la fenêtre horaire, où un de ces intervalles temporels est la première valeur prévue. Le troisième intervalle temporel prévu utilise les intervalles temporels précédents dans la fenêtre, où deux de ces intervalles temporels sont des intervalles temporels prévus précédents. Ce traitement se poursuit à travers tous les intervalles temporels futurs.

L’image suivante illustre les jeux de variables explicatives et dépendantes utilisées pour entraîner le modèle de forêt et prévoir les sept premiers intervalles temporels futurs:

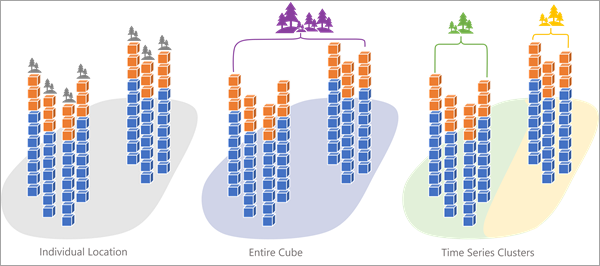

Étendre l’échelle de modèle

En plus de construire des modèles de prévision distincts à chaque localisation, vous pouvez regrouper les localisations et construire un modèle de prévision unique qui sera utilisé par toutes les localisations du groupe. Le regroupement des localisations vous permet de réaliser des analyses à différentes échelles, par exemple des modèles de population urbaine selon la taille totale de la population. Vous pouvez également construire un modèle global avec toutes les localisations dans le même groupe.

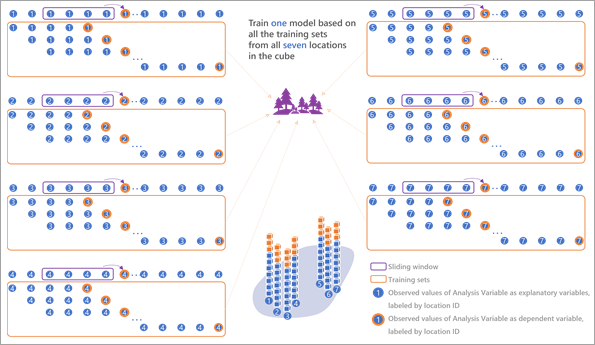

Avec le regroupement, le modèle de prévision partagé utilise les fenêtres horaires de chaque localisation du groupe comme données d’entraînement. Il dispose ainsi d’un nombre beaucoup plus important de données, qui permettent d’en savoir plus sur les modèles et tendances des séries chronologiques, que des localisations spécifiques. Cela est particulièrement important pour les séries chronologiques courtes où chacune renferme des données d’entraînement limitées. Lorsque toutes les séries chronologiques du groupe ont des valeurs et modèles similaires, ces données d’entraînement supplémentaires permettent de réaliser des prévisions plus précises de chaque localisation du groupe en incorporant les modèles des autres localisations. Cependant, si les séries chronologiques des localisations du groupe ont des valeurs et modèles très différents, l’incorporation de leurs modèles réduit la précision des prévisions. Il est donc important de regrouper uniquement les séries chronologiques qui sont similaires.

Vous pouvez définir l’échelle de l’analyse avec le paramètre Échelle de modèle. L’option Localisation spécifique par défaut génère des modèles indépendant à chaque localisation pour une analyse d’échelle locale. L’option Cube entier génère un modèle unique à l’aide de toutes les localisations pour une analyse d’échelle globale. L’option Agrégat de séries chronologiques génère un modèle pour chaque agrégat d’un résultat d’agrégation de séries chronologiques pour une analyse à l’échelle des agrégats (si les agrégats forment des régions, il s’agit d’une analyse d’échelle régionale). La variable contenant les résultats d’agrégation de séries chronologiques est fournie dans le paramètre Variable d’agrégat.

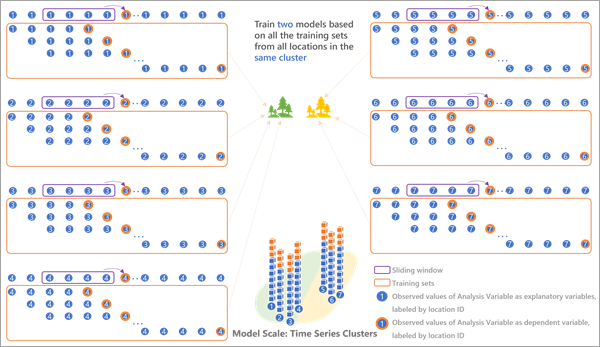

L’image ci-dessous montre un exemple de construction d’un modèle unique pour le cube entier avec sept localisations :

L’image ci-dessous montre un exemple de construction de modèles distinctes pour chacun des deux agrégats de séries chronologiques :

Inclure d’autres variables et l’effet de distance

Même si les modèles de régression basés sur une forêt peuvent effectivement capturer des modèles et tendances complexes des séries chronologiques, vous pouvez les améliorer en intégrant des informations issues d’autres variables associées. Par exemplee, le fait de connaître les niveaux de pollution peut aider à prévoir le nombre d’admissions aux urgences pour asthme, la pollution étant un facteur déclencheur de crises d’asthme.

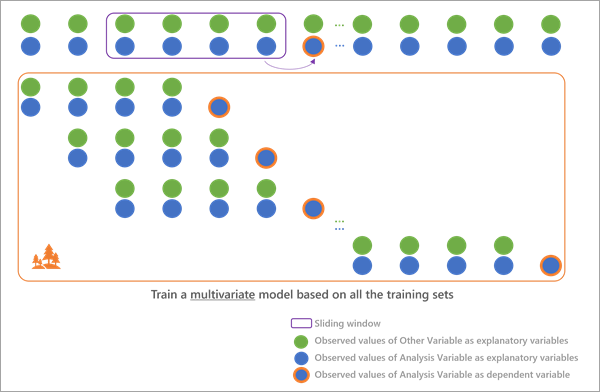

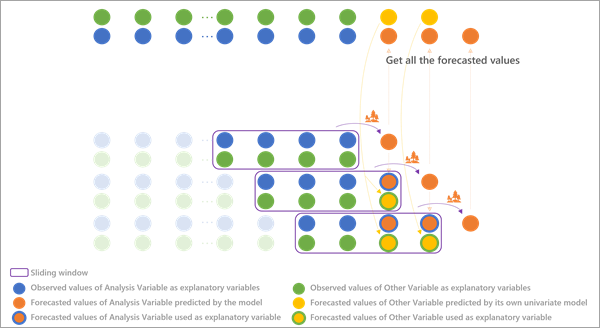

Vous pouvez inclure des variables associées stockées dans le même espace temporel à l’aide du paramètre Autres variables afin de prévoir la variable d’analyse en utilisant la prévision multivariée basée sur une forêt. Pour entraîner le modèle de régression multivarié basé sur une forêt, chaque autre variable est intégrée dans chaque fenêtre horaire et utilisée pour prévoir la valeur qui suit la fenêtre horaire, de la même manière que les fenêtres horaires sont utilisées pour la variable d’analyse, comme cela est décrit à la section Créer et entraîner le modèle de forêt.

Lors de la prévision de nouveaux intervalles temporels, chaque variable associée est prévue à l’aide d’une prévision basée sur une forêt univariée, ces valeurs prévues faisant office de variables explicatives lors de la prévision des valeurs futures de la variable d’analyse. Les résultats de toutes les prévisions (la variable d’analyse et toutes les variables explicatives) sont stockés dans le cube spatio-temporel en sortie.

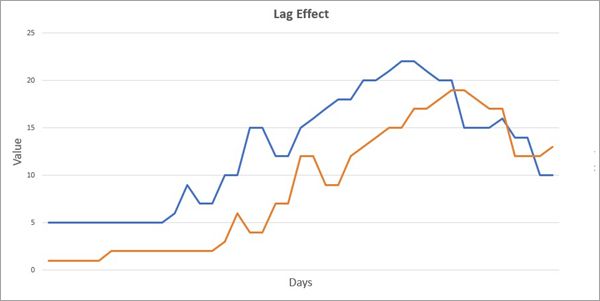

Vous pouvez également utiliser l’outil Prévision basée sur une forêt pour estimer et visualiser les effets non immédiats entre la variable d’analyse et les autres variables. L’effet de distance se produit en cas de décalage entre la modification d’une autre variable et la modification de la variable d’analyse. Il se produit dans de nombreux cas impliquant les séries chronologiques de plusieurs variables. Par exemple, les dépenses de publicité ont un effet non immédiat sur les recettes commerciales, car les gens ont besoin de voir la publicité un certain nombre de fois avant d’acheter. Dans l’exemple précédent du lien entre niveaux de pollution et visites aux urgences pour asthme, il peut également y avoir un décalage entre une élévation des niveaux de pollution et une augmentation du nombre de visites aux urgences, car les effets néfastes sur la santé peuvent prendre du temps avant de nécessiter des soins urgents.

L’image suivante présente l’effet de distance, où les variations de valeur de la série chronologique bleue sont décalées de quatre jours après la ligne orange :

En présence d’un décalage entre des variables explicatives et la variable d’analyse, vous pouvez obtenir plus d’informations relatives à la variable d’analyse en jetant un regard retrospectif sur la durée du décalage. Par exemple, si le décalage entre les dépenses de publicité et les recettes commerciales est de deux semaines, lors de la prévision des recettes commerciales d’une journée précise, il est plus intéressant d’un point de vue informatif de regarder les dépenses de publicité des deux dernières semaines par rapport au montant dépensé les derniers jours.

Le modèle de forêt peut détecter et utiliser l’effet non immédiat entre des variables, car la fenêtre temporelle en mouvement prévoit toujours l’intervalle temporel qui la suit immédiatement. La dernière valeur de la fenêtre horaire se trouve toujours un intervalle temporel avant la prévision. L’avant-dernier intervalle temporel se trouve toujours deux intervalles temporels avant la prévision, et ainsi de suite. Compte tenu des décalages de fenêtre temporelle, chaque variable explicative est un facteur distinct pour chaque intervalle temporel dans la fenêtre temporelle, ce qui lui permet de comparer différentes variables explicatives à différents décalages et de déterminer laquelle est la plus importante pour la prévision. Voir Fonctionnement de l’outil Classification et régression basées sur une forêt pour de plus amples informations.

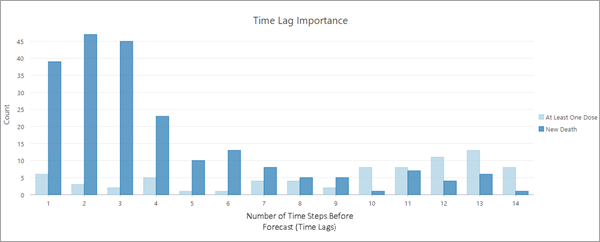

Par exemple, le diagramme ci-dessous indique les variables décalées temporellement de chaque comté, importantes dans la prévision du nombre de décès quotidiens dus à la COVID-19 début 2021. Le modèle utilise le nombre de personnes vaccinées chaque jour comme variable explicative Les valeurs de l’axe x se rapportent à chaque intervalle temporel dans la fenêtre temporelle, cette image présentant 14 valeurs matérialisant une fenêtre temporelle de 14 jours. Les valeurs de l’axe x représentent le nombre d’intervalles temporels avant la prévision, et reviennent donc en arrière dans le temps lorsque vous vous déplacez de gauche à droite dans le diagramme. La valeur 1 la plus à gauche indique le jour qui précède la prévision, ce qui correspond à l’intervalle temporel final dans la fenêtre temporelle. De même, la valeur 14 la plus à droite représente 14 jours avant la prévision, ce qui correspond au premier intervalle temporel de la fenêtre temporelle de 14 jours. Pour chaque intervalle temporel, les colonnes en bleu clair et en bleu foncé représentent le nombre de localisations où il a été déterminé que ce facteur compte parmi les facteurs les plus importants de la prévision des nouveaux décès quotidiens dus à la COVID-19. Par conséquent, plus le nombre est élevé, plus le facteur est important sur l’ensemble des localisations. Les barres en bleu foncé représentent la variable d’analyse (nouveaux décès dus à la COVID-19), les barres étant les plus élevées dans les trois à quatre premiers décalages temporels, ce qui indique que le nombre de décès dans les trois à quatre jours précédents est plus prévisible que ceux des jours suivants. Même si ces données ne le montrent pas, il est possible qu’une variable se décale elle-même, telles que les variables cycliques comme la température, pour lesquelles le fait de regarder 24 heures avant est plus interessant d’un point de vue prévisionnel que de regarder 2 heures avant, compte tenu des cycles jour/nuit. Les barres en bleu ciel représentent le nombre de nouveaux vaccins administrés ce jour, les barres en bleu ciel les plus élevées apparaissant 10 à 14 jours en arrière dans la fenêtre temporelle (barres les plus à droite), ce qui indique que l’augmentation ou la diminution du nombre de vaccins a un impact sur le nombre de décès 10 à 14 jours plus tard. Ce décalage de 10 à 14 jours correspond au temps nécessaire pour développer le pic d’immuté après la vaccination.

Le diagramme Importance du décalage est inclus avec la table en sortie générée par le paramètre Table d’importance en sortie.

Pour l’échelle de modèle Localisation spécifique, la table contient une ligne pour chaque variable importante à chaque localisation. Le nombre de facteurs considérés comme importants à chaque emplacement dépend de la valeur du paramètre Seuil d’importance. Par exemple, si la valeur 15 est utilisée, les facteurs classés parmi les meilleurs 15 % à chaque emplacement sont inclus dans la table et le diagramme. La valeur par défaut est 10. Pour créer la table et le diagramme, vous devez inclure au moins une autre variable dans le paramètre Autres variables. Le nombre de décalages temporels dans la table et le diagramme est égal à la valeur du paramètre Fenêtre Phase, la fenêtre temporelle devant donc être plus large que les effets non immédiats que vous souhaitez capturer. Par exemple, une fenêtre temporelle d’une semaine ne pourrait pas permettre de capturer l’effet non immédiat des vaccins sur le nombre de décès dus à la COVID-19.

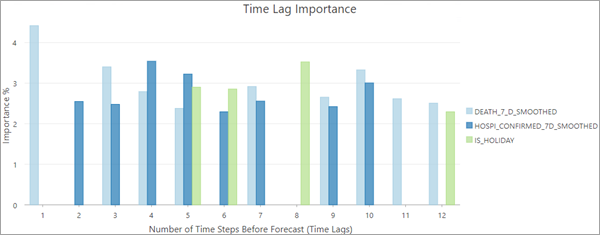

Pour l’échelle de modèle Cube entier, il n’est pas nécessaire de fournir d’autres variables pour créer la table et le diagramme. L’axe x du diagramme est le pourcentage d’importance brut (plutôt que le total des localisations qui dépassent un seuil) car toutes les localisations partagent le même modèle de prévision. L’image ci-dessous montre le diagramme Importance du décalage temporel pour une analyse de cube entier avec douze décalages temporels et trois variables :

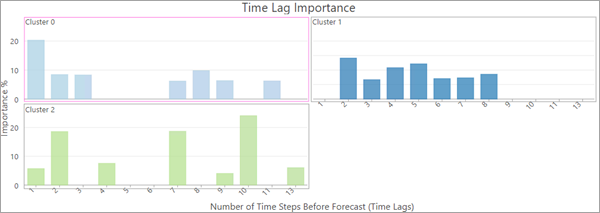

Pour l’échelle de modèle Agrégat de séries chronologiques, le diagramme est créé uniquement si aucune autre variable n’est fournie. Le diagramme affiche une grille de diagrammes séparés par un agrégat. L’image ci-dessous montre le paramètre Importance du décalage temporel pour trois agrégats de séries chronologiques :

Corrections en cas de faible variabilité

Si des variables utilisées dans l’analyse à un emplacement présentent une variabilité insuffisante, le modèle de prévision basée sur une forêt ne peut pas être entraîné et estimé à cet emplacement. Si la variable d’analyse est constante pour chaque intervalle temporel à un emplacement, ce dernier est exclu de l’entraînement ; la valeur constante est prévue à chaque intervalle temporel futur, et les intervalles de confiance ne sont pas inclus avec les prévisions.

Si l’emplacement compte au moins deux valeurs uniques dans la série chronologique, deux vérifications supplémentaires sont réalisées sur la variable d’analyse et sur toute autre variable. En premier lieu, pour tous les intervalles temporels de la série chronologique, déterminez la proportion contenant une valeur constante. Ensuite, uniquement pour les intervalles temporels qui n’ont pas été exclus pour la validation, déterminez la proportion contenant une valeur constante. Si l’une de ces proportions dépasse les deux-tiers, un peu de bruit aléatoire est ajouté aux valeurs pour créer de la variabilité dans la série chronologique, et les modèles de prévision et validation sont calculés à l’aide des nouvelles valeurs. Le bruit ajouté à chaque intervalle temporel est un nombre uniforme aléatoire compris entre 0 et 0,000001 (1e-6). Si la plage des valeurs de la série chronologique est inférieure à 0,001, le bruit est uniforme entre 0 et la valeur de plage multipliée par 1e-6.

Même avec l’ajout de bruit aléatoire, il est toujours possible que le modèle basé sur une forêt ne puisse pas être calculé après 30 tentatives. C’est fréquemment le cas pour les séries chronologiques très courtes.

Saisonnalité et choix d’une fenêtre horaire

Il est important de bien choisir le nombre d’intervalles temporels dans chaque fenêtre d’intervalles temporels pour le modèle de forêt. Il est primordial de savoir si la série chronologique affiche une saisonnalité où des modèles cycliques naturels se répètent sur un certain nombre d’intervalles temporels. Par exemple, la température affiche des cycles saisonniers annuels en fonction des saisons de l’année. Comme la fenêtre horaire est utilisée pour créer des variables explicatives et dépendantes associées, elle est plus efficace lorsque ces variables explicatives proviennent toutes du même cycle saisonnier de sorte qu’il y a aussi peu de corrélation saisonnière que possible entre les variables explicatives. Il est recommandé d’utiliser le nombre d’intervalles temporels dans une saison naturelle pour la durée de la fenêtre d’intervalles temporels. Si vos données affichent plusieurs saisons, il est recommandé d’utiliser la durée de la saison la plus longue.

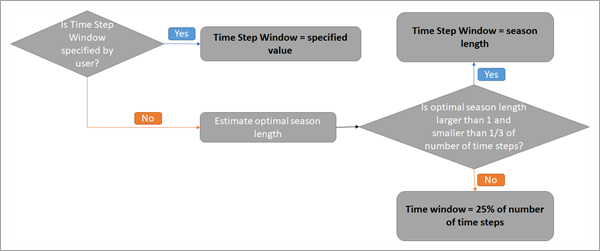

Si vous connaissez le nombre d’intervalles temporels correspondant à une saison dans vos données, vous pouvez le spécifier dans le paramètre Time Step Window (Fenêtre d’intervalles temporels). Cette valeur sera utilisée par chaque localisation dans le cube spatio-temporel. Si vous ne connaissez pas la durée d’une saison ou si cette durée est différente selon les localisations, vous pouvez ne pas renseigner la valeur du paramètre. Une durée de saison optimale est alors estimée pour chaque localisation à l’aide de la fonction de densité spectrale. Pour en savoir plus sur cette fonction, reportez-vous à la section Références supplémentaires.

Pour chaque localisation, si la durée optimale de la saison déterminée par l’analyse spectrale est supérieure à 1 et inférieure à un tiers du nombre d’intervalles temporels à la localisation, la fenêtre d’intervalles temporels est définie sur cette valeur optimale. Sinon, la localisation utilise 25 pour cent (valeur arrondie au nombre inférieur) du nombre d’intervalles temporels à la localisation pour la fenêtre d’intervalles temporels. Cela garantit que la fenêtre comporte au moins un intervalle temporel et qu’au moins trois cycles saisonniers complets sont utilisés comme variables explicatives. La valeur d’intervalle temporel utilisée au niveau de l’emplacement est enregistrée dans le champ Time Window des entités en sortie. Le champ Is Seasonal des entités en sortie contient la valeur 1 si la fenêtre d’intervalles temporels a été déterminée dans le cadre d’une analyse spectrale. Dans le cas contraire, sa valeur est 0. Ce processus est synthétisé sur l’image suivante :

Pour les échelles de modèle Cube entier et Agrégat de séries chronologiques, la fenêtre horaire par défaut correspond à 25 pour cent (arrondie au chiffre inférieur) du nombre d’intervalles temporels. Cela s’explique par le fait que différentes localisations présentent souvent un comportement saisonnier différent (par exemple, l’hiver commence dans certains endroits plus tôt que dans d’autres). Il n’est donc pas possible d’estimer et de partager une tendance saisonnière unique entre toutes les localisations du groupe.

Approches concernant la prévision

Vous pouvez représenter les valeurs des variables explicatives et dépendantes qui serviront à entraîner la forêt de quatre manières. Ces options sont spécifiées à l’aide du paramètre Forecast Approach (Approche concernant la prévision).

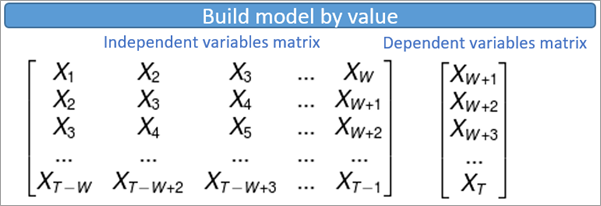

La première option est Build model by value (Construire un modèle par valeur). Cette option utilise les valeurs brutes dans les groupes spatio-temporels pour les variables explicatives et dépendantes. Lorsque vous sélectionnez cette option, les valeurs prévues sont contenues dans la plage des variables dépendantes. Vous ne devez donc pas utiliser cette option si vos données ont des tendances qui vous font penser que les valeurs vont continuer à augmenter ou à baisser. L’image ci-dessous montre les jeux de variables utilisées pour entraîner le modèle pour une seule localisation, où chaque ligne affiche le jeu de variables explicatives et la variable dépendante associée. T est le nombre d’intervalles temporels dans le cube spatio-temporel, W est le nombre d’intervalles temporels dans la fenêtre d’intervalles temporels, et Xt est la valeur brute de la série chronologique à l’instant t.

Remarque :

Pour les échelles de modèle Cube entier et Agrégat de séries chronologiques, Créer un modèle selon une valeur est la seule méthode de prévision disponible.

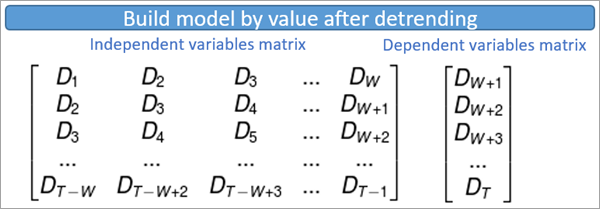

La deuxième option est Build model by value after detrending (Construire un modèle par valeur après décomposition). Il s’agit de l’option par défaut de l’outil. Cette option procède à une suppression de tendance de premier ordre (linéaire) sur l’ensemble de la série chronologique à chaque emplacement, et ces valeurs décomposées sont utilisées comme variables explicatives et dépendantes. Avec cette option, les prévisions suivent cette tendance dans le futur, ce qui permet d’estimer les valeurs prévues au-delà de la plage des variables dépendantes. L’image ci-dessous montre les jeux de variables utilisées pour entraîner le modèle pour une seule localisation, où chaque ligne affiche le jeu de variables explicatives et la variable dépendante associée. T représente le nombre d’intervalles temporels dans le cube spatio-temporel, W est le nombre d’intervalles temporels dans chaque fenêtre d’intervalles temporels et Xt est la valeur décomposée de la série chronologique à l’instant t.

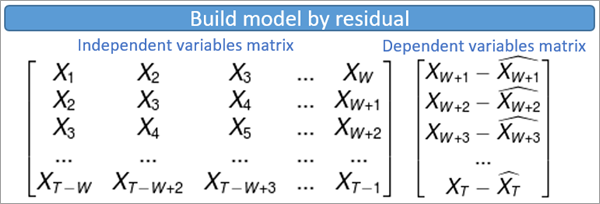

La troisième option est Build model by residual (Construire un modèle par résiduel). Cette option crée un modèle de régression des moindres carrés ordinaires pour prévoir la variable dépendante en fonction des variables explicatives au sein de chaque fenêtre horaire. Le résiduel de ce modèle de régression (la différence entre la prévision des moindres carrés ordinaires et la valeur brute de la variable dépendante) est utilisé pour représenter la variable dépendante lors de l’entraînement de la forêt. L’image ci-dessous montre les jeux de variables utilisées pour entraîner le modèle pour une seule localisation, où chaque ligne affiche le jeu de variables explicatives et la variable dépendante associée. T représente le nombre d’intervalles temporels dans le cube spatio-temporel, W est le nombre d’intervalles temporels dans chaque fenêtre d’intervalles temporels, Xt est la valeur de la série chronologique et à l’instant t et X^t (Xt-hat) est la valeur estimée à partir des moindres carrés ordinaires à l’instant t..

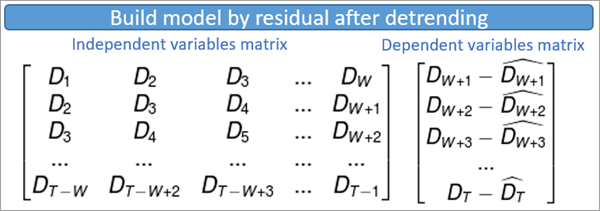

La dernière option est Build model by residual after detrending (Construire un modèle par résiduel après décomposition). Cette option opère d’abord une suppression de tendance (linéaire) de premier ordre sur l’ensemble de la série chronologique à une localisation. Elle construit ensuite un modèle de régression des moindres carrés ordinaires pour prévoir la variable dépendante décomposée en fonction des variables explicatives décomposées au sein de chaque fenêtre horaire. Le résiduel de ce modèle de régression (la différence entre la prévision des moindres carrés ordinaires et la valeur décomposée de la variable dépendante) est utilisé pour représenter la variable dépendante lors de l’entraînement de la forêt. L’image ci-dessous montre les jeux de variables utilisées pour entraîner le modèle pour une seule localisation, où chaque ligne affiche le jeu de variables explicatives et la variable dépendante associée. T représente le nombre d’intervalles temporels dans le cube spatio-temporel, W est le nombre d’intervalles temporels dans chaque fenêtre d’intervalles temporels, Dt est la valeur décomposée de la série chronologique et à l’instant t et D^t (Dt-hat) est la valeur estimée à partir des moindres carrés ordinaires à l’instant t..

Construire des intervalles de confiance

Si au moins deux intervalles temporels sont exclus pour la validation, l’outil calcule pour chaque intervalle temporel prévu des intervalles de confiance de 90 pour cent qui apparaissent sous forme de champs dans les entités en sortie et qui s’affichent dans les diagrammes contextuels décrits à la section Sorties de l’outil. L’outil construit les intervalles de confiance en estimant l’erreur standard de chaque valeur prévue et en créant des limites de confiance 1 645 erreurs standard au-dessus et au-dessous de chaque valeur prévue.

L’outil réalise les calculs suivants pour estimer les erreurs standard :

- Calculez l’EQM de validation des prévisions d’un intervalle en avant avec des fenêtres horaires de taille T pour prévoir les intervalles temporels exclus de la validation. L’EQM de validation des prévisions d’un intervalle en avant peut uniquement être calculé avec des fenêtres horaires qui n’ont pas servi à entraîner le modèle de prévision et qui comportent au moins un intervalle temporel après la fenêtre à prévoir. La première fenêtre horaire correspond aux intervalles temporels T finaux avant les intervalles temporels exclus, et elle prévoit le premier intervalle temporel exclu. La deuxième fenêtre horaire correspond aux intervalles temporels (T-1) finaux et au premier intervalle temporel exclu (la valeur renvoyée permet de calculer l’EQM), et elle prévoit le deuxième intervalle temporel exclu. La fenêtre horaire finale prévoit les intervalles temporels finaux à l’aide des intervalles temporels T précédents (renvoyés dans le jeu de données). Pour l’échelle de modèle de localisation spécifique, la prévision d’un intervalle en avant calcule l’EQM avec des valeurs M, pour les intervalles temporels M retenus pour validation. Pour les échelles de modèle de cube entier ou d’agrégat de séries chronologiques, chaque localisation du groupe apporte des valeurs M au calcul EQM d’un intervalle en avant.

- Calculez l’EQM de validation des prévisions de deux intervalles en avant également avec des fenêtres horaires dans les intervalles temporels exclus. Chaque fenêtre utilise la valeur prévue à l’étape 1 comme intervalle temporel final pour prévoir le prochain intervalle temporel exclu. Pour les prévisions de deux intervalles en avant, chaque localisation apporte des valeurs (M-1) au calcul EQM de deux intervalles en avant.

- Calculez l’EQM de validation des prévisions de K intervalles en avant, jusqu’à K=M. Chaque localisation utilise les valeurs prévues des calculs EQM de (K-1) intervalles en avant et apporte des valeurs (M-K+1) au calcul EQM. Le calcul EQM de M intervalles en avant final utilise une valeur par localisation.

- Ajustez un modèle de régression qui prévoit l’EQM de K intervalles en avant des localisations du groupe (ou de chaque localisation) avec log(K) comme variable explicative. Utilisez ce modèle pour estimer les erreurs standard pour tous les intervalles temporels futurs (toutes les valeurs de K), y compris les M premières valeurs prévues.

L’image ci-dessous illustre ce processus pour une analyse de cube entier avec trois intervalles temporels (M=3) retenus pour validation et une fenêtre horaire de quatre intervalles temporels (T=4).

Remarque :

Dans certains cas, la pente ou l’intersection estimées du modèle de régression prévoyant les erreurs standard peuvent être négatives. Si l’interception estimée est négative, le modèle est ajusté sans interception. Si la pente est négative, l’EQM maximale parmi les intervalles temporels retenus (localisation spécifique, agrégat de séries chronologiques ou cube entier) est utilisée comme erreur standard de toutes les valeurs prévues.

Identification des points aberrants des séries chronologiques

Les points aberrants dans les données de séries chronologiques sont des valeurs qui diffèrent significativement des modèles et des tendances des autres valeurs au sein des séries chronologiques. Par exemple, des nombres élevés d’achats en ligne au moment des congés ou des nombres élevés d’accidents de la circulation lors de pluies abondantes seraient probablement détectés comme des points aberrant dans leurs séries chronologiques. Les erreurs de saisie de données simples (par exemple, omettre la décimale d’un nombre) sont une autre source courante de points aberrants. Identifier les points aberrants dans les prévisions de séries chronologiques est important car ces points influencent le modèle de prévision utilisé pour prévoir les futures valeurs, et même un faible nombre de points aberrants dans les séries chronologiques d’un emplacement peut réduire significativement la précision et la fiabilité des prévisions. Les emplacements comportant des points aberrants, en particulier des points aberrants vers le début ou la fin des séries chronologiques, peuvent produire des prévisions trompeuses et identifier ces emplacements permet de déterminer le degré de confiance que vous devez avoir dans les valeurs prévues à chaque emplacement.

Les points aberrants ne sont pas déterminés que par leur valeur brute, mais plutôt par le degré auquel leurs valeurs diffèrent des valeurs ajustées du modèle de prévision. Cela signifie que le fait qu’une valeur soit ou non déterminée en tant que point aberrant est contextuel et dépend à la fois de l’emplacement et de l’heure de cette valeur. Le modèle de prévision définit ce que la valeur doit être en fonction de la série chronologique entière, et les points aberrants sont les valeurs qui s’écartent significativement de cette ligne de base. Par exemple, considérons une série chronologique des températures moyennes annuelles. Parce que les températures moyennes ont augmenté au cours des dernières décennies, le modèle de prévision ajusté de la température évoluera également dans le temps pour refléter cette augmentation. Cela signifie qu’une valeur de température qui serait considérée comme standard et non aberrante en 1950 serait probablement considérée comme un point aberrant en 2020. En d’autres termes, une température typique de 1950 serait considérée comme très basse selon les normes de 2020.

Vous pouvez choisir de détecter les points aberrants de séries chronologiques à chaque emplacement à l’aide du paramètre Identify Outliers (Identifier les points aberrants). S’il est spécifié, le test ESD (Extreme Studentized Deviate) généralisé est effectué pour chaque emplacement afin de tester les points aberrants de séries chronologiques. Le niveau de confiance du test peut être spécifié via le paramètre Level of Confidence (Niveau de confiance) et un niveau de confiance de 90 % est utilisé par défaut. Le test ESD généralisé teste de manière itérative un seul point aberrant, deux points aberrants, trois points aberrants, etc., à chaque emplacement jusqu’à la valeur du paramètre Maximum Number of Outliers (Nombre maximal de points aberrants) (par défaut, 5 % du nombre de pas de temps, arrondi), et le nombre de points aberrants statistiquement significatif le plus élevé est renvoyé. Le nombre de points aberrants à chaque emplacement est visible dans la table attributaire des entités en sortie, et les points aberrants individuels sont visibles dans les diagrammes contextuels de séries chronologiques abordés dans la section suivante.

Sorties de l'outil

La principale sortie de l’outil est une classe d’entités 2D montrant chaque emplacement dans la valeur Cube spatio-temporel en entrée symbolisée par l’intervalle temporel prévu final, les prévisions pour tous les autres intervalles temporels étant stockées sous forme de champs. Bien que chaque localisation soit prévue indépendamment et que les relations spatiales ne soient pas prises en compte, la carte peut afficher des modèles spatiaux pour des zones ayant des séries chronologiques similaires.

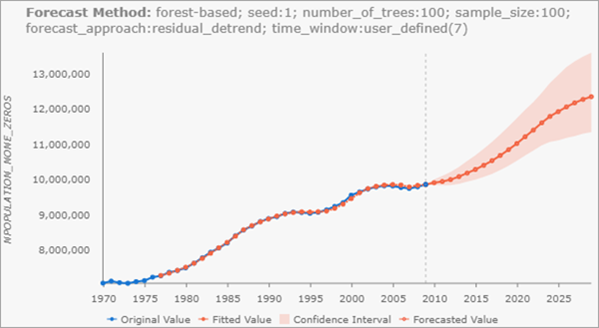

Diagrammes contextuels

Lorsque vous cliquez sur une entité de la carte à l’aide de l’outil de navigation Explore (Explorer), un diagramme s’affiche dans la fenêtre Pop-up (Fenêtre contextuelle). Cette fenêtre indique les valeurs du cube spatio-temporel avec le modèle de forêt ajusté, ainsi que les valeurs prévues avec des intervalles de confiance de 90 pour cent pour chaque prévision. Les valeurs du cube spatio-temporel apparaissent en bleu et sont reliées par une ligne bleue. Les valeurs ajustées apparaissent en orange et sont reliées par une ligne pointillée orange. Les valeurs prévues apparaissent en orange et sont reliées par une ligne unie orange qui représente la prévision du modèle de forêt. Chaque valeur prévue est entourée de limites de confiance en rouge clair. Vous pouvez survoler un point dans le diagramme pour afficher sa date et sa valeur. De plus, si vous choisissez de détecter les points aberrants dans les séries chronologiques, ces points s’affichent sous la forme de gros points de couleur pourpre.

Remarque :

Les diagrammes de fenêtre contextuelle ne sont pas créés lorsque les entités en sortie sont enregistrées en tant que shapefile (.shp). De plus, si les intervalles de confiance sortent du cadre du diagramme, un bouton Show Full Data Range (Afficher la plage de données entière) s’affiche au-dessus du diagramme pour vous permettre de développer le diagramme et d’afficher l’intervalle de confiance entier.

Messages de géotraitement

L’outil fournit un certain nombre de messages d’informations sur l’exécution de l’outil. Les messages comportent trois sections principales.

La section Input Space Time Cube Details (Détails du cube spatio-temporel en entrée) présente les propriétés du cube spatio-temporel en entrée, ainsi que des informations sur le nombre d’intervalles temporels, le nombre de localisations et le nombre de groupes spatio-temporels. Les propriétés affichées dans cette première section dépendent de la façon dont le cube a été créé à l’origine, de sorte que les informations varient d’un cube à l’autre.

La section Détails de l’analyse affiche les propriétés des résultats de la prévision, y compris le nombre d’intervalles temporels prévus, le nombre d’intervalles temporels exclus pour la validation, le pourcentage d’emplacements où la saisonnalité a été détectée par analyse spectrale, et les informations relatives aux intervalles temporels prévus. Si aucune valeur n’est fournie pour le paramètre Time Step Window (Fenêtre intervalles temporels), des statistiques de synthèse de la fenêtre d’intervalles temporels estimée s’affichent, notamment le minimum, le maximum, la moyenne, la médiane et l’écart type.

La section Summary of Accuracy across Locations (Récapitulatif de la précision pour chaque emplacement) affiche un résumé statistique pour l’EQM de prévision et l’EQM de validation pour tous les emplacements. Pour chaque valeur, le minimum, le maximum, la moyenne, la médiane et l’écart type sont affichés.

La section Summary of Time Series Outliers (Synthèse des points aberrants de séries chronologiques) apparaît si vous choisissez de détecter les points aberrants de séries chronologiques à l’aide du paramètre Outlier Option (Option de point aberrant). Cette section affiche des informations telles que le nombre et le pourcentage d’emplacements contenant des points aberrants, le pas de temps contenant le plus de points aberrants et des statistiques récapitulatives du nombre de points aberrants par emplacement et par pas de temps.

Remarque :

Les messages de géotraitement apparaissent au bas de la fenêtre Geoprocessing (Géotraitement) pendant l’exécution de l’outil. Vous pouvez accéder aux messages en survolant la barre de progression, en cliquant sur le bouton contextuel  ou en développant la section des messages dans la fenêtre Géotraitement. Vous pouvez également consulter les messages de l’exécution précédente d’un outil dans l’historique de géotraitement.

ou en développant la section des messages dans la fenêtre Géotraitement. Vous pouvez également consulter les messages de l’exécution précédente d’un outil dans l’historique de géotraitement.

Champs des entités en sortie

Outre les champs de géométrie Object ID (ID d’objet) et le champ contenant les diagrammes contextuels, les Output Features (Entités en sortie) comprendront les champs suivants :

- ID d’emplacement (LOCATION) : ID de l’emplacement correspondant du cube spatio-temporel.

- Prévision de (variable d’analyse) pour (intervalle temporel) (FCAST_1, FCAST_2, etc.) : Valeur prévue de chaque intervalle temporel futur. L’alias du champ affiche le nom de la Analysis Variable (Variable d’analyse) et la date de la prévision. Un champ de ce type est créé pour chaque pas de temps prévu.

- Intervalle élevé de (variable d’analyse) dans (intervalle temporel) (HIGH_1, HIGH_2, etc.) : limite supérieure d’un intervalle de confiance de 90 pour cent pour la valeur prévue de chaque intervalle temporel futur. L’alias du champ affiche le nom de la Analysis Variable (Variable d’analyse) et la date de la prévision. Un champ de ce type est créé pour chaque pas de temps prévu.

- (Intervalle faible de (variable d’analyse) dans (intervalle temporel)) (LOW_1, LOW_2, etc.) : limite inférieure d’un intervalle de confiance de 90 pour cent pour la valeur prévue de chaque intervalle temporel futur. L’alias du champ affiche le nom de la Analysis Variable (Variable d’analyse) et la date de la prévision. Un champ de ce type est créé pour chaque pas de temps prévu.

- Racine carrée de l’erreur quadratique moyenne de prévision (F_RMSE) : l’EQM de prévision.

- Racine carrée de l’erreur quadratique moyenne de validation (V_RMSE) : l’EQM de validation. Si aucun pas de temps n’a été exclu pour la validation, ce champ n’est pas créé.

- Fenêtre temporelle (TIMEWINDOW) : fenêtre d’intervalles temporels utilisée à la localisation.

- Saisonnier (IS_SEASON) : variable booléenne indiquant si la fenêtre d’intervalles temporels à la localisation a été déterminée par densité spectrale. La valeur 1 indique qu’une saisonnalité a été détectée par densité spectrale et la valeur 0 indique qu’aucune saisonnalité n’a détectée. Si une valeur est spécifiée dans le paramètre Time Window (Fenêtre horaire), toutes les localisations ont la valeur 0 dans ce champ.

- Méthode de prévision (METHOD) : champ de texte affichant les paramètres du modèle de forêt, notamment la valeur initiale aléatoire, le nombre d’arbres, la taille d’échantillonnage, l’approche de prévision et si la fenêtre d’intervalles temporels a été spécifiée par l’utilisateur ou définie par l’outil, d’autres variables éventuelles et des informations sur l’échelle de modèle et la variabilité de l’agrégat (le cas échéant). Ce champ peut servir à reproduire des résultats et vous permet d’identifier les modèles qui sont utilisés dans l’outil Évaluer les prévisions par localisation.

- Number of Model Fit Outliers (Nombre de points aberrants ajustés de modèle) (N_OUTLIERS) : nombre de points aberrants détectés dans la série chronologique de l’emplacement. Ce champ n’est créé que si vous choisissez de détecter les points aberrants à l’aide du paramètre Outlier Option (Option de point aberrant).

Cube spatio-temporel en sortie

Si un Output Space Time Cube (Cube spatio-temporel en sortie) est spécifié, le cube en sortie contient toutes les valeurs d’origine du cube spatio-temporel en entrée auxquelles sont jointes les valeurs prévues. Ce nouveau cube spatio-temporel peut être affiché à l’aide des outils Visualiser le cube spatio-temporel en 2D ou Visualiser le cube spatio-temporel en 3D et peut être utilisé en entrée pour les outils de la boîte d’outils Exploration des modèles spatio-temporels, comme Analyse de points chauds émergents et Agrégation de séries chronologiques.

Il est possible de comparer et fusionner plusieurs cubes spatio-temporels prévus à l’aide de l’outil Évaluer les prévisions par emplacement. Cela vous permet de créer plusieurs cubes de prévision à l’aide de différents outils et paramètres de prévision ; l’outil identifie ensuite la meilleure prévision pour chaque emplacement en utilisant soit l’EQM de prévision soit l’EQM de validation.

Pratiques conseillées et limitations

Pour savoir si cet outil est adapté à vos données et quels paramètres utiliser, tenez compte des points suivants :

- Par rapport aux autres outils de prévision du jeu d’outils Prévision des séries chronologiques, cet outil est le plus compliqué, mais c’est également celui qui émet le moins d’hypothèses sur les données. Il est recommandé pour les séries chronologiques avec des formes et tendances compliquées, qui sont difficiles à modéliser avec des fonctions mathématiques simples ou lisses. Il est également recommandé lorsque les hypothèses d’autres méthodes ne sont pas satisfaites.

- Cet outil peut servir à explorer différentes échelles de modèle et les interactions entre différentes variables de séries chronologiques. Il est recommandé d’exécuter l’outil plusieurs fois avec différentes échelles et d’autres variables, et d’utiliser l’outil Évaluer les prévisions par localisation pour choisir les meilleures prévisions pour chaque localisation.

Il est important de déterminer la valeur du paramètre Nombre d’intervalles temporels à exclure pour la validation. Plus le nombre d’intervalles temporels exclus est important, moins il reste d’intervalles temporels pour estimer le modèle de validation. Cependant, en excluant trop peu de pas de temps, l’estimation de l’EQM de la validation utilise une petite quantité de données et peut être trompeuse. Il est recommandé d’exclure autant d’intervalles temporels que possible tout en en conservant un nombre suffisant pour estimer le modèle de validation. Il est également recommandé de retenir au moins autant de pas de temps pour la validation que le nombre de pas de temps que vous avez l’intention de prévoir, pour autant que votre cube spatio-temporel a suffisamment de pas de temps pour le permettre.

En outre, la construction d’intervalles de confiance pour les valeurs prévues nécessite l’ajustement d’une fonction de régression aux intervalles temporels retenus pour validation. Comme au moins deux valeurs sont nécessaires pour ajuster cette fonction, au moins deux intervalles temporels doivent être retenus pour créer les intervalles temporels des prévisions. Cependant, l’exactitude de la fonction de régression est plus élevée (ce qui génère des intervalles de confiance plus précis) si le nombre d’intervalles temporels retenus est important. Pour des intervalles de confiance les plus précis possible, il est recommandé de retenir au moins la valeur par défaut de 10 pour cent des intervalles temporels pour validation.

- Cet outil peut générer des prévisions instables et non fiables lorsque la même valeur est répétée plusieurs fois dans la même série chronologique. On trouve fréquemment des valeurs identiques répétées dans les cas d’inflation nulle, où vos données représentent des totaux et où un grand nombre d’intervalles temporels ont la valeur 0.

- Si vous choisissez d’identifier les points aberrants, il est recommandé d’attribuer une valeur au paramètre Time Step Window (Fenêtre de pas de temps) au lieu de le laisser vide et d’estimer une fenêtre de pas de temps différente à chaque emplacement. Pour chaque emplacement, le modèle de forêt utilise les phases dans la première fenêtre de phase pour entraîner le modèle de forêt et les points aberrants sont détectés uniquement pour les phases restantes. Si des emplacements différents excluent des nombres de phases différents pour l’entraînement, les résumés statistiques, tels que la moyenne, et les nombres minimum et maximum de points aberrants par phase ou par emplacement, peuvent être trompeurs. Ces statistiques ne sont calculées que pour les pas de temps ayant été inclus à chaque emplacement.

Ressources supplémentaires

Pour plus d’informations sur les modèles de forêt, consultez les références suivantes :

- Breiman, Leo. (2001). « Random Forests. » Machine Learning 45 (1) : 5-32. https://doi.org/10.1023/A:1010933404324.

- Breiman, L., J.H. Friedman, R.A. Olshen, and C.J. Stone. (2017). Classification and regression trees. New York: Routledge. Chapitre 4

Pour plus de ressources et de références sur les modèles de forêt, reportez-vous à la rubrique Fonctionnement de l’outil Classification et régression basées sur une forêt.

Pour plus d’informations sur la fonction de densité spectrale utilisée pour estimer la durée des fenêtres temporelles, reportez-vous à la fonction findfrequency dans les références suivantes :

- Hyndman R, Athanasopoulos G, Bergmeir C, Caceres G, Chhay L, O'Hara-Wild M, Petropoulos F, Razbash S, Wang E, and Yasmeen F (2019). « Forecasting functions for time series and linear models. » R package version 8.7,https://pkg.robjhyndman.com/forecast.

- Hyndman RJ et Khandakar Y (2008). « Automatic time series forecasting: the forecast package for R. » Journal of Statistical Software, 26(3), pp. 1-22. https://www.jstatsoft.org/article/view/v027i03.

Pour plus d’informations relatives à l’inclusion de variables explicatives et à l’effet non immédiat, consultez la référence ci-dessous :

- Zheng, H., and Kusiak, A. (2009). "Prediction of Wind Farm Power Ramp Rates: A Data-Mining Approach."ASME. J. Sol. Energy Eng, 131(3): 031011. https://doi.org/10.1115/1.3142727.

Rubriques connexes

Vous avez un commentaire à formuler concernant cette rubrique ?